Posts

Tempor est exercitation ad qui pariatur quis adipisicing aliquip nisi ea consequat ipsum occaecat. Nostrud consequat ullamco laboris fugiat esse esse adipisicing velit laborum ipsum incididunt ut enim. Dolor pariatur nulla quis fugiat dolore excepteur. Aliquip ad quis aliqua enim do consequat.

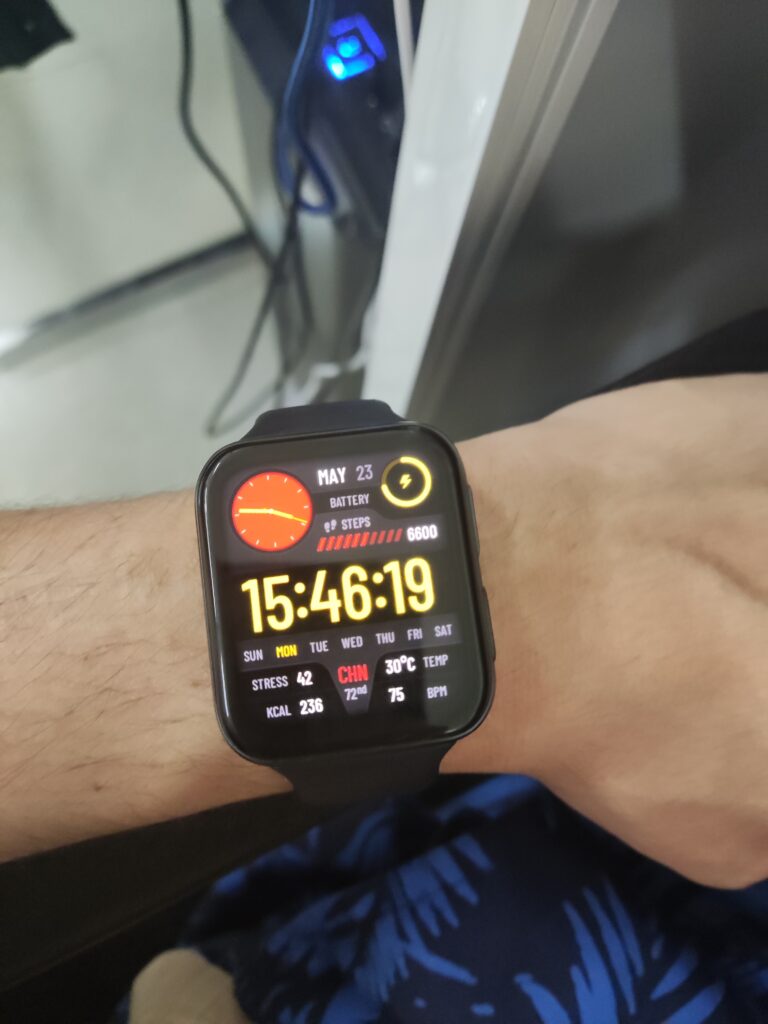

喜欢周末上班的感觉

相比weekday工作,我觉得weekend一个人来公司加班更舒服。

平时太多人找我了,想做个东西,时不时就会有人有事找,你不得不停下手上的工作去做其他事,周末工作就舒服多了,不用担心有人找,你就安安心心做自己的事就行,公司也太多其他人,也不吵,非常安静,非常舒服。

唯一不舒服的可能是义务加班,没加班费,但也还好,反正也没其他事,反正心也乱

今天上午改了一些代码,就想着要不出去转转,梁子湖不远不近,就去那吧,看了下三四十公里,骑小摩托大概五十分钟能到,反正心乱,去转转。

过去骑一路挺舒服,路平又宽,还没多少车,一路听着音乐很快就到了。

梁子湖比我想象的好看,也比我想的更开放,周边很多露营骑车钓鱼的,人多但干净,尤其是湖面水天相接让我很是震撼。绕着转了两圈,还专门修的环胡路,意犹未尽

我还说在地图上看梁子湖那么大,结果回来看了下手机记录,发现我就在它的一个稍小的子湖边上溜达了一下,甚至没有完整绕小湖转一圈,甚至离小湖转一圈还差的远,不过也骑了90公里

下次可以开着地图再绕,看能绕多久

还得学

AI 目前并不会减少你掌握新技能所需要付出的努力,只会让你产生不必学习就已经学会的错觉。

一切都还早

一切都还早,一切皆有可能,30了

乌合之众

我担心,以后在重要的媒体中,实质性内容将逐渐衰落,30秒的片段会流行,节目只具有最低的共识,充斥着对伪科学和迷信的盲目介绍,尤其还有一种对无知的庆祝。

– 卡尔·萨根,美国著名科普作家,这段话写于1994年

哀其不幸怒其不争

每天不知道自己在做什么,脑子一堆想做的事,就是不去做。我的脑子里充满了悔恨、遗憾、焦虑、害怕,我以为上班了会好点,还是那么煎熬,我想让时间能快点,但是又怕时间过得太快。

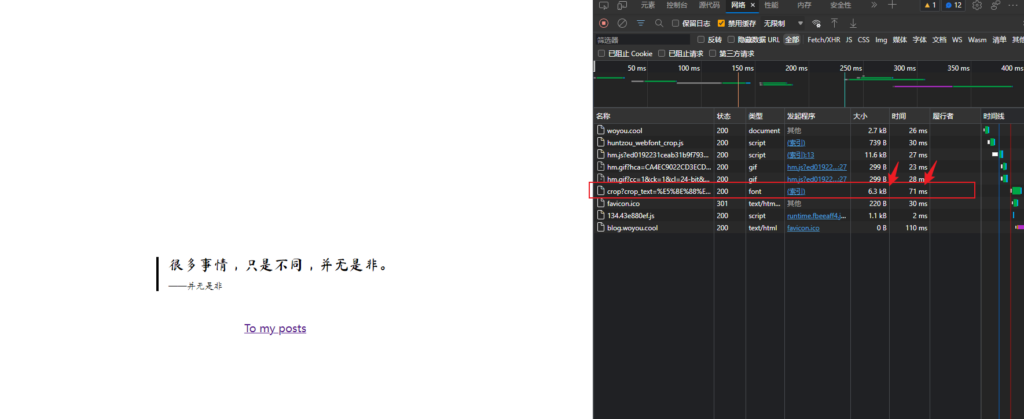

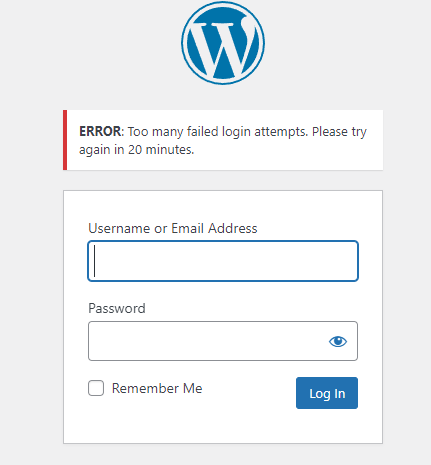

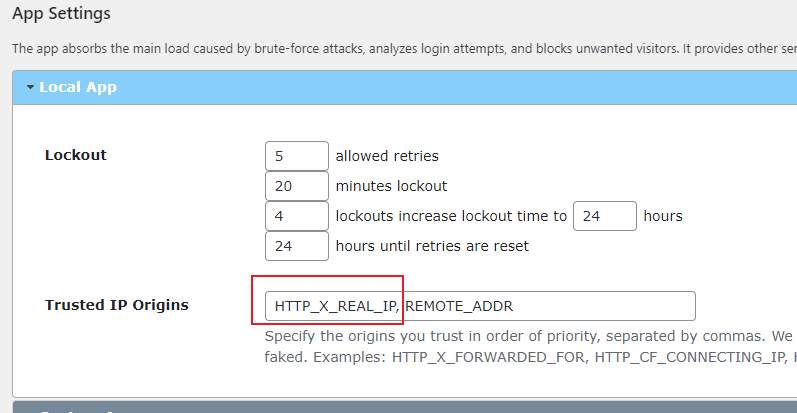

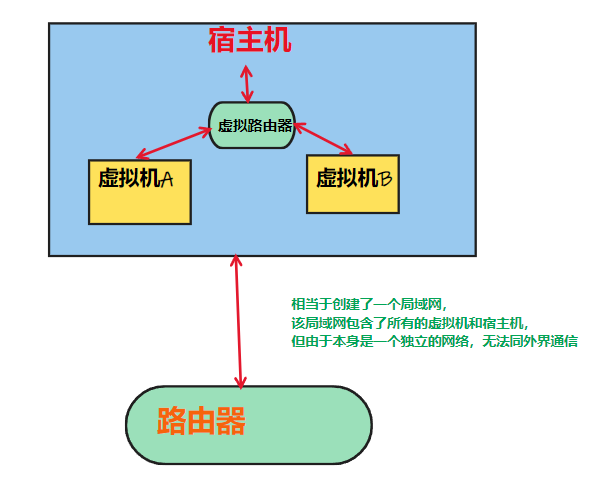

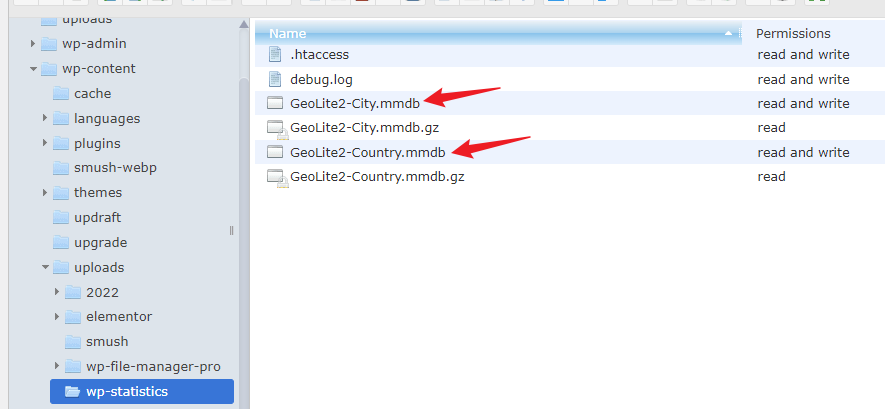

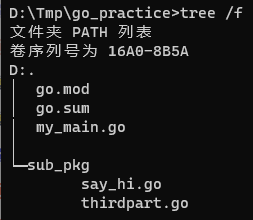

从worldpress迁移到hugo

blog平台从worldpress迁移到hugo了

仓鼠死了

去年五一买的仓鼠老公公昨晚回去发现死了,很愧疚,很内疚,可能是被我饿死的,也可能是又饿又冷死的,总之是我的问题。

年后好像就给了一勺粮,之前没收拾房间,想着这周收拾房间的时候给它打理打理,没想到就差这两天。我记得前天它还跑得欢,怪我,不应该那么随意。

买这个仓鼠的时候还有个老婆婆,不过第二天就死了,当时没喂养的设备,以为是渴死的,现在想想,应该不至于。

之前放房间味道太大,放到阳台了,阳台并不很开放,不过毕竟是寒冬腊月。

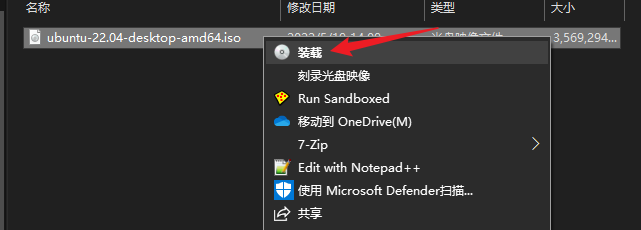

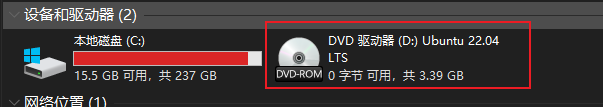

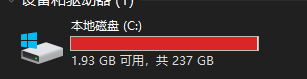

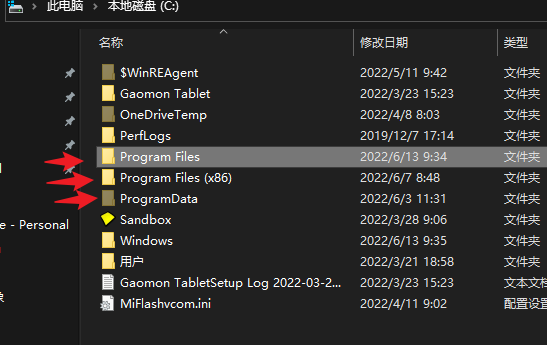

小米笔记本安装飞牛nas系统fnos

最近打算买个nas,先体验一下,正巧最近fnos到处推广,试一下

我先是在虚拟机上安装后试了下,觉得挺顺手的,功能也不复杂,也许是因为我没用过nas

小米笔记本安装过程也简单,我的笔记本是小米air13.3的那个。

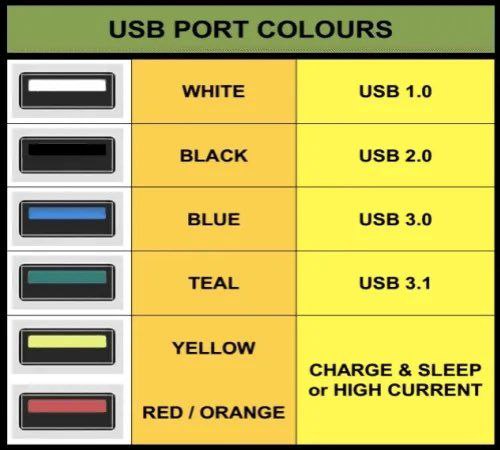

准备一个U盘、fnos系统iso镜像,使用balenaEtcher或refus制作U盘启动盘,插入电脑

!!!同时将手机使用数据线连接上笔记本,并且打开手机的usb共享网络功能,因为fnos安装时使用不了该笔记本的无线网卡!!!

电脑启动时不停按f12,进入启动选项,选择U盘启动方式

然后按照fnos的指引安装即可。这里如果没有使用手机的usb共享网络,在选择网卡列表时就会为空。

安装完成后拔掉U盘,电脑重启,注意此时也要保持手机的usb共享网络开启状态,重启时可能会断,还得打开

直到系统启动,看到终端显示了访问的http地址,然后在手机上打开该地址,创建一个账户

账户创建完成后就可以断开手机的usb共享网络了

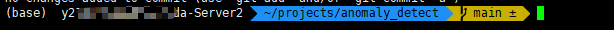

然后在终端登录刚才创建的账户,接着执行以下命令:

# 切换为 root 用户

sudo -i

# 查看wifi列表

nmcli device wifi list

# 连接某个wifi

nmcli device wifi connect "Wi-Fi名称" password "密码"

此时就可以用连接同一路由器的电脑的浏览器访问fnos的ip了。

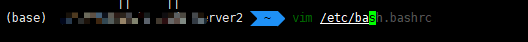

但此时还有个问题就是当笔记本屏幕合上时,fnos就休眠无法访问了。解决方法是:

fnos终端登录你的用户,然后输入命令 sudo vim /etc/systemd/logind.conf,找到有一行为 HandleLidSwitch=suspend,将它的值修改为 ignore ,重启系统即可。

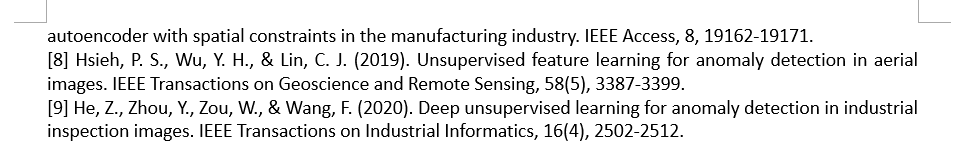

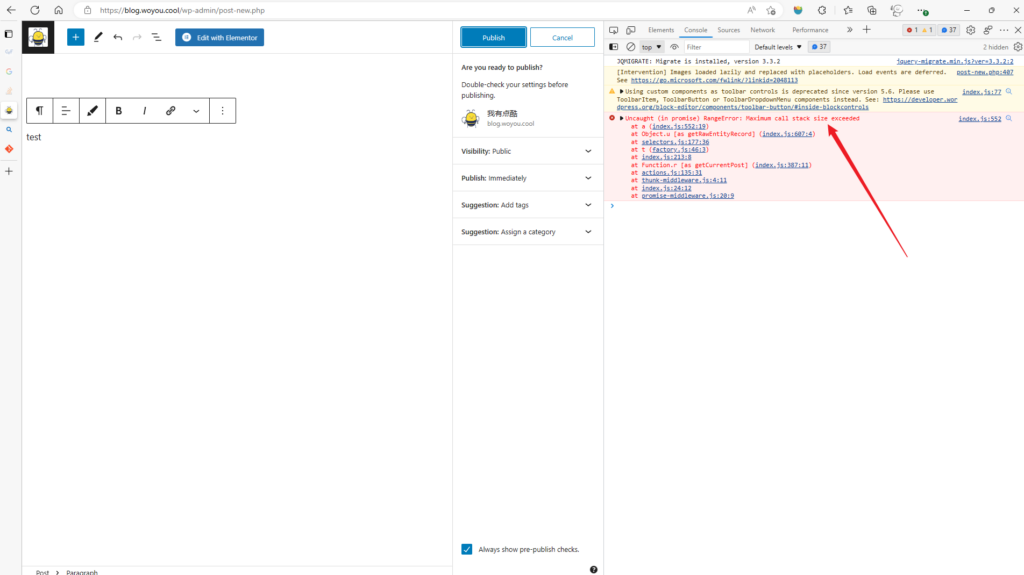

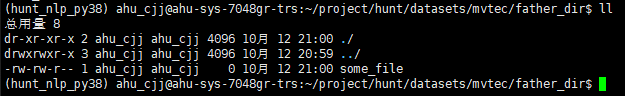

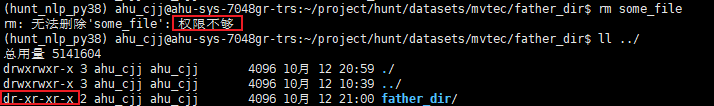

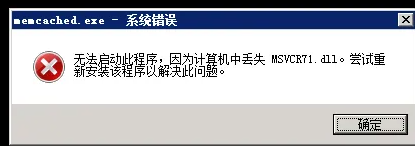

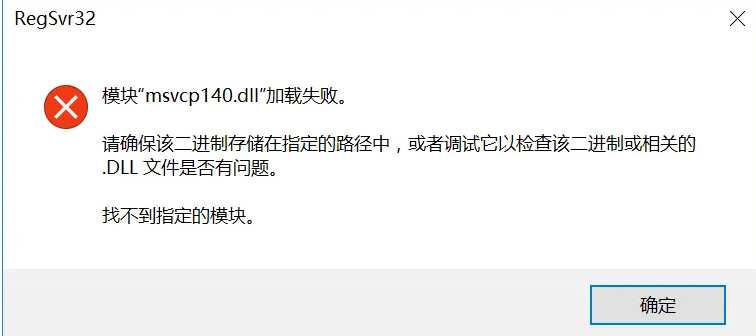

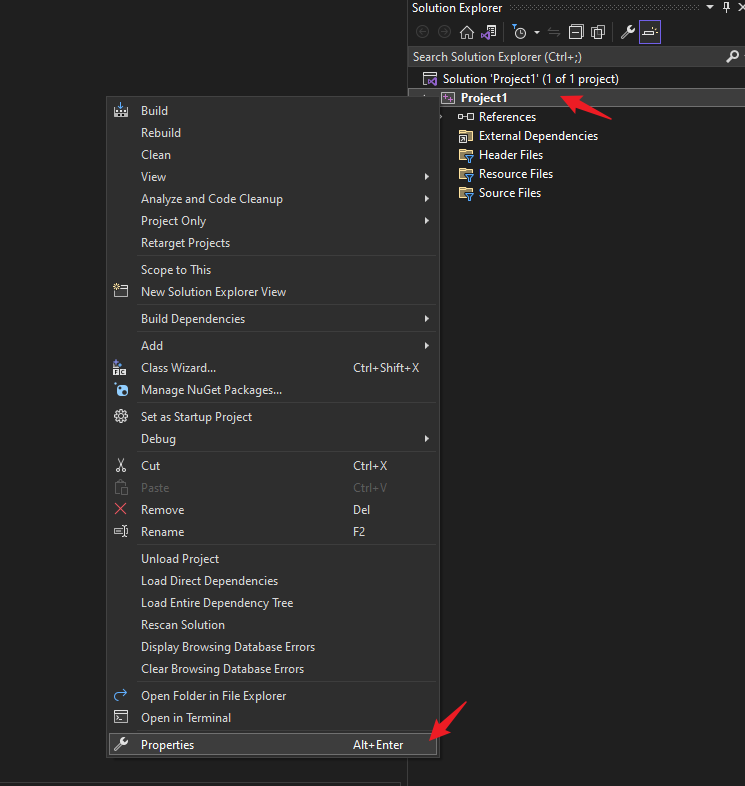

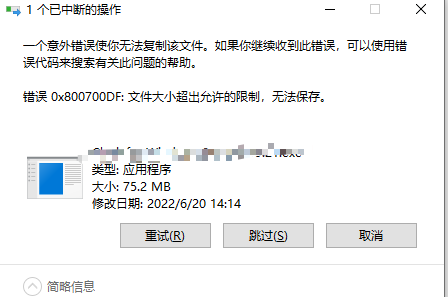

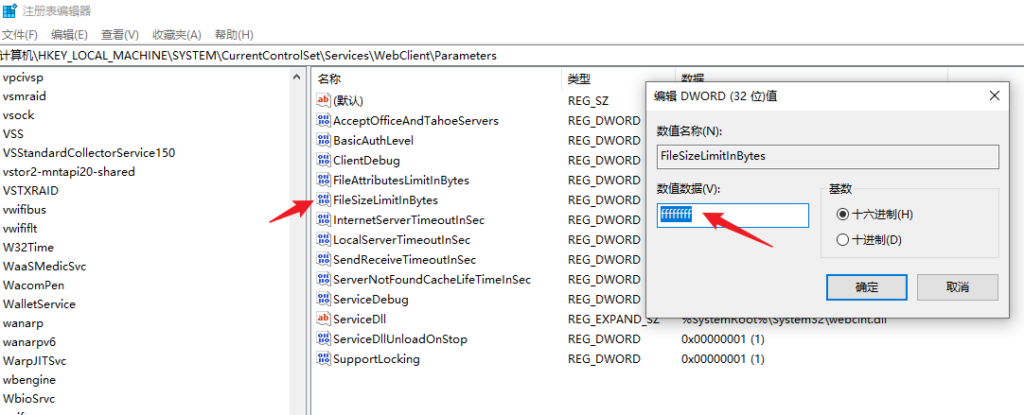

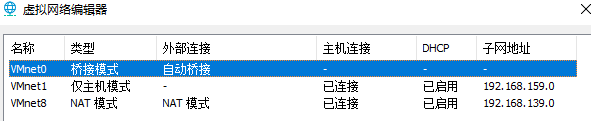

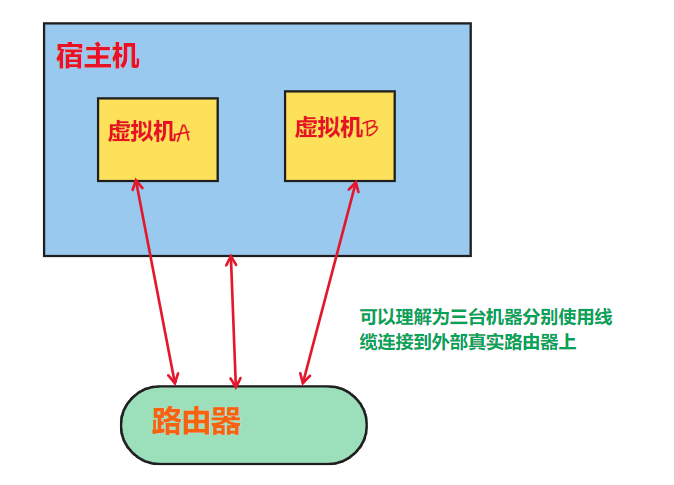

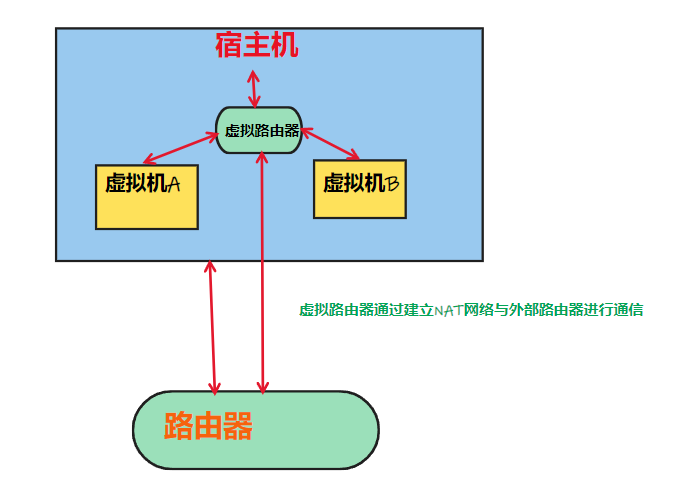

VMware启动虚拟机报错

症状

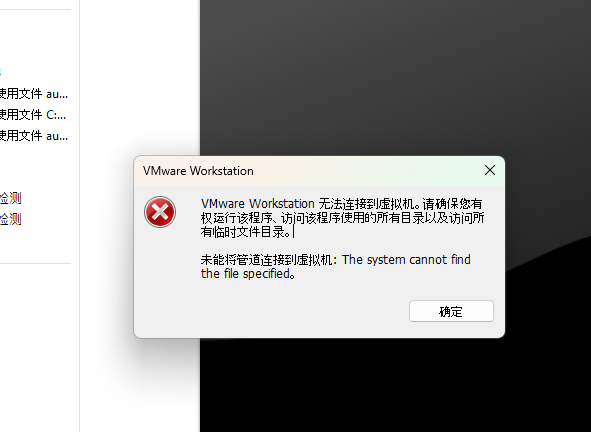

创建完虚拟机后,启动虚拟机报错:

VMware Workstation 无法连接到虚拟机。请确保您有权运行该程序、访问该程序使用的所有目录以及访问所有临时文件目录。

未能将管道连接到虚拟机: The system cannot find the file specified。

如果以管理员启动VMware,启动虚拟机会报错:The Code execution cannot proceed because ResampleDmo.DLL was not found.

点击 OK 后继续弹出错误:VMware Workstation 无法连接到虚拟机。

治标

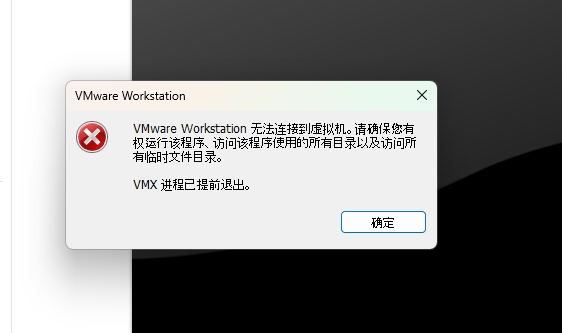

根据提示,说缺少 ResampleDmo.DLL 动态库文件,所以去下载该文件:

进入网址:https://www.dll-files.com

搜索 ResampleDmo

找到符合系统条件的包,点击下载

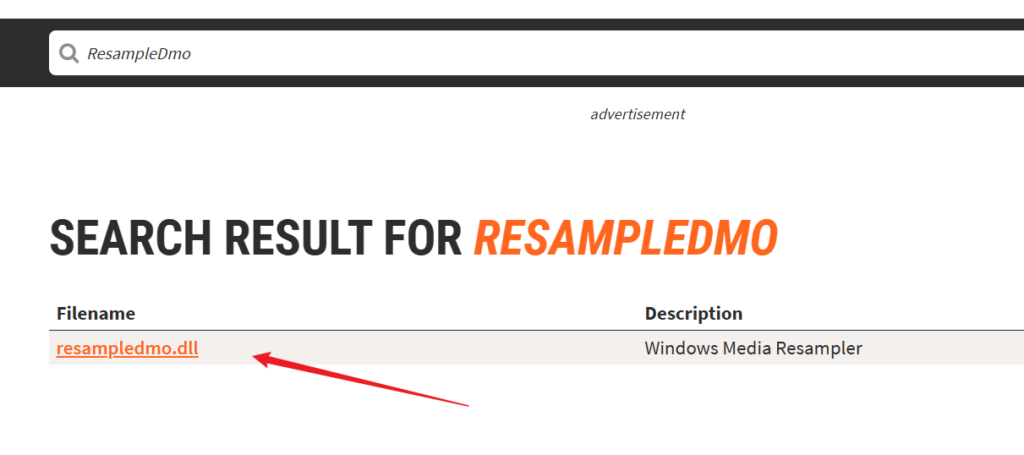

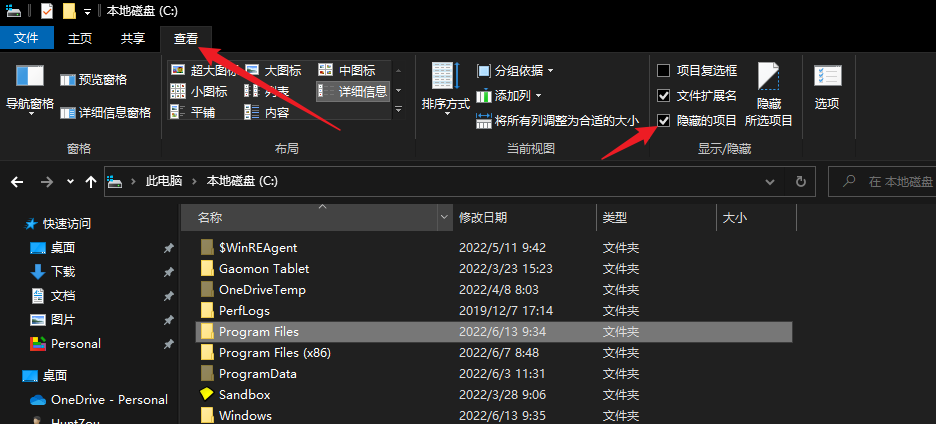

下载后解压,将得到的dll文件放到 C:\Windows\System32 目录下:

然后再次尝试启动VMware即可。我这里仍然是报错的,然后使用管理员方式启动后报缺少 mfplat.dll 文件,按照同样的方法下载安装后虚拟机就能正常启动了。

治本

我安装的是 Windows 11 Pro N,这个N是一个特殊的版本,它比正常的版本会少一些东西,其中就包含 Media Feature Pack 这个软件包,上面说的那两个dll就属于这个软件包的。

所以,另一种更优雅的解决方法是安装 Media Feature Pack

点击 setting -> System -> Optional features

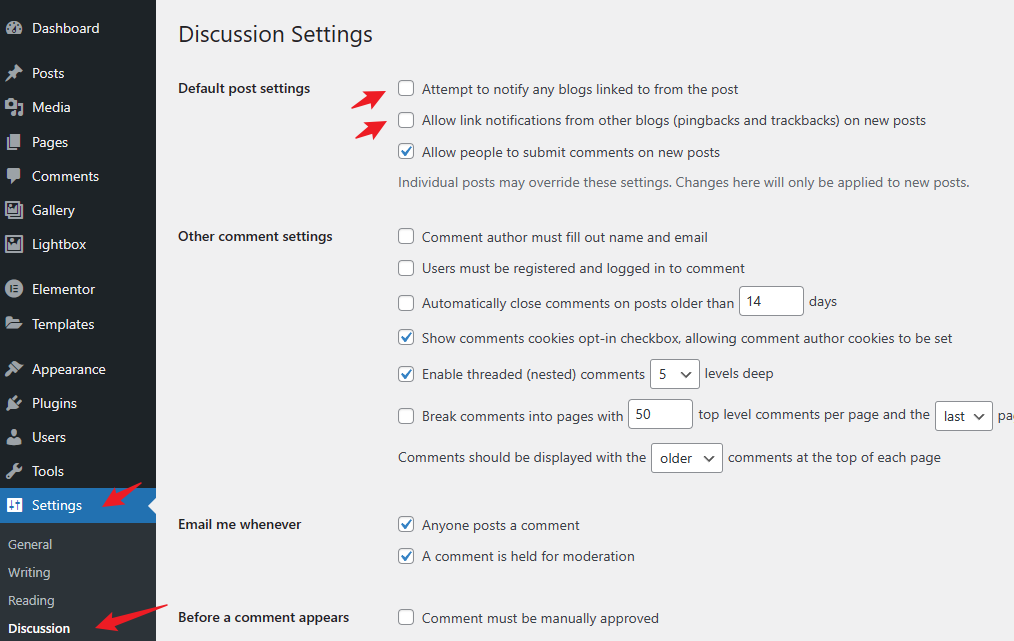

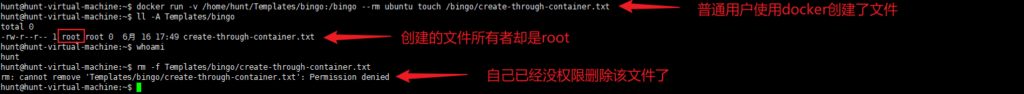

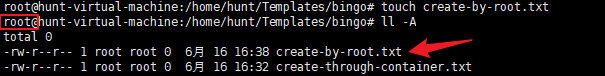

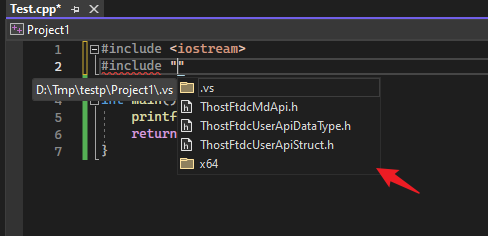

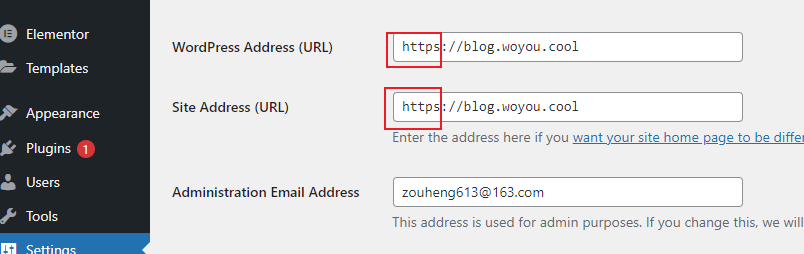

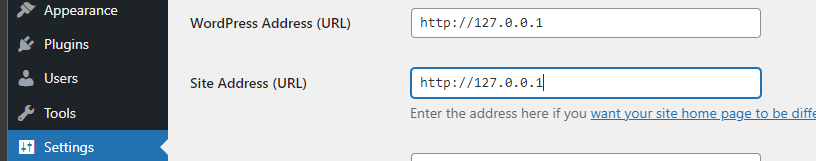

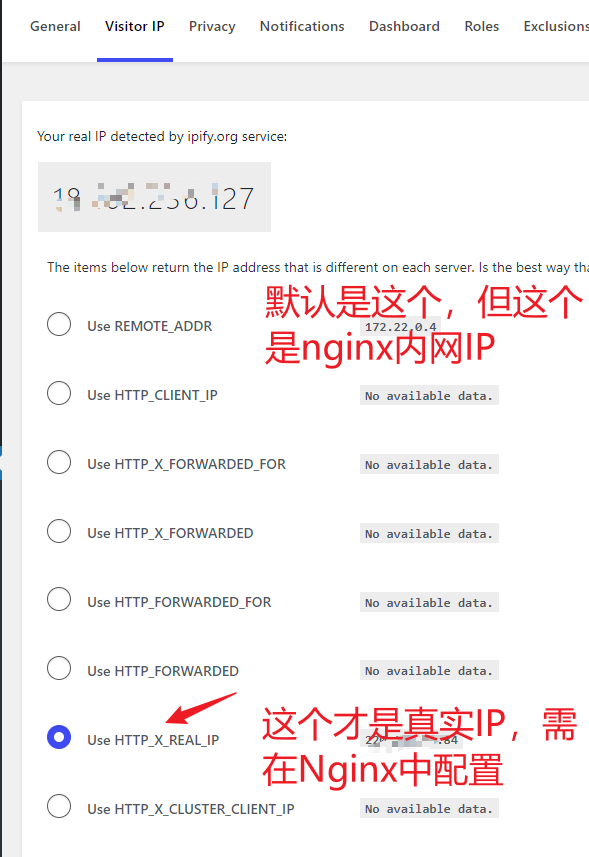

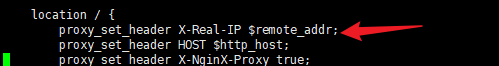

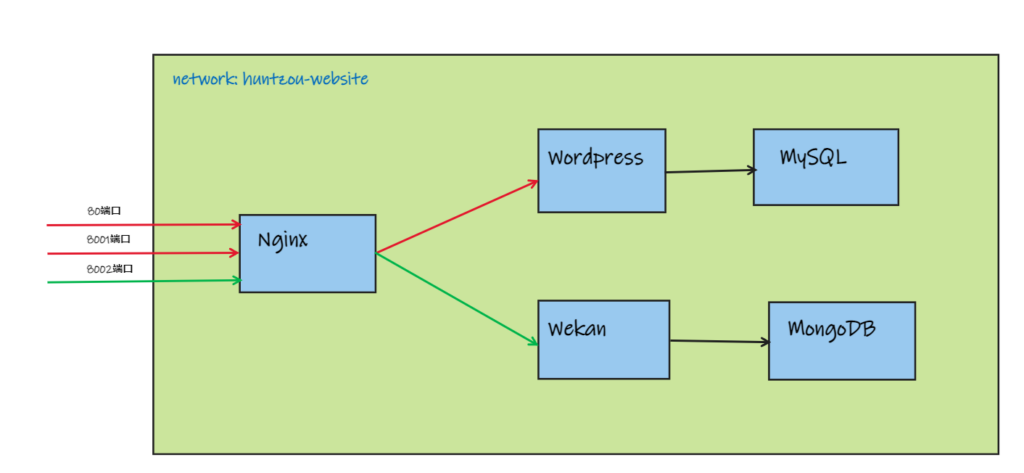

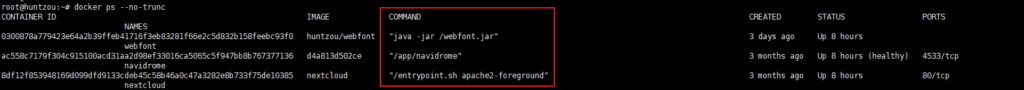

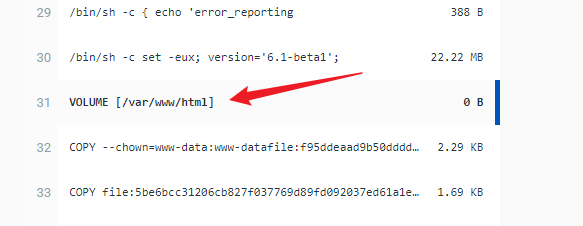

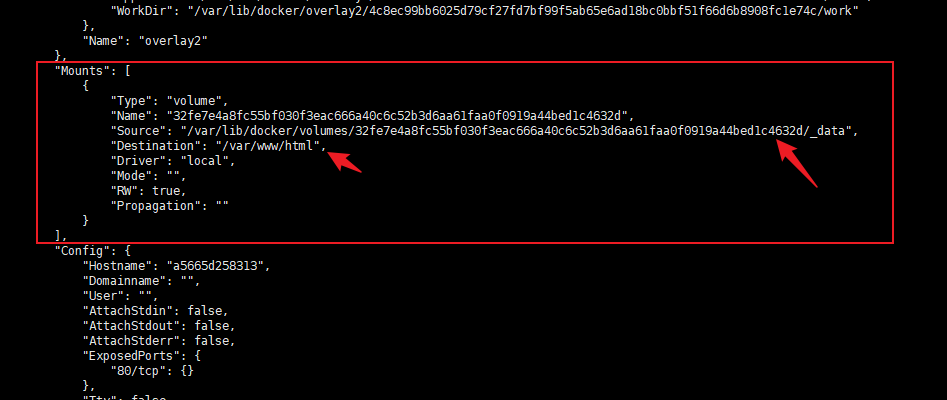

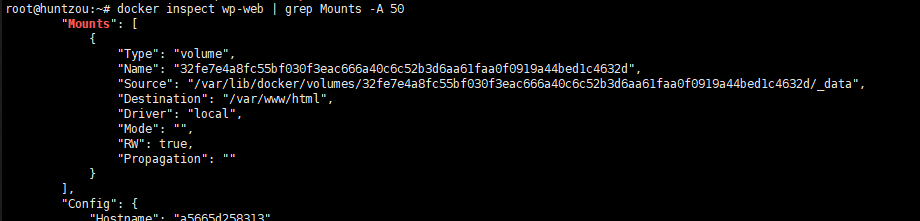

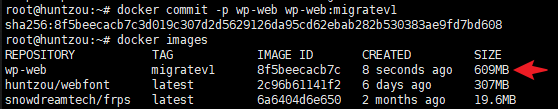

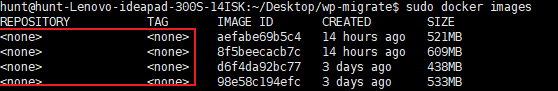

docker环境下wordpress迁移并更换域名

先执行docker inspect xxx找到 Mount 部分,将挂载的 /var/www/html 目录打包(或者直接使用docker cp命令将该目录复制出来再打包也一样)

mysql容器也是一样,将 /var/lib/mysql 目录进行打包

打包后的两个文件复制到新的机器上解压,分别重命名为 html 和 mysql(命名随便)

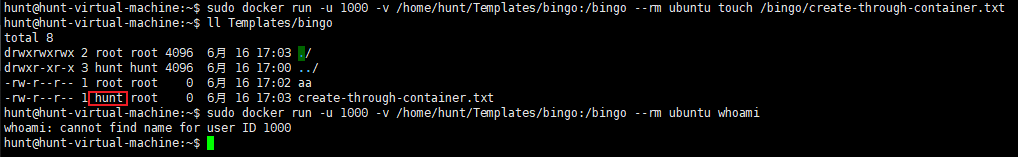

使用 docker run ... -v xxx:xxx -u "1000:1000" xxx 或者docker-compose的方式启动wordpress和mysql,docker-compose.yml如下:

version: '3.1'

services:

wordpress:

image: wordpress

container_name: wordpress-web

restart: unless-stopped

user: "1000:1000"

networks:

- huntzou_website

environment:

WORDPRESS_DB_HOST: wordpress-db

WORDPRESS_DB_USER: xxx

WORDPRESS_DB_PASSWORD: xxx

WORDPRESS_DB_NAME: wp_db

WORDPRESS_TABLE_PREFIX: wp

volumes:

- /home/hunt/Documents/docker_properties/wordpress/html:/var/www/html

- /etc/localtime:/etc/localtime

mysql:

image: mysql

container_name: wordpress-db

user: "1000:1000"

restart: unless-stopped

networks:

- huntzou_website

#command: --default-authentication-plugin=mysql_native_password

environment:

MYSQL_DATABASE: wp_db

MYSQL_ROOT_PASSWORD: zh613

volumes:

- /home/hunt/Documents/docker_properties/wordpress/mysql:/var/lib/mysql

- /etc/localtime:/etc/localtime

networks:

huntzou_website:

external: true

其中-v的挂载目录就是打包的那个目录,挂载点和原主机挂载点相同。

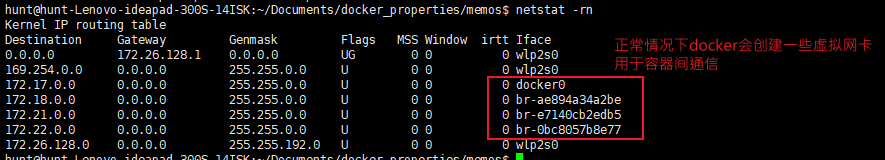

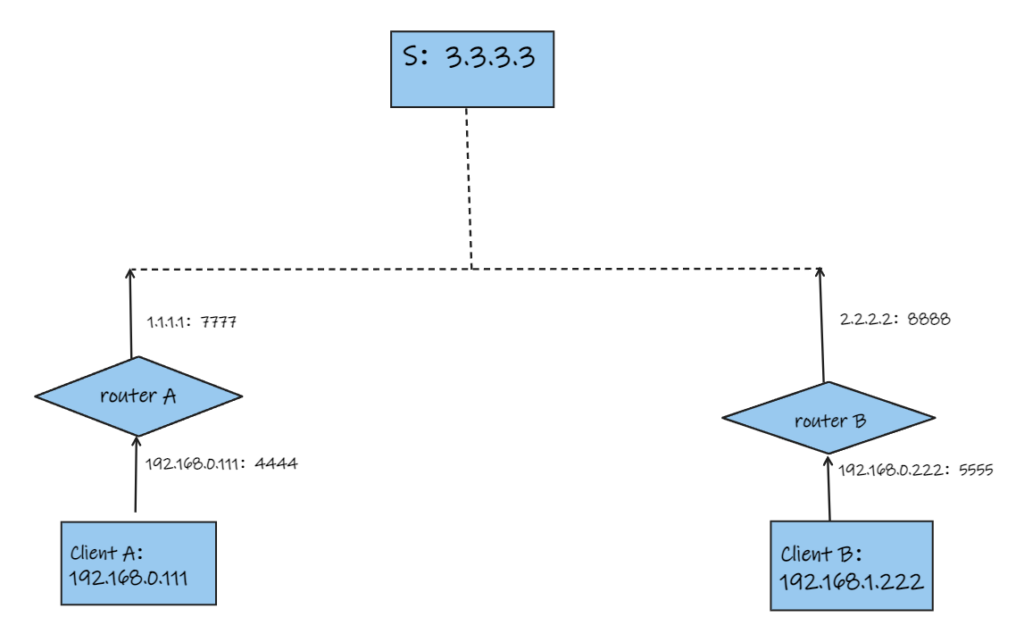

阿里云api实现ipv6的ddns

创建python的虚拟环境

# 创建一个虚拟环境python3 -m venv ipv6_py_env# 激活虚拟环境source ipv6_py_env/bin/activate

获取ipv6地址的脚本

ifconfig | grep -A 10 wlp2s0 | grep 'inet6' | awk '{print $2}' | sed '/fe80/ d'

将上述脚本使用python封装

res = sp.run("ifconfig | grep -A 10 wlp2s0 | grep 'inet6' | awk '{print $2}' | sed '/fe80/ d'", shell=True, capture_output=True, encoding="utf8")ipv6_addrs = res.stdout.split() # ipv6地址可能有多个,随便用一个即可

完整的python代码(修改自参考中的示例代码)

# -*- coding: utf-8 -*-import osimport sysimport timeimport subprocessfrom loguru import logger as loglog.add("auto_refresh.log")from typing import Listfrom alibabacloud_alidns20150109.client import Client as Alidns20150109Clientfrom alibabacloud_tea_openapi import models as open_api_modelsfrom alibabacloud_alidns20150109 import models as alidns_20150109_modelsfrom alibabacloud_tea_util import models as util_modelsfrom alibabacloud_tea_util.client import Client as UtilClientclass Refresh: def __init__(self): pass @staticmethod def create_client( access_key_id: str, access_key_secret: str, ) -> Alidns20150109Client: """ 使用AK&SK初始化账号Client @param access_key_id: @param access_key_secret: @return: Client @throws Exception """ config = open_api_models.Config( access_key_id=access_key_id, access_key_secret=access_key_secret ) # Endpoint 请参考 https://api.aliyun.com/product/Alidns config.endpoint = f'alidns.cn-hangzhou.aliyuncs.com' return Alidns20150109Client(config) @staticmethod def update_dns( new_ip: str ) -> bool: # 请确保代码运行环境设置了环境变量 ALIBABA_CLOUD_ACCESS_KEY_ID 和 ALIBABA_CLOUD_ACCESS_KEY_SECRET。 # 工程代码泄露可能会导致 AccessKey 泄露,并威胁账号下所有资源的安全性。以下代码示例使用环境变量获取 AccessKey 的方式进行调用,仅供参考,建议使用更安全的 STS 方式,更多鉴权访问方式请参见:https://help.aliyun.com/document_detail/378659.html client = Refresh.create_client("your-ALIBABA_CLOUD_ACCESS_KEY_ID", "your-ALIBABA_CLOUD_ACCESS_KEY_SECRET") # record_id 可以通过 DescribeDomainRecords 接口拿到, 见 https://next.api.aliyun.com/api/Alidns/2015-01-09/DescribeDomainRecords update_domain_record_request = alidns_20150109_models.UpdateDomainRecordRequest( record_id='879766660467119104', rr='ipv6', type='AAAA', value=new_ip ) runtime = util_models.RuntimeOptions() try: # 复制代码运行请自行打印 API 的返回值 client.update_domain_record_with_options(update_domain_record_request, runtime) return True except Exception as error: if "The DNS record already exists" in error.message: # 说明该条记录已经存在,则无需更新 return True log.error(error.message) # 诊断地址 log.error(error.data.get("Recommend")) UtilClient.assert_as_string(error.message) return False return Falseif __name__ == '__main__': # 检测当前ip是否和上次更新的ip一直,如果不一致则更新dns pre_ip, cur_ip = None, None while True: try: res = subprocess.run("ifconfig | grep -A 10 wlp2s0 | grep 'inet6' | awk '{print $2}' | sed '/fe80/ d'", shell=True, capture_output=True, encoding="utf8") if not (res and res.stdout and res.stdout.split()): raise Exception(f"empty ipv6 address, {res and res.stdout}") except Exception as e: log.error(f"get ip error, {e}") time.sleep(30) continue ipv6_addrs = res.stdout.split() if pre_ip in ipv6_addrs: time.sleep(1) continue else: cur_ip = ipv6_addrs[-1] updated = Refresh.update_dns(cur_ip) if updated: log.info(f"updated dns, pre: {pre_ip}, new: {cur_ip}") pre_ip = cur_ip time.sleep(30) continue else: log.error("update dns fail") time.sleep(30) continue

最后执行该文件即可

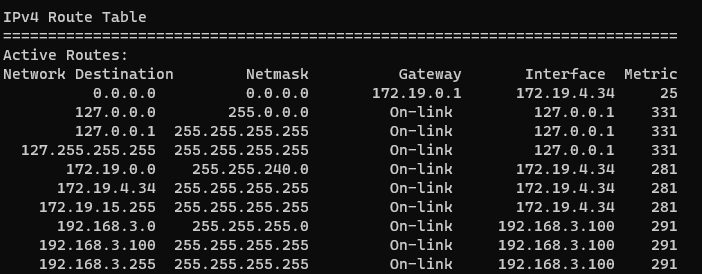

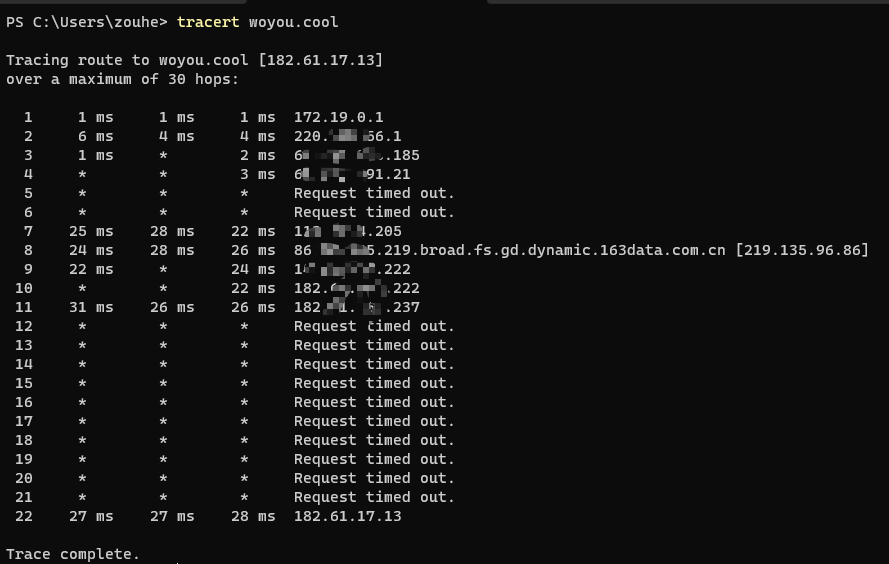

深圳联通光猫改桥接访问ipv6

问题

深圳联通宽带,提供了ipv6地址,内外可以访问,外网仍然访问不了。经排查,问题可能出在联通光猫上,它带有ipv6的防火墙,会阻拦入站流量,没有找到关闭的方法。

遂想到是否可以将光猫修改为桥接模式,然后使用路由器进行PPPoE拨号上网,自己的路由器对ipv6应该更宽容。

想要修改光猫就得拥有光猫的管理员权限,问题在于,由于联通宽带光猫的管理员账号密码是动态变化的,问宽带师傅他还不一定给。说来也比较奇怪,一个月前我在网上搜了一下,广东的联通光猫账号密码都是 CUAdmin/cuadmin+光猫mac前6位(光猫后面贴的有),当时还能登录进去,现在又登录不了了,不知道是不是最近才改成动态密码的(每过一段时间宽带提供方会自动更新光猫的密码)。

网上有很多通过telnet和ftp的方式查看密码的方法,例如这个等等,但到我这都没用,我按照他们提供的配置页面地址进去,全都会跳到登录页面,即使我已经登录了普通账户(光猫后面都会贴上一个普通用户的账号和密码)

后来是通过重置光猫的方式解决管理员账户的问题的,注意,在重置之前有些必要信息需要提前保存,以下为详细过程

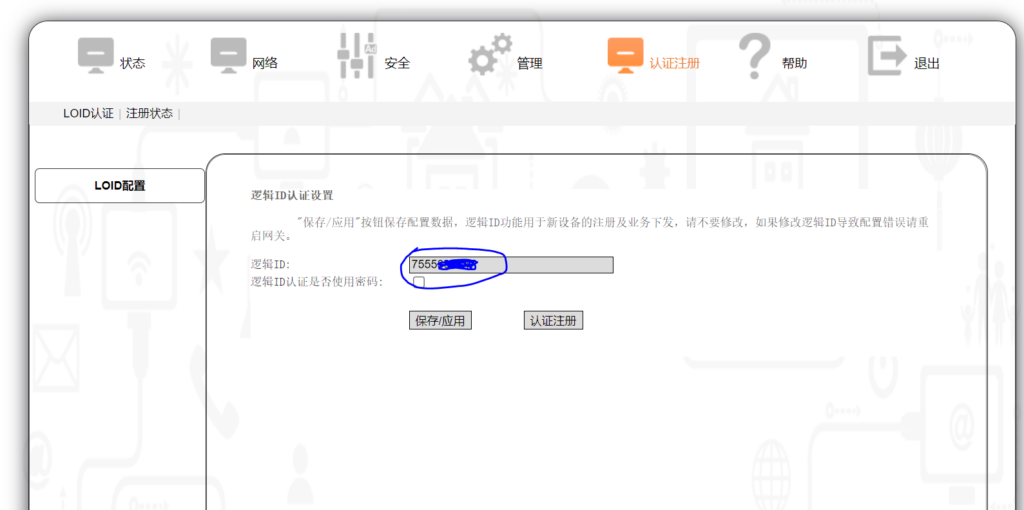

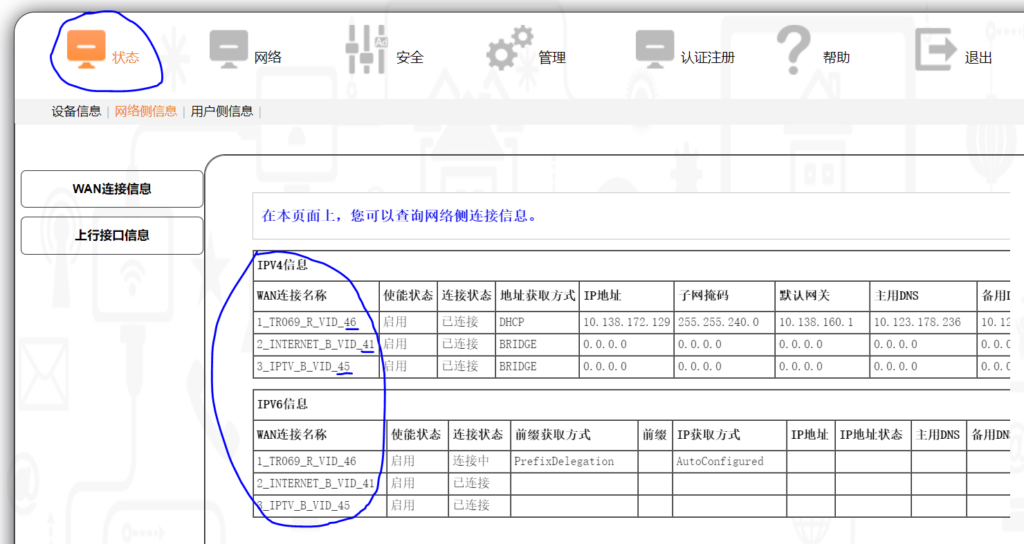

光猫改桥接

记录信息

首先进入光猫后台(一般是 192.168.1.1),登录普通用户(光猫后面有贴)

登录后选择 “认证注册” 选项,将LOID(逻辑id)复制并保存在本地,后面要用

再进入 “网络” 选项,查看PPPoE拨号的账号和密码,账号一般明文显示,密码则是星号显示,要查看密码也很简单,打开浏览器的开发者模式,定位到密码框,将 input 标签的类型由 password 改为 text 即可。我这边查看到的密码就是账号的后6位。将账号和密码保持在本地

进入 “状态” 选项,记录一下vlanid,这一步对我来说没什么用,但是记录一下以防后续用到。vlanid就是后面的那几个数字

注:简单解释一下这三个东西是什么,可以直接理解成运营商会给你的光猫分配三条宽带,它们每一条宽带都是独立的,且拥有独立的ip地址:

-

TR069用于运营商远程管理你的光猫,例如远程修改光猫配置、更新光猫固件等,管理员动态密码就是运营商通过它远程下发的。网上有很多教程会说需要删掉该信道,但一般该信道的删除按钮会在前端置灰,真要删除的话只需要修改该button的dom属性即可点击

-

INTERNET 就是上网用的宽带,如果要将光猫网络改为桥接,则将它修改为桥接方式即可。

-

IPTV 就是用来看电视的

重置光猫

拿一根牙签一直按住光猫后面的复位按钮,直到前面板的等只剩一个电源灯在亮

设置光猫

再次进入光猫后台(192.168.1.1),选择管理员登录,此时直接使用 CUAdmin/CUAdmin 登录即可

进入 “高级配置” 选项,选择 LOID配置,在 逻辑ID 处填入刚保存的LOID,点击保持按钮。

对我来说,到这一步之后,稍等一会我的光猫就会在路由模式下自动连上网,并且管理员密码已经被修改了,也就是说,光猫能不能上网貌似就认这个 LOID,至于拨号上网的PPPoE账号和密码则是自动下发的。

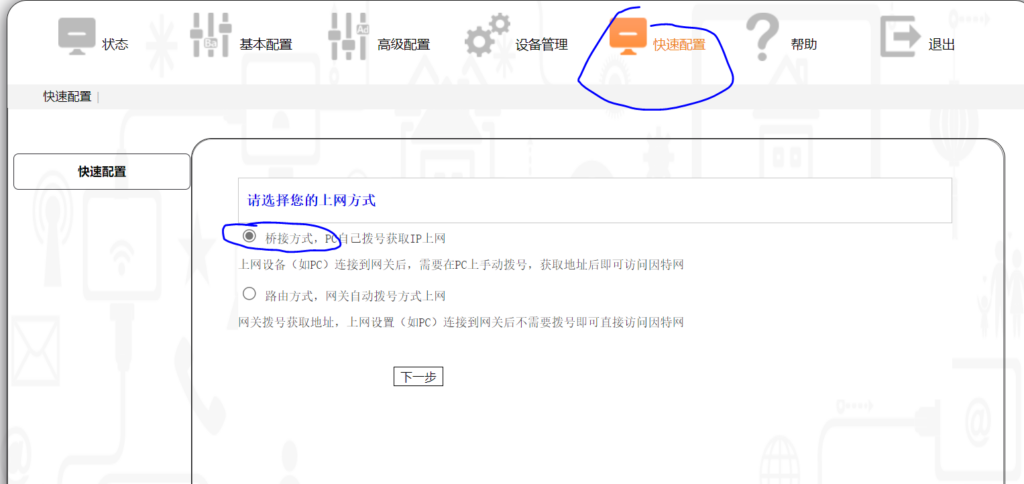

若想让其变为桥接,关键一步来了,你需要在点击保持上述LOID后,稍等一会(半分钟?一分钟?见下面的注)然后立即进入 “快速配置” 选项,选择第一个桥接方式,然后点击下一步,后面还会询问是否需要启用光猫的无线网,去掉勾勾即可,再点击完成

注:快速配置这里默认是勾选的桥接方式,当设置了 LOID 后,并且LOID生效后,它又会变成默认勾选路由方式,所以这里等待的关键就是要等它自动勾选为路由方式之后,再手动选择桥接方式

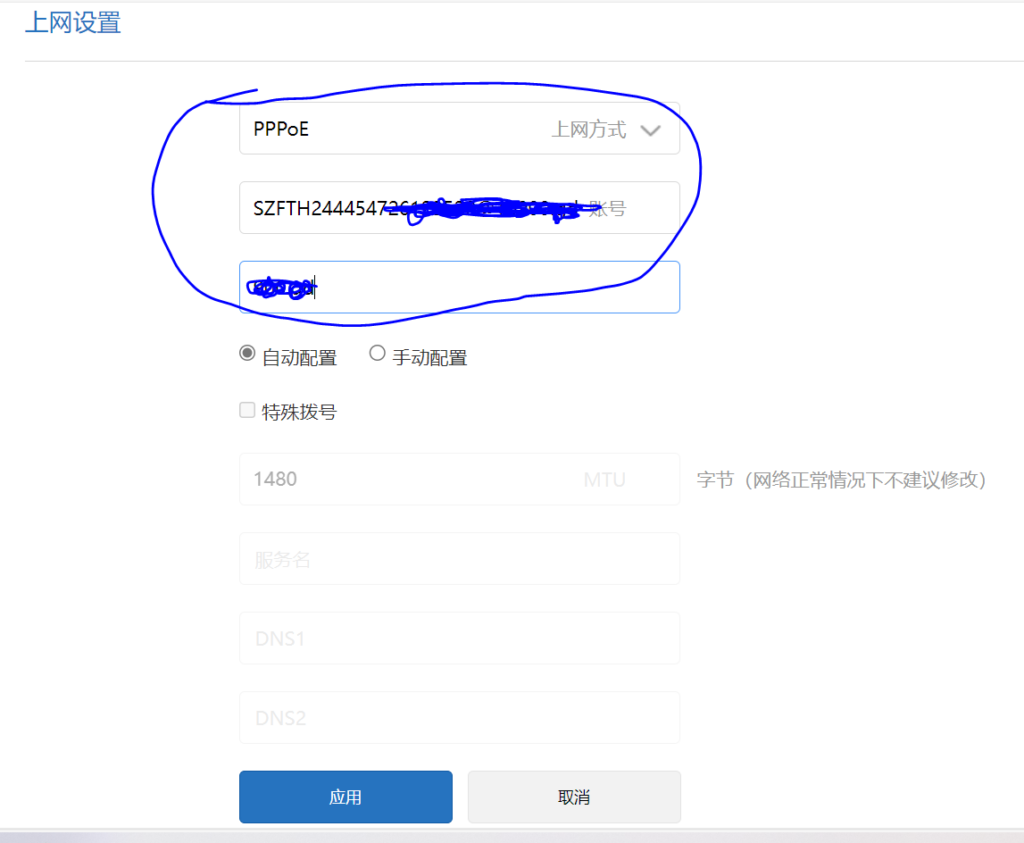

配置路由器

我这个路由器也是办宽带送的一个小米路由器,进入小米路由器后台(miwifi.com),在常用设置中找到上网设置,默认这里是DHCP方式,将其修改为PPPoE方式并输入刚才保存的宽带账号密码,点击应用按钮,等待一会即可

当在当前页面中的上网信息中能看到外网的ip地址时,说明已经可以了

注:路由器修改为PPPoE后就无法通过192.168.1.1进入光猫后台了

IPv6

路由器设置

在路由器后台的 上网设置 中找到 ipv6,将上网方式改为 Native

python孤儿进程示例和解决方法

子进程原本的父进程停了,它就会由系统的init进程接管,这个子线程就成了孤儿进程,另外还有个僵尸进程的概念,说的是进程已经结束了但是资源没有被父进程清理。

在python中很容易产生孤儿进程,例如以下代码:

import timeimport multiprocessingdef sub_task(): """子进程任务:循环打印时间和父进程状态""" while True: print(f"{time.asctime()}, {multiprocessing.parent_process().is_alive()}") time.sleep(1)def parent_task(): """父进程任务:开启一个循环打印的子进程,然后睡5秒""" sub_p = multiprocessing.Process(target=sub_task, daemon=True) sub_p.start() time.sleep(5) # 将这里的5s修改为2s试试if __name__ == "__main__": p = multiprocessing.Process(target=parent_task, daemon=False) p.start() # 创建“父进程”后主进程睡3秒然后停掉“父进程” time.sleep(3) p.terminate() p.join() p.close()

上述的代码执行起来就会有问题,你会发现,即使已经将子进程设置为守护进程(daemon=True),将其父进程结束后,该子进程仍然在在打印,但是父进程状态(is_alive())由原来的 True 变为了 False,该进程已经成为了孤儿进程

但是,如果你将上述父进程休眠时间从5秒修改为2秒,则子进程也会随着父进程的退出而退出。

上述代码运行后,通过实验或任务管理器你会发现,父进程确实是在3秒后直接终止了,而子进程却没有。问题就在于父进程是正常退出还是异常退出,当父进程在执行terminate()之前已经执行完了(设置2s的休眠时间),则为正常退出,此时父线程会自动清理其子进程。而如果在执行terminate()的时候父进程仍然在执行(sleep() 设置为5)则为异常退出,此时它还没来得及清理其子进程,故而其子进程成为了孤儿进程

一个比较好的解决方法是使用进程间通信,例如使用 multiprocessing.Event:

import timeimport multiprocessingdef sub_task(): """子进程任务:循环打印一个东西""" while True: print(f"{time.asctime()}, {multiprocessing.parent_process().is_alive()}") time.sleep(1)def parent_task(shutdown_flag): """父进程任务:开启一个循环打印的子进程,然后睡5秒""" sub_p = multiprocessing.Process(target=sub_task, daemon=True) sub_p.start() shutdown_flag.wait()if __name__ == "__main__": shutdown_flag = multiprocessing.Event() p = multiprocessing.Process(target=parent_task, args=(shutdown_flag,), daemon=False) p.start() # 创建“父进程”后睡3秒然后停掉“父进程” time.sleep(3) shutdown_flag.set() p.join() p.close() print("main done")

multiprocessing.Event() 可以理解为一个bool值,有四个方法:

有一种金鱼

很小的时候看的一篇鸡汤文,大意是说,有一种金鱼,其体型会随着鱼缸的大小而受到影响,鱼缸越大,它最终长得就越大,对这篇文章印象比较深。我也比较推崇“环境主导论”。

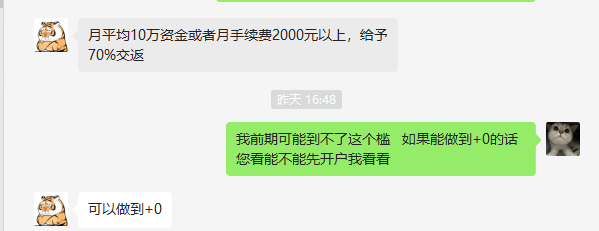

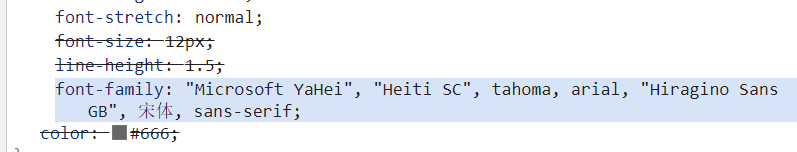

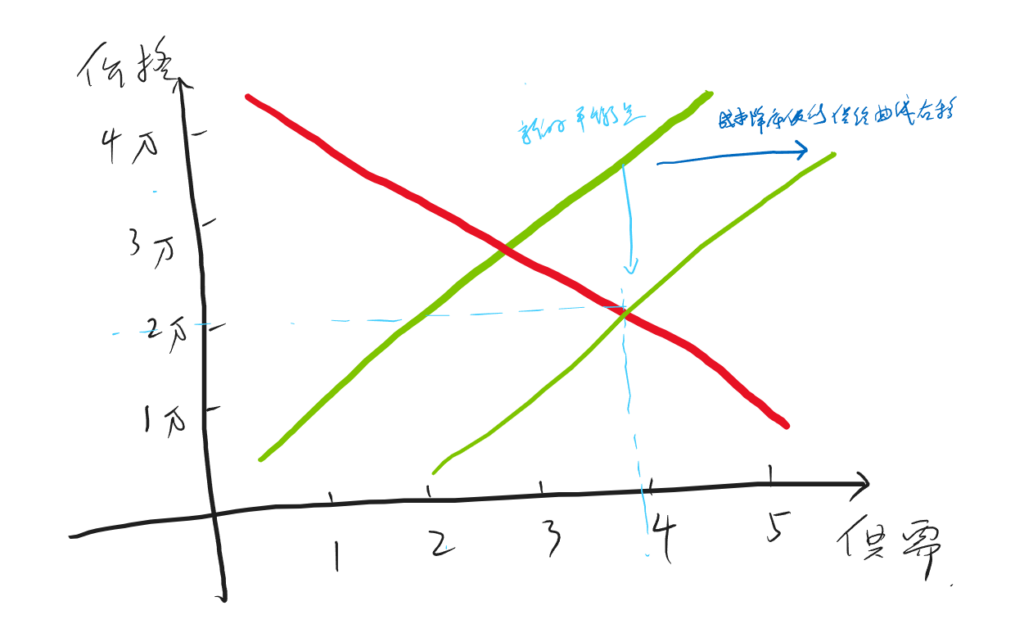

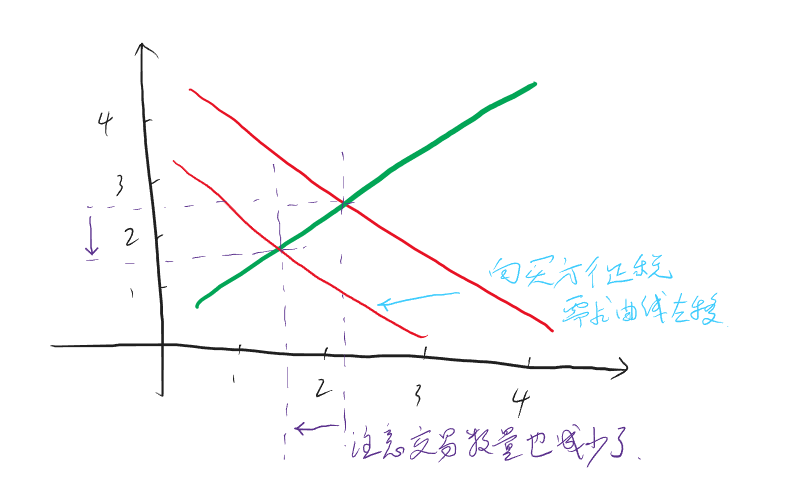

期货多/空头持仓市值计算

多头

多头比较简单也比较直观,公式如下:

\[ 多头持仓市值 = 持仓量 * 合约乘数 * 买一价 - 持仓量 * 合约乘数 * 成本价 * (1 - 保证金率) \ ]

可以这样理解这个公式:持仓量 * 合约乘数 * 买一价 得到的是多头持仓的实际市值,但是由于你在买这个仓位时并非”全款“买的,而是加了杠杆的,也就是说,你本来应该花 持仓量 * 合约乘数 * 成本价 这么多钱,实际上却只花了其 保证金率 的那部分,剩余部分是借来的,既然是借来的,那自然是要还的,所以得减去这部分

空头

空头不太好理解,至少我在推导这个公式的时候绕了不少时间。公式如下:

\[ 空头持仓市值 = 持仓量 * 合约乘数 * 成本价 * (1 + 保证金率) - 持仓量 * 合约乘数 * 卖一价 \ ]

空头简单说就是市场好的时候,你借别人的合约卖出去,然后等市场差的时候再低价买回来还回去。

可以这样理解这个公式:我认为这里比较绕的部分是,多头持仓是在你开头寸的时候花钱的,而在平的一瞬间是给你钱的,这就和平时买卖东西一样,而空头持仓是在你开的时候给你钱的,而在平的时候花钱的。但实际在交易空头过程中,你仍然是在开的时候花钱,平的时候给你钱,为什么会这样呢?因为开的时候是你向交易所借的头寸卖出去,这个时候交易所不会无缘无故借给你,所以你需要缴纳与头寸同价值的保证金,但是这个保证金也不是要你全额给,之需要你给保证金率那部分,与此同时,交易所将你借的头寸卖出去后,会得到卖的钱,理论上这个钱应该是直接给到你的账户,这样就符合上面说的逻辑,但实际上这个钱会直接给到交易所。至此,交易所那里就有你的两笔钱,一笔是你借头寸的保证金(带杠杆),一笔是卖期货的钱(全额),而你也在开空头的时候花了钱。当你平掉这个空头的时候,你需要去市场买同样多的头寸还给交易所,但因为开的时候卖期货的钱是给到了交易所,所以交易所会用卖期货得到的钱帮你去市场买这些头寸,所以平的时候你就不用花钱。与此同时,交易所会将之前那两部分钱还给你,并同时扣除平的时候去市场买头寸的钱。这就是上面这个公式的由来。

保证金和手续费

可以参见 期货开户知识

另外要注意:手续费是按手数收的,也就是说,你一次买 5 手,是收 5*手续费 这么多钱

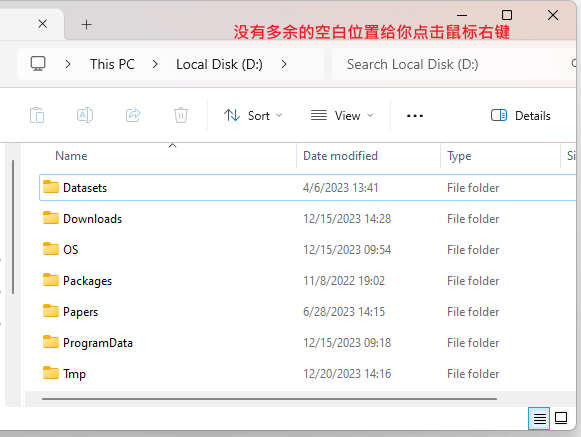

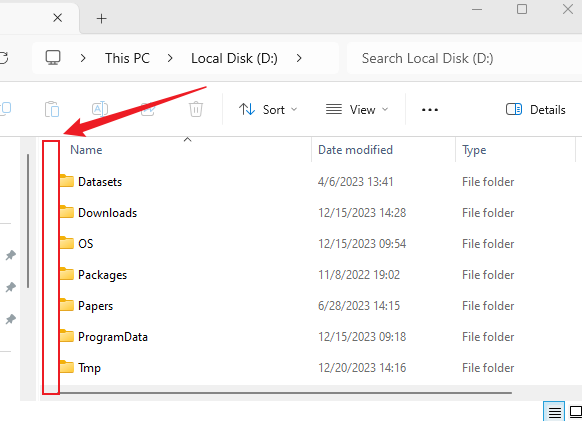

windows文件管理器没有空白区域点右键

即使用了windows这么多年,这东西仍然让我非常抓狂。

当你打开文件管理器,文件区域都被各种文件或文件夹占满了,此时你想在当前文件夹中右击鼠标(比如打开git bash、新建文件夹等),亦或者你需要从其他位置拖动一个文件到当前文件夹,此时如果你很容易就将这个文件移动到当前文件夹的一个子文件夹了,因为已经没有多余的空白位置给你点击右键了,有时候真的很让人抓狂

过去我一直都是小心翼翼地将鼠标移动到两个文件夹中间的空白位置,但很容易偏,以下为解决方法:

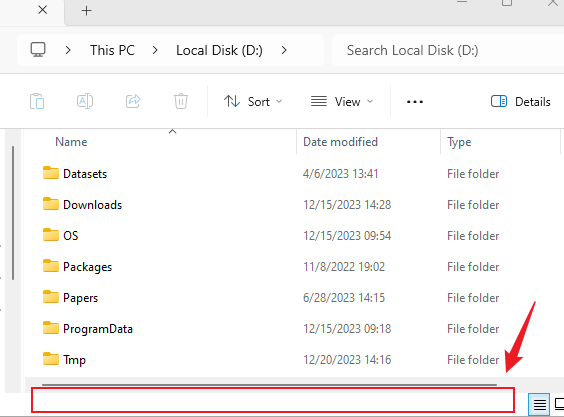

对于要拖动文件复制/移动到当前文件夹,可以将文件拖动到整个文件管理器下面的空白区域:

对于需要在当前文件夹右键的,可以选择这个区域:

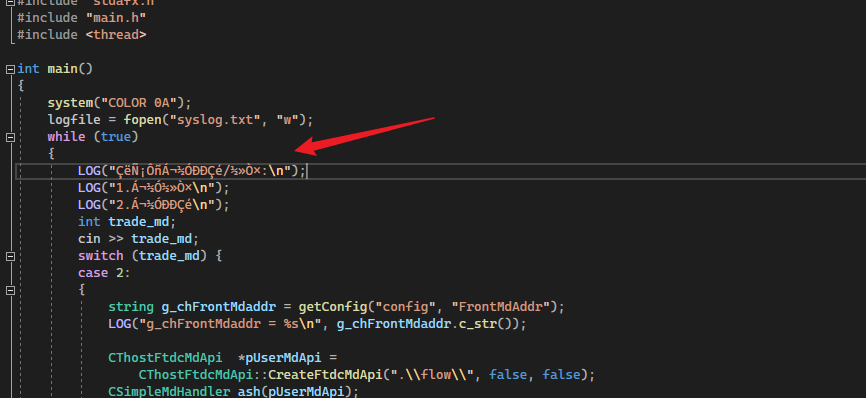

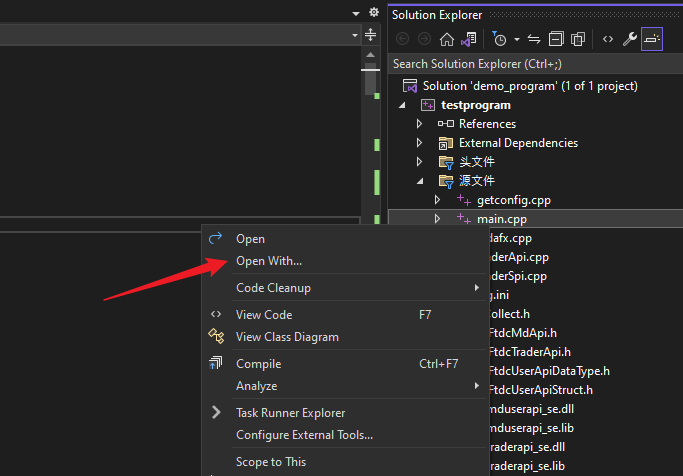

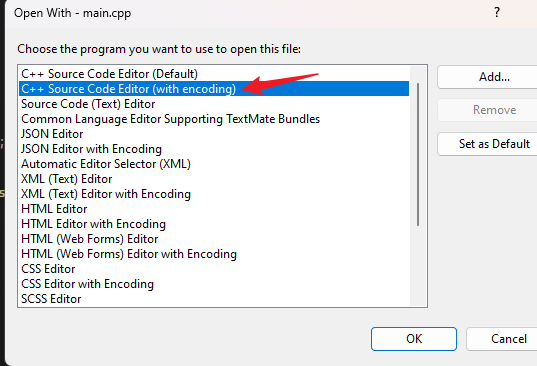

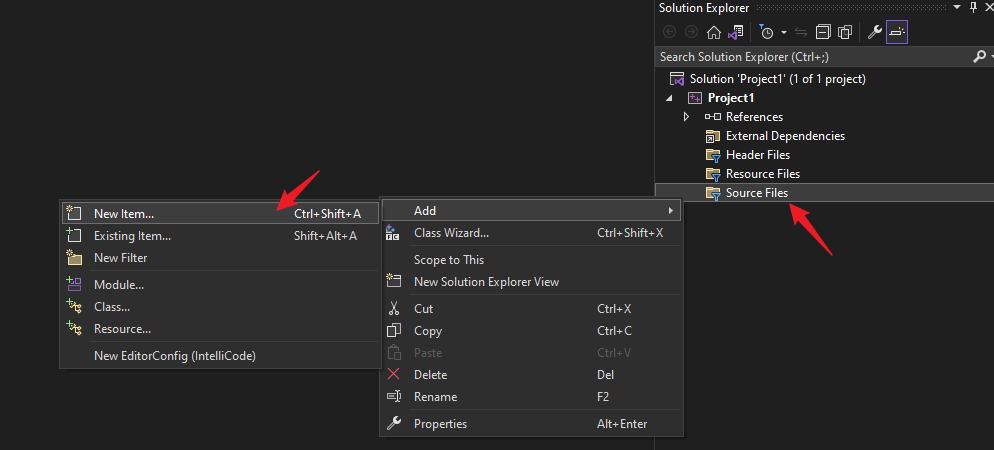

Visual Studio 中文注释显示乱码

现象

下载的第三方源代码中的中文在 Visual Studio 2022 中显示乱码

解决

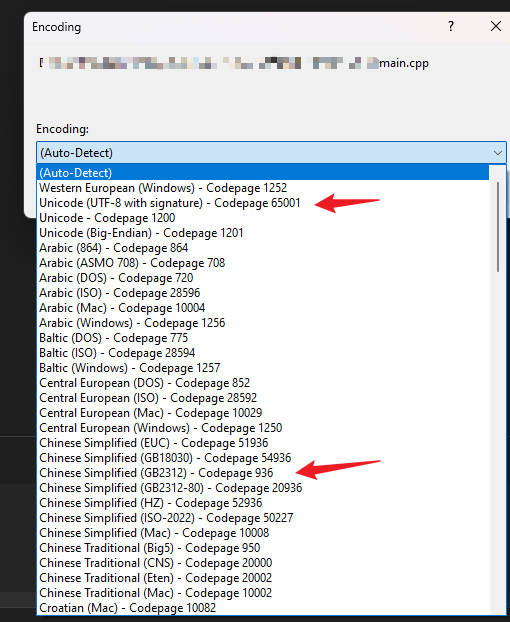

右键要打开的代码文件,选择 “open with…”

弹出的对话框选择:

进一步可以选择 utf8 或者 gb2312 等,不行就多试几个

然后就能正常显示

参考

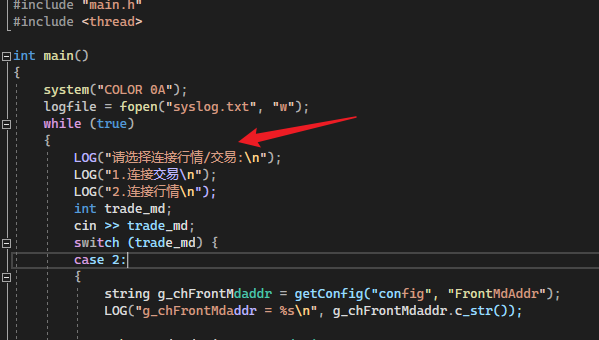

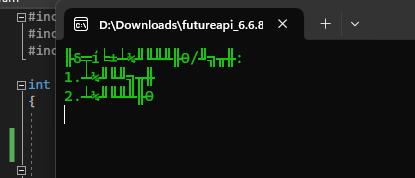

cmd显示乱码

源文件以gb2312保存的,所以终端也得用该编码显示,否则就会出现乱码

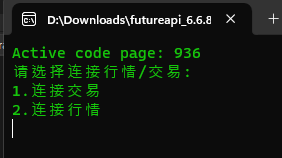

解决方法是在代码前加上

...system("chcp 936");cout << "你好"...

用于临时修改cmd的编码方式,其中chcp就是修改命令,936表示gb2312,65001表示utf8

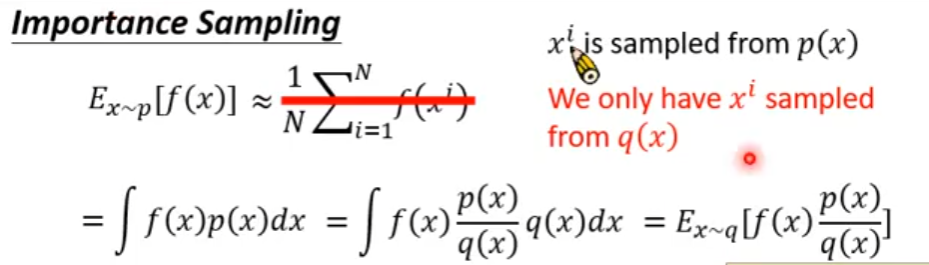

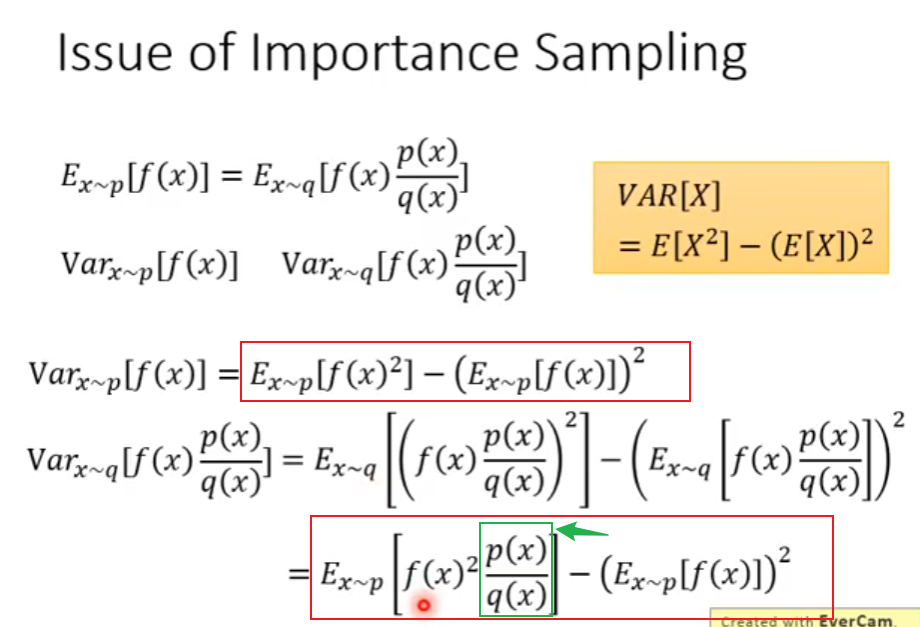

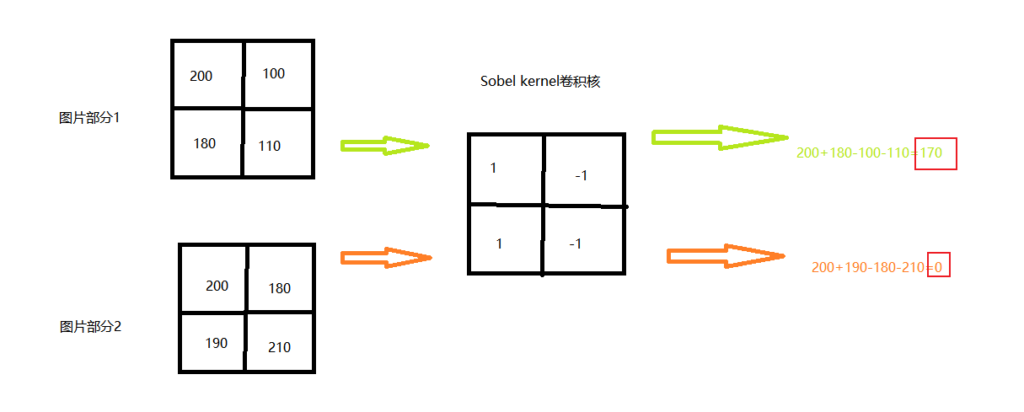

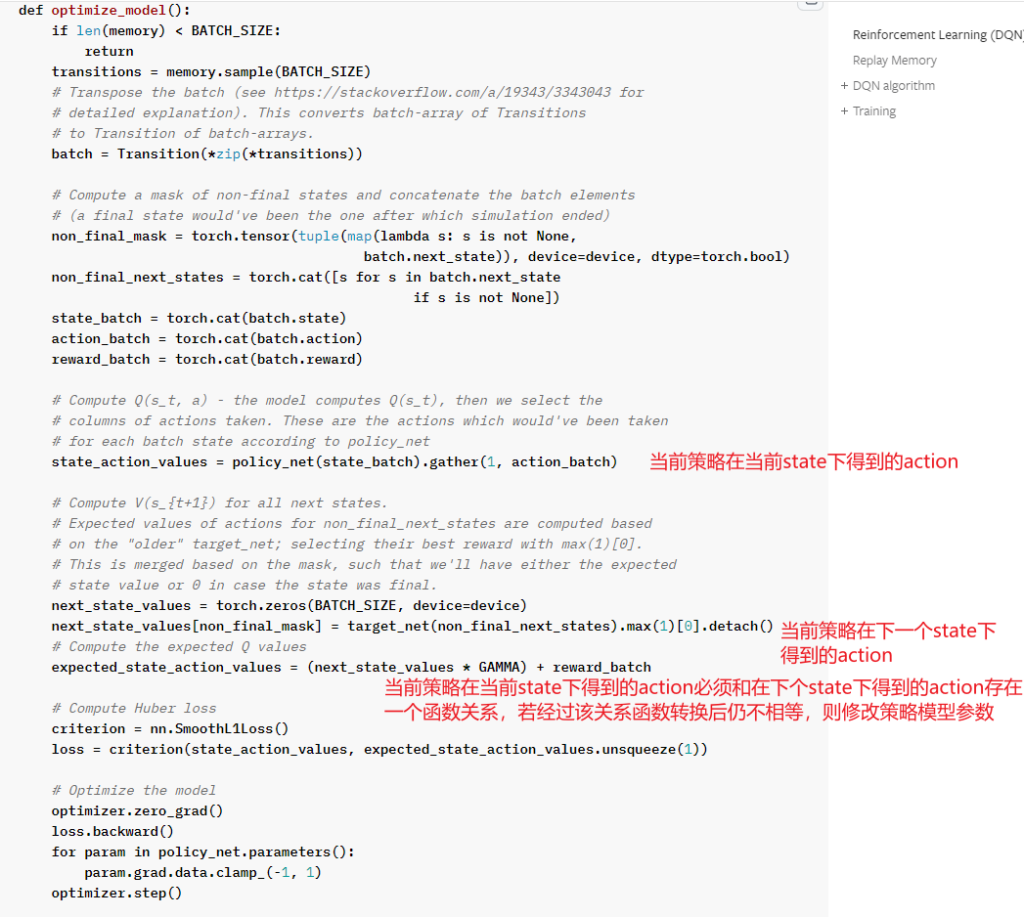

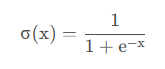

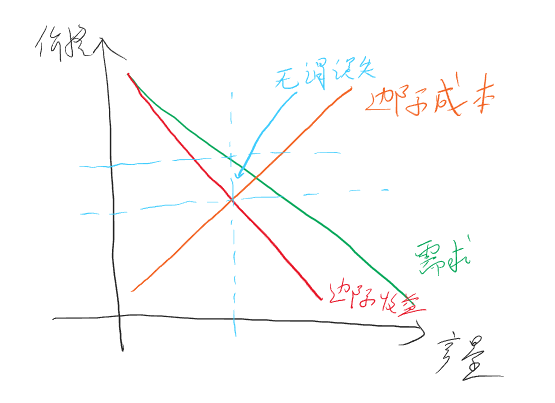

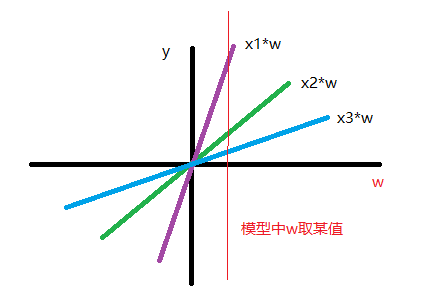

clipped surrogate loss in PPO

PPO是一种off policy的强化学习算法,它的优势就是可以重复使用之前policy与环境交互得到的数据,它通过将一个分布中的采样数据转换为从另一个分布中的采样数据,即从old policy这个分布转换为new policy这个分布

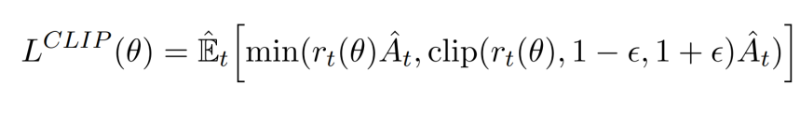

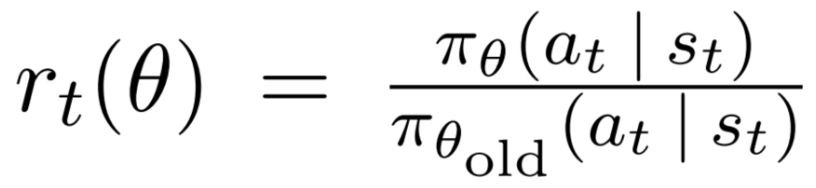

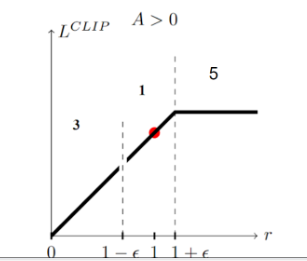

PPO就是在此基础上做了进一步优化使得其能适应强化学习的环境,其核心就是下面这个公式:

其中的 ( r_t(θ) \ ) 为:

即新旧策略在状态St下得到at的概率比值,显然,如果该比值大于1,说明新的策略更倾向于选择该action

以下为 stable-baseline3 中该表达式的实现,其中,ratio就是上述的那个比值,clip_range取值为0.2

# clipped surrogate loss

policy_loss_1 = advantages * ratio

policy_loss_2 = advantages * th.clamp(ratio, 1 - clip_range, 1 + clip_range)

policy_loss = -th.min(policy_loss_1, policy_loss_2).mean()

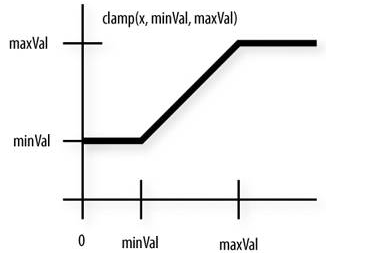

现在就有两个问题,1)对clamp(clip)的理解,2)对min的理解

clamp

从公式中看出,clamp是对ratio的裁切,即避免它过大或过小,为什么要这么做呢?通过 Importance Sampling 的式子可以看出,将一个分布转换为另一个分布后,它的期望值是没变的,但是它们的方差是不同的,若仅采样有限数据,很容易出现误差

注意到上图中,两者方差的第一项是不同的,后者会多乘这个ratio。理论上来说,由于均值不受影响,所以只要采样的数据足够多,也不会对最终结果产生较大影响,但对于一个实际意义的马尔可夫奖励过程,几乎是不太可能采样足够多的

一个非常需要注意的点是,被clamp过的部分是没有梯度的,即梯度为0,根据链式求导法则,前面计算的梯度应该都是0

换句话说,我们并不希望new policy和old policy的差异过大,如果太大的话,干脆就不对模型做更新了

min

如果当前的Advantage是正值时,如果当前的new policy远小于(两者比值小于某个阈值)old policy得到该action的probability,我仍然希望模型能够学到东西(参数更新,增大policy取得该action的概率)。

相反,若此时,new policy的probability远大于old policy,因为此时advantage是正值,我们的目的就是要让new policy的probability更大,而它此时已经比old大了,所以我们就应该避免它更大,故此时反而应该将其clamp掉,使得其梯度为0,进而使其不做更新

如果当前的advantage是负值时,若new policy的probability远大于old policy,则继续让其更新,因为我们要试图减小policy产生该action的概率,反之亦然

参考

https://huggingface.co/learn/deep-rl-course/unit8/clipped-surrogate-objective

https://huggingface.co/learn/deep-rl-course/unit8/visualize

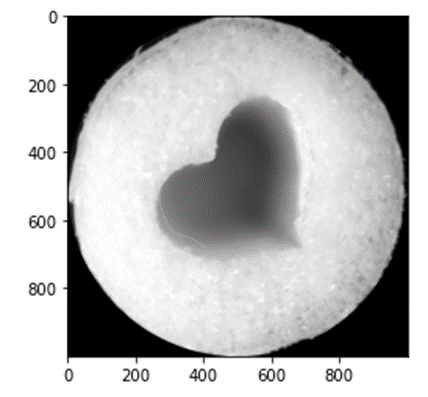

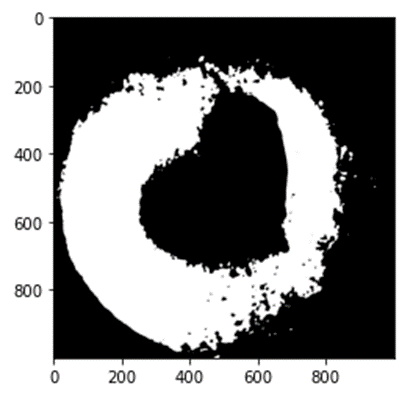

opencv不同环境下output不一致的一种场景

现象

opencv在c++和python中得到的结果不一致,即使是相同的语言相同的环境也可能得到不同的结果。

在做一个视觉项目时,其中有使用opencv,开发过程中我会先使用python写出基本的代码进行测试,可行的话再用c++(qt)复写一遍,本机测试完成后上传到服务器实机测试,一开始开发过程还算正常,后面就发现,服务器上有些图片识别的有问题,遂将有问题的图片都过程保存成 xxx.jpg,然后拉到本地看看啥问题,结果本地识别起来又没问题,甚至于有的时候,使用python处理后得到的中间结果再用c++继续处理就会出现和只用python处理的结果不一样。

这种情况并不普遍,几千张图片可能出现几个异常的情况。拉下来后本地又识别得没问题。

排查

一开始以为是缓存的原因,但是仔细重构代码后排除了这种可能

然后以为是并发的原因,因为之前也出现过一次使用qt出现的并发问题,多线程下一个野指针出现的问题,也是小概率出现,也是折腾了很久才解决。

反正就是搞了很久,还是无法百分百确定是不是并发造成的,于是想想是不是其他原因

甚至于我将每张出问题的图片的每个中间处理过程都保存下来和本地进行对比,输入一样(目视)但结果就是会出现不一致

最后,我将每张图片都保存后让程序进行重放(按原来顺序重新检测),经过对比发现,不是随机出现的,遂确定不是并发导致的,于是我将出问题的图片单独进行检测,奇迹出现了,不管是本机还是服务器,检测结果都一致了,我又试了多次,确实是一致的。

我的代码中,出问题的地方主要是霍夫圆检测上(HoughCircles),该函数基于Canny算子做边缘检测,然后我发现之前出问题的图片,虽然输入的图像目视是一样的,但Canny处理后的结果会出现些许不同。虽然不同的地方还是比较少,但我觉得霍夫圆检测对参数还是比较敏感的。

然后我突然想到,之前不一致的情况都经过了一次中间过程的存储,然后再进行读取的,那问题一定是出现在存储格式上。

解决

问题就出现在jpg这种图片格式上,其实从一开始我就有想到这个东西,因为我一直对傅里叶变换比较感兴趣,而jpg就是用该原理实现的,但不知道怎么的,后面忘了这茬了。将图片以位图的形式保存就好了。

// 原来的

cv::imwrite("img", "xxx.jpg")

// 现在的

cv::imwrite("img", "xxx.bmp")

后记

有一说一,c++/qt 好像做什么都比较麻烦,还不好debug,用惯了jetbrain的ide再用qtcreator感觉就像回到了上个世纪。

github双击.ipynb内容消失

症状

随意打开github上的一个.ipynb文件,例如这个,任意双击或者选中某个内容,然后整个文档就消失了,并且提示 “Unable to render code block”

刷新页面又出现了

原因

这是带弹窗的浏览器插件引起的,对于我来说,是 Saladict 这个插件,它的作用就是选中一个单词,然后出现一个弹窗显示该单词的内容

解决

关掉弹窗插件

stable-baselines3中的SAC

现象

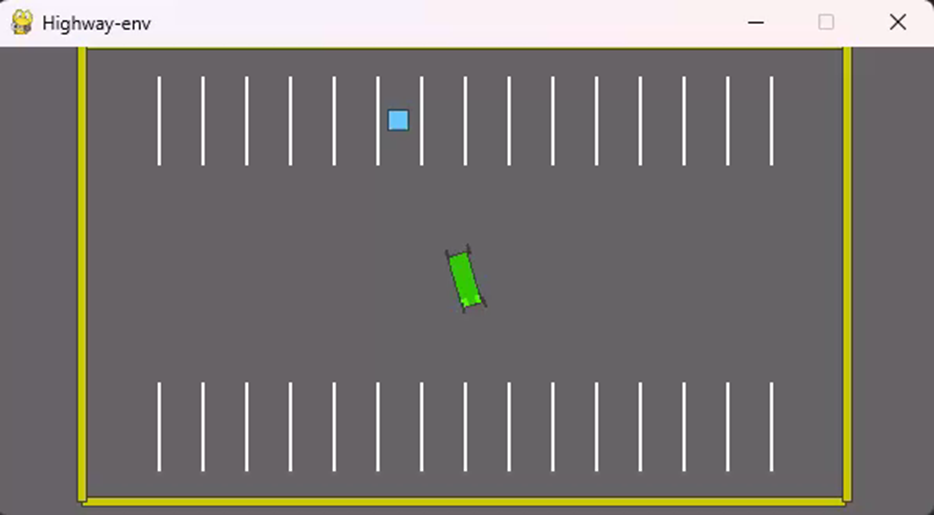

本来自己写了一个SAC模型用于测试parking环境(http://highway-env.farama.org/environments/parking/),该环境模拟自动停车过程,小车需要停到停车场随机的一个目标车位(见下视频)

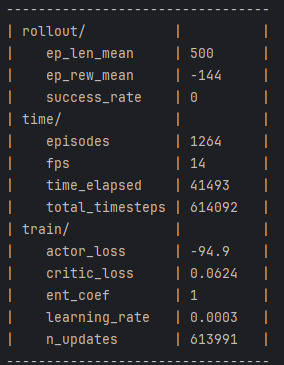

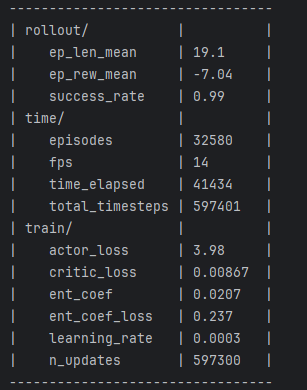

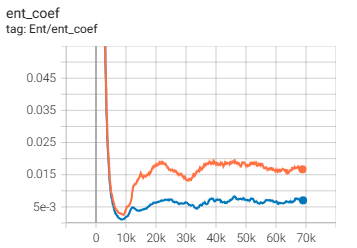

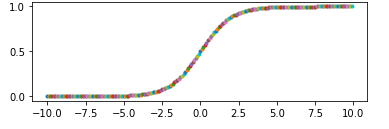

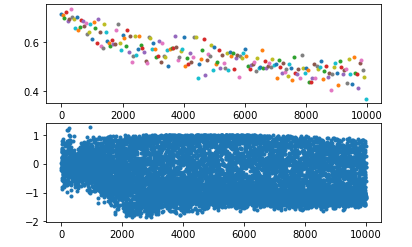

无奈模型怎么也无法达到预期效果,经过多次测试发现,仅仅将DDPG修改为不确定性策略是可行的,但一旦加上最大熵(SAC的核心)模型就不不行了,然后使用stable-baselines3(https://github.com/DLR-RM/stable-baselines3/tree/master/stable_baselines3/sac)就可以,遂研究了一下两者代码的区别,发现,SB3默认会使用一个ent_coef的可学习参数,作为最大熵的系数,该参数可设置为固定值,以下分别为设置为固定值和可学习参数得到的效果:

使用固定值为1的效果,见日志中的 train/ent_coef,从最终效果中可以看到,好像小车有那么一点点趋势会向目标点靠近,但不多

注意到 train/ent_coef 的值经过学习后变得很小(初始值为1),仅为0.02,从视频也能看到模型训练达到了预期的效果

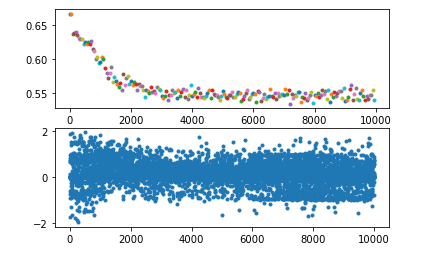

随后我在我自己的SAC代码中也加入该可学习参数,发现确实也work了,该参数经过一段时间的学习也变得非常小:

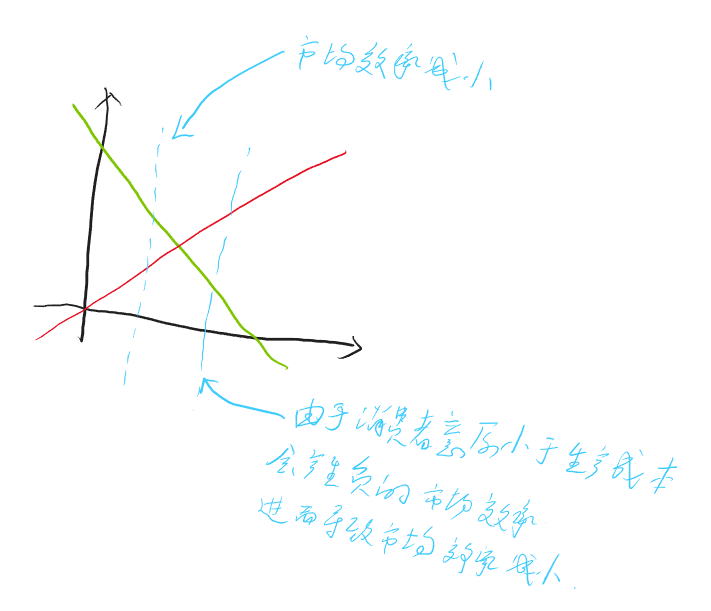

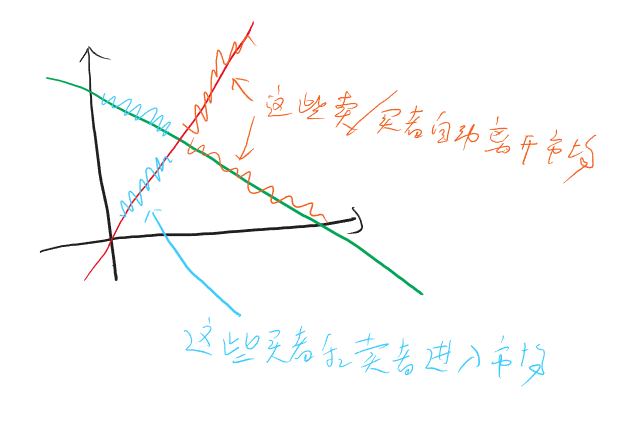

分析

对于SAC来说,貌似有两个理论上很少提到但是实际上又不可或缺的东西

log_ent_coef 最大熵的温度控制

该参数原始代码大概长这样:

# 定义一个可学习参数

log_ent_coef = torch.log(torch.ones(1, device=device)).requires_grad_(True)

ent_coef_optimizer = torch.optim.Adam([log_ent_coef], lr=1e-3)

...

# 将上述参数作为 -log_prob 的系数,即最大熵的系数

ent_coef = torch.exp(log_ent_coef.detach())

target_Q = self.critic_target(next_states, act_next) - ent_coef * log_prob_next.detach().sum(dim=1).reshape([-1, 1])

...

# 参数学习

act, act_log_prob = actor(current_states)

ent_coef_loss = -(log_ent_coef * (act_log_prob - np.prod(env.action_space.shape)).detach()).mean()

ent_coef_loss.backward()

如何理解这个loss函数呢?以下是我由果推因的想法:

将loss单独拿出来看:

ent_coef_loss = -(log_ent_coef * (act_log_prob - np.prod(env.action_space.shape)).detach()).mean() # np.prod(env.action_space.shape)=2

需要先说明的是,act_log_prob 这个变量是当前policy在当前state下得到的动作的log probability,由于模型输出的是一个高斯分布,其均值和方差可能为任意数,所以高斯密度函数输出的值也可能为任意数,故而 log probability 也可能为任意值,有正有负。

GAN已经很不稳定了

今天是十月底了,嗯,十月底了

GAN已经很不稳定了,再加上不确定性策略,只能说是知易行难呀

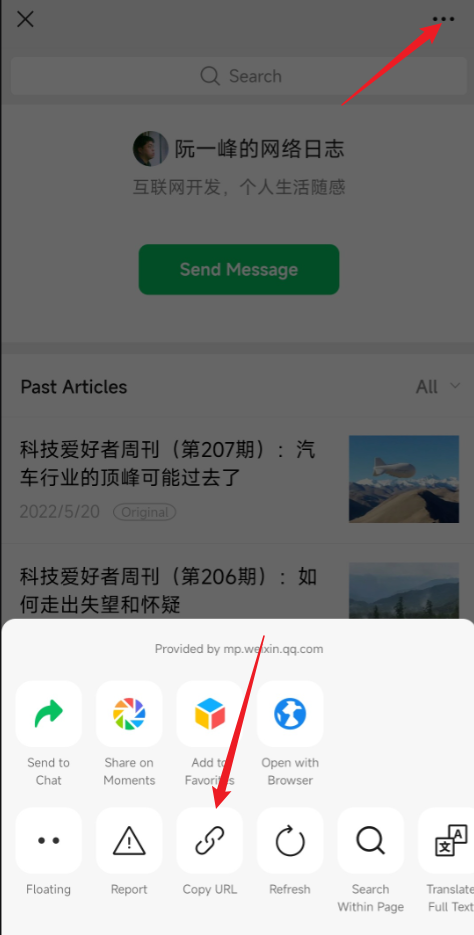

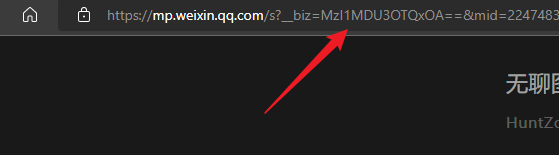

有几个月没看阮一峰的网络日志了,看看去

你的职业规划是什么?

前天一个二面,没怎么问技术,倒是问了我很多人生规划之类的东西

这种问题面试中很常见,但是我一直没做什么准备,很遗憾,这一次又被问到哑口无言,我决定给自己找一个一直不准备这个问题的借口:

每个人都是不一样的,每个人是性格都是不一样的,每个人的价值观都是不一样的,每个人对世界的认知都是不一样的,每个人对人生道路的规划都是不一样的

我并没有明确的职业目标,这肯定与面试官的期望想违背,但是我没有就是没有,我不想随便编一个

我小的时候倒是有,我想当一名发明家,我小的时候确实有往这方面努力,我半夜偷偷起床去隔壁小土屋里面搞我的发明,我搞了一个曲轴连杆的走路机器人,然后被我妈揪了回去。我做过很多手工玩具,那时候我想我可能真的会成为一名发明家吧。

我们班每个人有自己的职业梦想,但是有多少人实现了呢?

制定一个职业目标就好比参加一场马拉松,大多数人平时并不怎么跑步,或者并没有跑过很远,所以他对长跑的看法是很天真很理想的,跑过10公里就觉得20公里很简单,只不过是两个10公里相加,进而觉得40公里也不难。真正跑的时候才发现自己其实跑不了那么远,于是纷纷有人在半路上停下来。想成为医生的最终成为了护士,想成为科学家的最终成为了程序员。

并不是说目标定得太虚,而是因为世界无时无刻不在发生变化,你永远预测不到未来会发生什么。

就像那个面试官问我有没有职业规划,我说我未来五到十年钻研各种技术,希望自己至少能在一门技术上有所建树。然后他接着问我以后的规划呢?我说我可能成为不了人员管理相关的职业,所以可能会走项目管理相关的方向。然后他就问,那你对项目管理的目标有什么具体规划吗?

我能说什么呢?未来五到十年的东西我们根本无法知道,更远的东西我能做什么规划呢?

如果再有人问我这个问题,我只能这样回答:

我对未来的职业并没有一个明确的规划,但是这并不代表我对自己的认知不足,也不代表我目标不够明确。很多人实现理想的方式是制定一个目标,然后一步一步向这个方向走,而我不同,我是明确一个方向后一步一步向这个方向走,走到哪一步,取得什么成就,这并不是我当前应该关心的,我应该关心的就只是当前这一步走得对不对,好不好。至于其他,水到渠成。

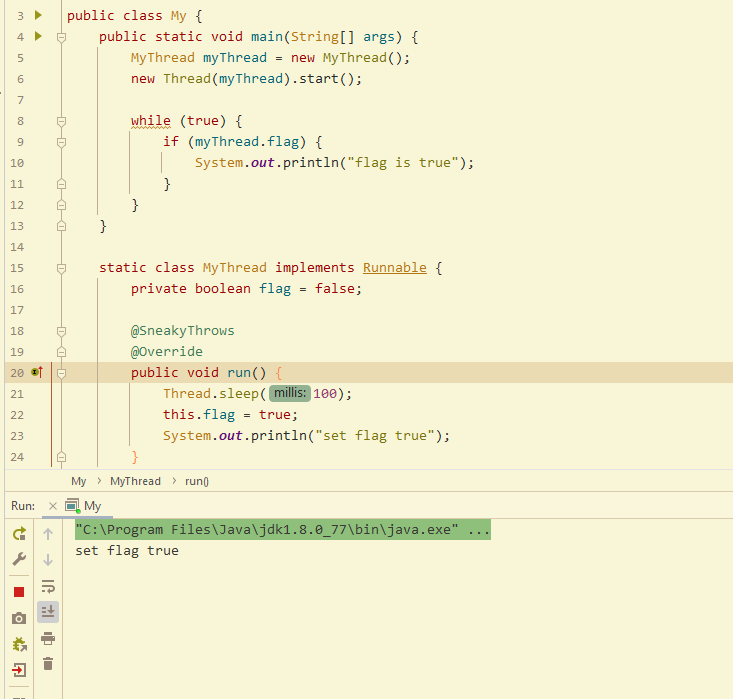

java多线程编程实战指南 笔记

线程简介

进程是程序的运行实例,是动态的,运行一个java程序实际上就是一个java虚拟机进程

进程是程序向操作系统申请资源(内存空间、文件句柄等)的基本单位,线程是cpu调度的最小单位

一个进程可以包含多个线程,这些线程贡献进程申请的资源

Thread的start方法是启动一个线程,但该方法的调用并不一定立即启动线程,得看系统的线程调度器决定。线程是一次性的,即该方法只能调用一次

run方法是线程的具体任务逻辑,它是由JVM自动调用的,该方法执行结束,则线程也就结束了。由于该方法是一个public的方法,当然可以手动调用,不过手动调用时它就是在当前线程下执行的普通方法了

java种,一个线程就是一个对象,但与普通对象不同的是,线程对象需要额外分配操作栈空间内存,并且可能绑定一个内核线程

Thread、Runnable创建线程的区别

// 方式一:通过匿名内部类的方式创建Thread的子类

new Thread(){

@Override

public void run() {

// ...

}

}.start();

// 方式二:通过传入一个Runnable接口的实现类来启动一个Thread

new Thread(new Runnable() {

@Override

public void run() {

// ...

}

}).start();

-

继承Thread对象本质上是基于继承的技术,而通过创建一个Thread对象并在构造器中传入Runnable实现则是基于组合的方式。从解耦的原则上来说,组合优于继承

-

可以只创建一个Runnable的实现并传入多个Thread中,使得它们可以共享Runnable中的变量,但可能引发并发问题

-

Thread对象就是继承了Runnable接口,但需要明确的是,Runnable接口和多线程运行并没有强制的关系,它只是一种可以运行的方法的抽象,很多接口并不需要使用多线程调用Runnable,这种情况下,创建Thread对象会更消耗资源,因为它会自动开辟栈空间并且绑定内核线程

可以将线程设置为守护线程,但是必须在start方法之前设置,否则会抛异常。守护线程和用户线程的区别在于,是否会影响JVM的停止,当用户线程执行结束后,不管是否存在守护线程,都会停止JVM

一个线程可以创建另一个线程,则它们就是父子关系。默认情况下一个线程是否是守护线程,取决于其父线程是否是守护线程,它们会保持一致。

线程状态

-

new:创建而未启动,该状态只会出现一次

-

runnable:包含ready和running两个状态,可能获取到cpu也可能没有,但处于可运行状态

-

blocked:IO阻塞或者等待锁时

-

waiting:一些特定方法触发线程等待,例如:Object.wait()、Thread.join()、LockSupport.park(Object)等

-

timed_waiting:带超时时间的等待

-

terminated:run()正常或异常结束,该状态只会出现一次

线程安全

什么是竞态?

竞态就是指多线程环境下,对某共享变量的操作可能出现不符合预期的情况,例如多线程下的 i++ 操作

线程安全的问题主要体现在3个方面:原子性、可见性、有序性

原子性

原子操作不可分割,意思是从其他线程的角度来看,对某共享变量的操作要么没执行要么执行完成,不存在执行到一半的状态

java中有两种方式实现原子操作,一个是锁,另一个是CAS

注:

-

java中的long和double的操作不具备原子性,即多线程环境下可能读写一半的值。

-

java中的volatile不具备原子性

-

但是两者结合就不一样了,jvm规范中特别指明了,使用volatile修饰的long或double的写操作具有原子性

可见性

一个变量更新后,其他线程可以立即读取到最新的值,即为可见性

JMM用于屏蔽物理机内存模型,因为每个cpu都会有自己的寄存器,但它们也有共同的内存空间,这就和JMM模型一致了。程序中的可见性是多线程衍生出的问题,它与实际用多少个cpu是无关的,这是因为线程的切换会导致寄存器的值出现上下文的切换,从宏观角度来看,其实就是在模拟多cpu

有序性

多处理器的情况下,从一个处理器视角看另一个处理器运行的程序是按照程序预期顺序执行的(这句话容易引发歧义,见下)。有些情况下,处理器并不会按照程序代码的顺序执行,例如发生了指令重排序或内存重排序(见下)。

所谓有序性,就是指避免重排序对多线程环境产生影响

注:对有序性的一个误解是从一个处理器看另一个处理器执行的指令是完全按照程序代码顺序来的,这是错误的,所谓有序性本意并非不允许重排序,而是说另一个处理器执行的代码,就算发生了重排序,对我这个处理器执行的代码结果是按照代码预期顺序的,例如下面的代码:

处理器1

A = 0

B = 1

S = 2

-------------------t1时刻

处理器2

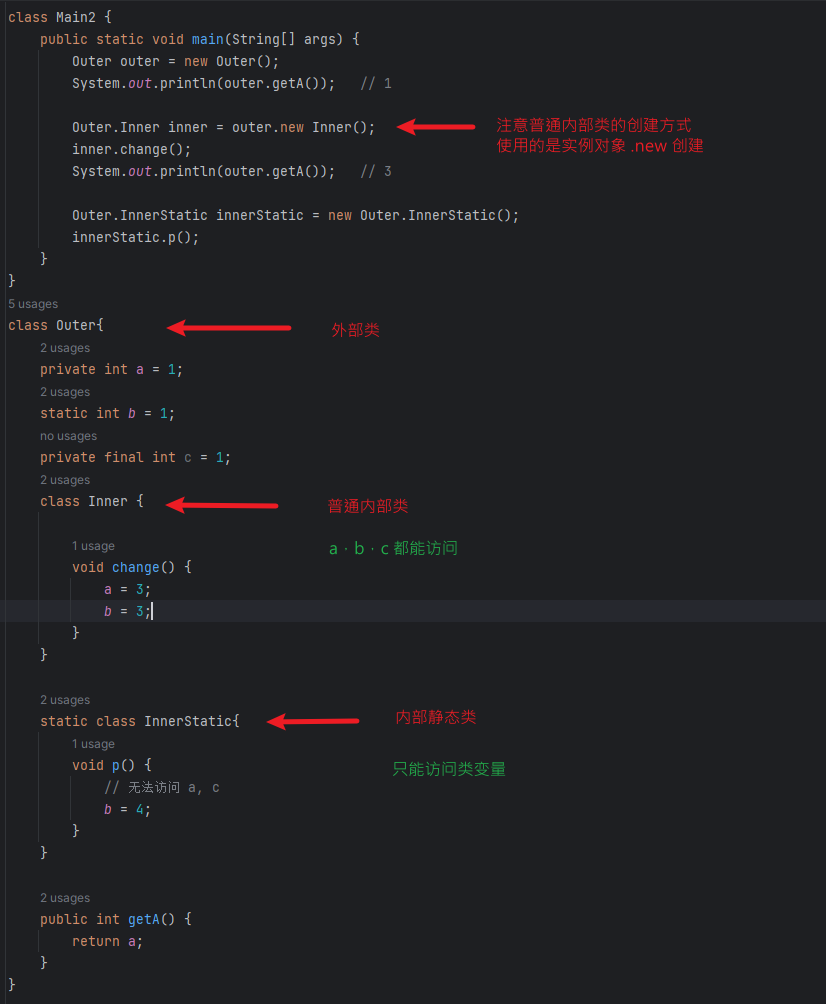

java内部类

一般内部非静态类

class Outer {

public Integer data = 1;

class Inner{

void print() {

System.out.println(data);

}

}

}

public static void main(String[] args) {

Outer outer = new Outer();

Outer.Inner inner = outer.new Inner(); // 注意内部类 new 的方式

inner.print(); // 1

outer.data = 2;

inner.print(); // 2

}

由此可见,一般内部类与外部类共享变量,并且可以对变量进行修改

方法内部类

class Outer {

public Integer data = 1;

public void fun(){

Integer funDate = 1;

class Inner{

void print() {

System.out.println(data);

System.out.println(funDate);

}

}

new Inner().print();

}

}

public static void main(String[] args) {

Outer outer = new Outer();

outer.fun(); // 输出 1 和 1

}

由此可见,方法内部类也是共享外部变量的,但是,对于方法内部的局部变量是不能做修改操作的,它可以不为final,但至少要保证不会修改它,否则编译就会报错

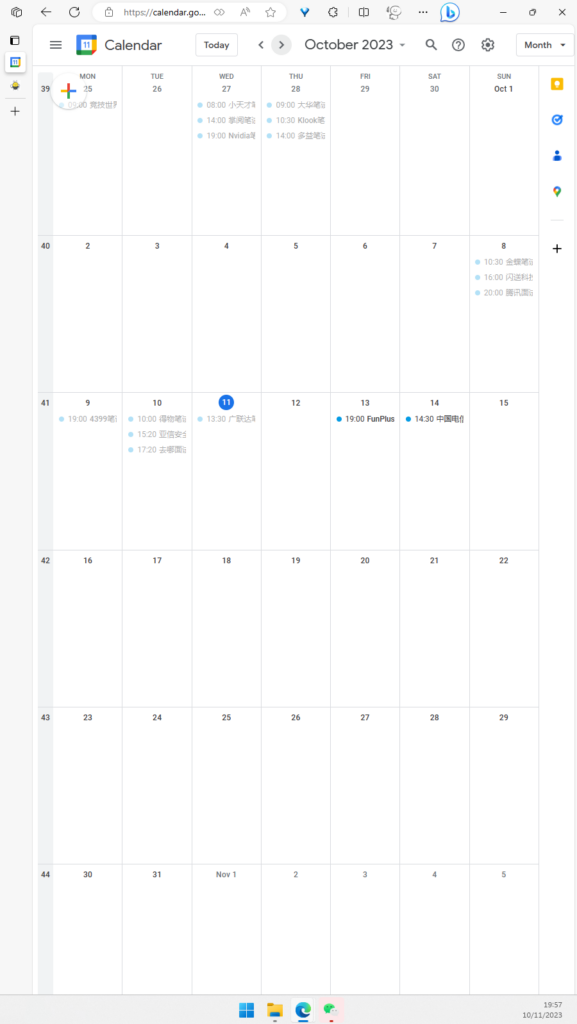

十月秋招

十一去了深圳,回来就是一场腾讯面试

怎么说呢,面试官就像个死人一样,我自我介绍完了,它就机械地开始问问题。第一个问题是说出tcp三次握手的过程,包括状态转换也说出来,我又惊又喜。惊的是这和我在牛客网上看到的面经一模一样,真是一模一样,他的话和面经中说的几乎一字不差,喜的是我特地将面经上的问题都仔细看过了,所以我就开始说了。随后的问题基本上也都是面经上一模一样的问题,但有些还是面经中没有的。有两三个问题吧,我没说上来,而且是面经中有的问题,比如建立socket连接会调用哪些函数、x86寄存器有哪些类型、DMA工作具体过程,这些面经都有,但是我没看,一是因为我觉得这和我应聘的岗位差太远了,二是我压根不敢相信面经真的就是原题,我想最起码每个人应该都会有差别吧

体验很差,面试官就像一个机器人一样,答完一题他直接问下一题,没有评价、没有过渡、两题直接可能没有任何关联、也没有任何语气或表情。

他问socket连接调用哪些函数的时候我就一再强调我不会C/C++,后面还问些什么函数的问题,还有那个epoll,我已经说过来它的三个函数,他后面还单独问我需要使用哪些函数,我一时没反应过来都懵了,我就说不知道了。

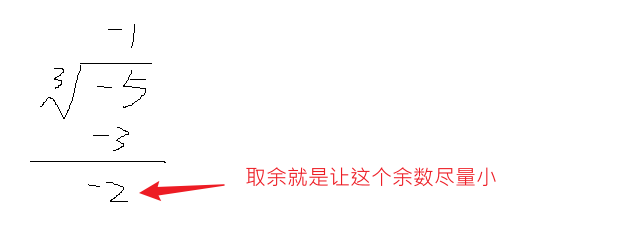

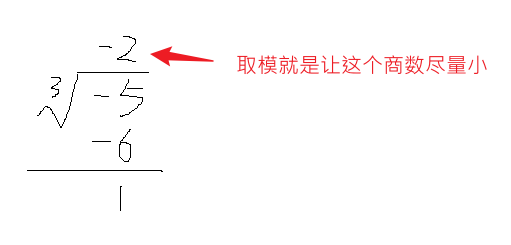

有一道算法题,也和面经上的一样,给你一个字符串表示的数,让你计算它除以另一个数的结果,面经上没说会有小数,但所幸我也找到了类似的代码,虽然那个代码也没实现小数部分,但我面试的时候写出来了,唯一可惜的是我忘记判断一个角标越界的问题,而且当时还没改,面完之后一下子就想到了。但是,面试官出题的时候说他看到我这边提示说腾讯会议版本过低无法写代码,于是让我在网上找一个在线编辑器写,我写好了发给他,众所周知,代码提交是有一定的格式的,比如实现的方法名啥的是固定的,他什么也没说,我写完就发给他,我想,如果他直接将代码复制到提交框中,肯定过不了

头天晚上八点面试的,第二天早上十点我看已经挂了

接着后面还有去哪儿面试,给我的邮件是下午五点多,因为在此之前还有另一个面试,面试结束后我就打开了去哪的面试房间,结果我正在看面经的时候面试就开始呼叫我了,当时才四点多,我想它可能是谁先进房间谁先排队吧。然后是一个女的,我还想难得见到女面试官,结果等我自我介绍完后她说这是测试开发岗位,我一看邮件,还真是,于是就说测开也是可以的,然后她就让我做一道算法题,题目不难,要是平时应该很快就能做出来,但是当时大脑有点懵,一直报错,我后面也懒得调了,然后一道sql题,然后就是问了我一个测试的问题,一个登录页面的测试点,我不知道什么是测试点,就瞎说,然后她说面完了

感觉是不怎么找得到工作了,特别是看到腾讯那么快把我挂了后,我觉得有些恍惚了,突然不知道自己在做什么,要做什么,腾讯那个我感觉不应该啊。

我越来越想去考公了,上班一个月也就那点钱,好迷茫

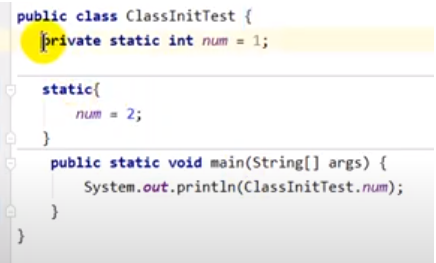

一些java面试题

对象创建过程?

首先根据字面量去常量区查找是否存在该class类,然后检查该class是否已经被加载过,如果没有则执行加载、链接、初始化的过程。然后去堆内存通过指针碰撞或者空闲列表的方式开辟内存,然后设置对象头信息(类指针、gc年龄、偏向锁等信息),最后执行 () 函数。

bool占几字节?

int占4字节,但boolean本身只占一个字节,但需要内部对齐,所以要补3个字节

为什么64位的机器下引用类型只占4字节?

本来应该是8字节,但jvm默认开启了类指针压缩,因为一个程序一般不会超过4G

Class对象是放在方法区还是堆中?

笼统地说是放在方法区,但实际上,由于jvm底层是使用c++实现的,所以每个class实际上不仅有java版的还有c++版的,c++版的是放在方法区,而java版的是放在堆中的,当创建一个对象时,它会先去堆中找class,如果找不到就去方法区找c++版的,找到的话就会在堆中创建一个java版的

双重校验锁创建单例对象是否要加volatile?

需要,因为创建对象至少由三部分组成,开辟空间赋0值 -> 执行init方法 -> 局部变量表赋值,假如后两步发生了指令重排序,那么多线程情况下可能出现使用未初始化的类,volatile可以防止指令重排序

arraylist VS linkedlist

序列化有一个很大的不同:arraylist由于存在动态扩容,所以它并不会直接将整个数组进行序列化(因为很有了可能有多的元素),而是只根据元素个数进行序列化。而linkedlist的序列化并不会存前后的指针,而是在序列化时按顺序存储,反序列化时再按照该顺序创建链表即可

插入效率也分情况:如果向最后插入数据,在涉及到数组扩容的情况下,arraylist要更慢

遍历的话:如果使用迭代器遍历linkedlist,两者效率差不多

CopyOnWriteArrayList

底层使用ReentrantLock和volatile来保证多线程安全。

copyOnWriteArrayList底层维护一个volatile修饰的数组,读时不加锁,增删改时添加可重入锁。

当修改数据时,会创建一个新的数组,并将原来的数组复制过来,再添加新元素。这个过程中,读取操作是不影响的,它还是会读取到旧值。只有修改完成后,才会将数组引用指向新修改的数组地址完成修改。并且由于有volatile存在,所以修改后立即可见。

分布式锁的实现方式有哪些?

redis的setnx、mysql的主键唯一性(不能重复添加id相同的数据)、zookeeper的临时顺序节点

redis做分布式锁需要注意什么?

加锁后要用 delete key 进行解锁、给锁设置超时时间,释放锁的过程使用lua脚本可以实现原子操作,Redisson的看门狗机制是自动给锁续期,可重入锁可能多次释放锁,故还需要一个重入计数器,集群环境下,需要对集群一半以上的设备加锁成功才算成功获取锁

base理论

不像CAP理论要么追求强一致性,要么追求高可用性。base追求在核心功能一致性的前提下尽可能使得周边功能也达到一致性

例如网络购物,一个东西是否支付成功,实际上有两个服务,第一个是真正支付的服务,第二个是给用户显示的界面。强一直性的情况下,如果支付成功了,则用户页面必须也显示支付成功,但在base理论下,核心功能是支付功能,支付成功了,但我允许页面上显示正在支付或者系统繁忙等信息,即通知页面服务不需要保证一致性

wait/notify VS await/signal VS LockSupport

wait/notify 可以认为与 Lock 的 await/signal 等价,它们的区别在于:

wait/notify 必须在同步代码块中执行,而await/signal必须在 Lock.lock() 代码块中执行

public static void main(String[] args) {

Object lock = new Object();

Thread thread1 = new Thread(() -> {

synchronized (lock) {

// ...

// 阻塞线程

try {

lock.wait(); // wait / notify 必须在 synchronized 代码块中执行,会释放锁

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

});

Thread thread2 = new Thread(() -> {

synchronized (lock) {

// ...

// 唤醒阻塞线程

lock.notify(); // wait / notify 必须在 synchronized 代码块中执行,会释放锁

}

});

}

public void test() {

Lock lock = new ReentrantLock();

Condition condition = lock.newCondition();

Thread thread1 = new Thread(() -> {

lock.lock(); // await / notify 必须在 lock() 代码中执行

// ...

// 阻塞线程

try {

condition.await();

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

lock.unlock();

});

Thread thread2 = new Thread(() -> {

lock.lock();

// ...

// 唤醒阻塞线程

condition.notify();

lock.unlock();

});

}

而LockSupport的park() 和 unpark() 方法都是静态方法,直接调用即可,并且它是基于许可证机制(内部保存了一个变量,用0和1表示是否有许可证),允许先unpark() 在 park()

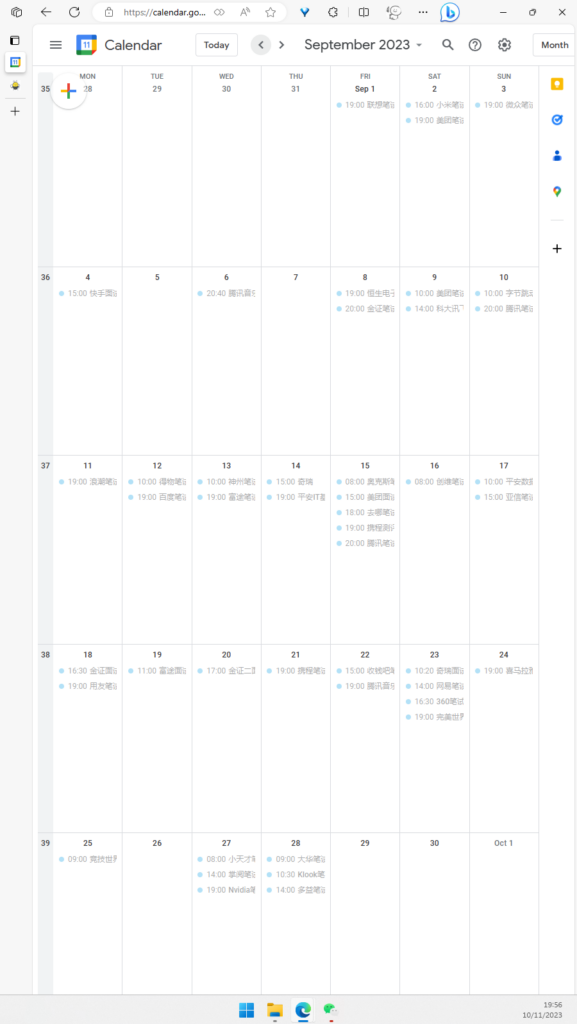

九月校招

投了快一个月的校招简历,投了不知道多少公司,不知道做了多少测评和笔试题。

面试过的只有快手和美团,而且都挂了。

美团挂得我心服口服,快手挂得我心有不甘。

美团中我嘴快了说出了一个我不熟悉的东西。

快手的面试官看起来很年轻,他问的问题也很基础。

但就那么基础的问题,他自己都不会。

是真的不会,并不是我的臆想。

遗憾的是,算法题都没做出来。

其实是做出来了,但是我没有去运行。

目前为止所有面试过程中的算法题都没写出来过。

包括之前的社招。

九月就快结束了

今明两天还有两场面试

希望自己回答问题时慢一点

多想想

别慌

加油

Paxos/Raft协议

分为两个阶段:提出提案,提出提案的值

提议者向其他的接收者提出一个提案,并且给这个提案一个编号

接收者收到提案后,先看看自己是否已经接受过这个提案,如果没有,则返回一个成功的消息,如果是,则对比已经接收过的提案编号,如果新来的提案编号小,则忽视该提案消息,如果大,则将之前接收的提案对应的值返回

提议者收到响应后,如果收到了提案的值,则使用该值,如果都只是成功消息,则提出提案的值

接收者收到提案值后,和上面的接收提案类似,如果没有同意过该提案,则返回同意,如果之前同意过,则判断新的提案编号和之前同意过的谁大,如果本地的大,就不管该提案,如果新的大,则将本地的替换成新的并返回同意

https://www.cnblogs.com/Finley/p/9787702.html

raft协议:http://thesecretlivesofdata.com/raft/#overview

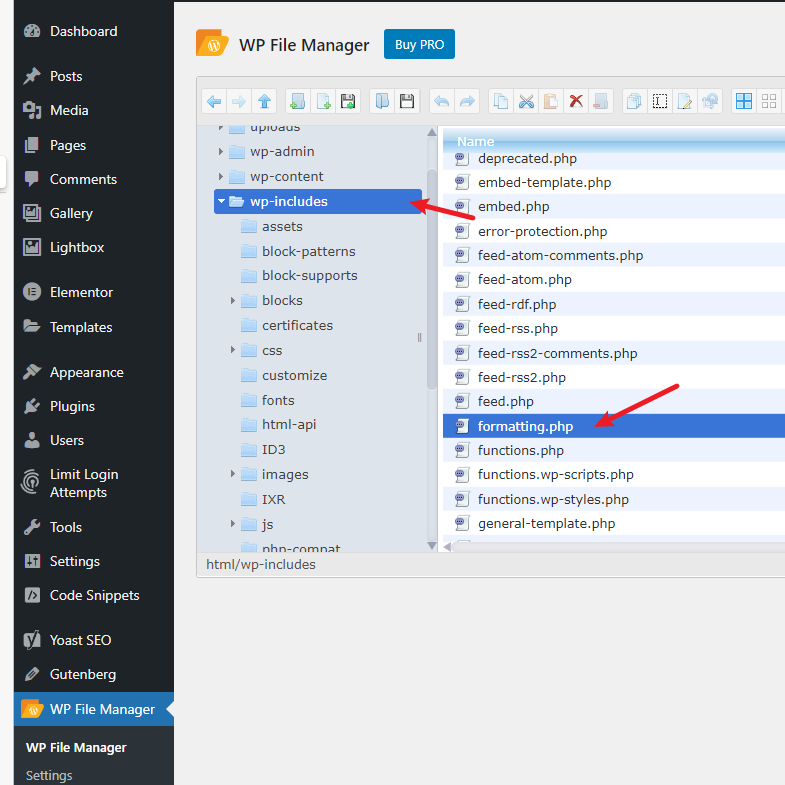

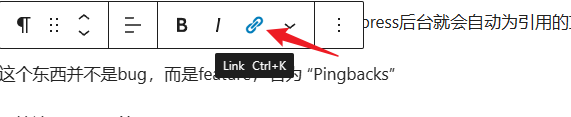

如何修改wordpress默认摘要显示长度

如果文章不写摘要,则默认将全文作为摘要,这会使得首页看起来很乱。

修改摘要显示长度的方法为:进入wordpress的wp-includes目录(主题编辑器看不到的),找到formatting.php,找到 $excerpt_length = (int) _x( '55', 'excerpt_length' ); 大概3993行,其中55就是摘要显示长度,具体来说,应该是显示block的数量,可以将其修改为1、2等较小的数,例如修改为1时,你的文章有3个block,就只会显示第一个block

注1:这个只是修改将内容作为摘要后显示的长度,如果本身就指定了摘要,则其长度不受该参数影响

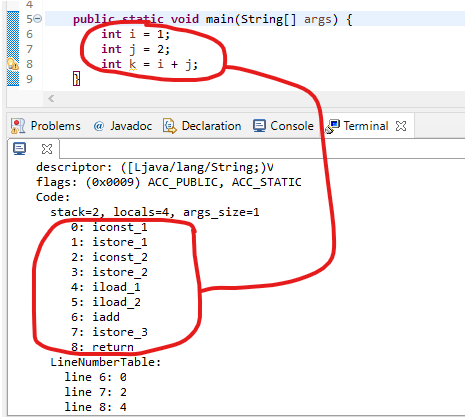

《深入理解java虚拟机》第三版笔记

- 第一款商用虚拟机ClassicVM使用的是基于句柄的对象查找方式。这样做的目的是当对象移动时不需要修改对象引用的位置。缺点是需要两次定位对象。

- GraalVM,是一个再HotSpot的基础上增强而来的跨语言全栈虚拟机,可以运行java、Scala、Kotlin等基于jvm的语言,还有C、C++、Rust等基于LLVM的语言,同时还支持JS、Ruby、Python等。GraalVM可以无额外开销地混用这些语言

- 自JDK10起,HotSpot加入了全新的Graal编译器,顾名思义,它源于GraalVM。它本身就是用java编写的,目的是替换C2编译器

- NIO引入基于Channel与Buffer的IO方式,直接分配堆外内存,避免java堆与Native堆来回复制数据

- 对象分配内存使用指针碰撞或者空闲列表的方式,具体使用哪个取决于垃圾回收器的实现。不管哪种方式都可能出现并发问题,jvm通过CAS和TLAB解决

- new对象过程:检查类有没有被加载,如果没有则先执行 加载链接初始化的过程 -> 堆内存中分配地址并赋0值 -> 设置对象头信息包括GC分代、锁状态等 -> 执行对象构造器方法

- 对象的内容包括 对象头、实例数据、对齐填充

- 对象头信息中包含markword、类型指针(非必须)、数组长度(数组类型才有)

- 实例数据中保存着对象中的各个字段内容,包括从父类继承下来的

- 不停添加栈帧是报栈溢出还是内存溢出异常?

当栈内存固定时报栈溢出(hotspot),如果是动态扩展的(classic),则是内存溢出

- 基于分区的垃圾回收器(G1、CMS等)可能出现待清理的分区中含有别的分区所引用的对象,为了避免整堆扫描,会给每个区分配一个 Remember Set 用于记录哪些对象被其他区引用,它也将加入GCroot中进行扫描。记忆集只是一个抽象接口,它的一个实现是卡表,卡表记录了分区之间是否存在对象依赖关系(只记录两个分区的依赖,并不记录分区内部具体哪个对象的依赖),卡表本质上只是一个标记数组

- 卡表是如何维护的?

如果其他区的对象引用了本区中的对象,则那个区的卡表就应该被修改,形成脏表。问题是如何实现这一过程,HotSpot是使用写屏障(和内存屏障不同)实现的,所谓写屏障,可以理解为是aop的过程,即在对象引用这个动作前后加上一段维护卡表的代码

- 进行GCroot扫描时,由于栈空间也很大,如果直接扫也很浪费时间,所以会将对象的引用专门存储到一个名为 OopMap 的数据结构中,扫描时只扫它就够了

- ParNew是Serial多线程版本,Parallel Scavenge与ParNew差不多,区别在于PS更关注吞吐量(用户线程时间/总时间),而CMS、ParNew等关注缩短单次STW的时间,两者是不一样的,缩短单次的时间意味着收集的次数变多,而每次收集都会有额外开销,所以反而使得吞吐量降低了。

- G1垃圾收集器中,为每一个region都设计了两个名为TAMS的指针,在并发标记过程中,如果有新的对象需要分配内存,就会分配到这两个指针内,这两个指针内区域的对象默认都是存活的,不会被垃圾回收

- 三色标记法如何解决并发标记过程中的动态引用变化?

CMS使用增量更新算法实现:已经标记为黑色(所有的引用它的对象都已经扫描过)对象再引用其他对象时就会被修改为灰色

G1使用原始快照算法实现:有新的引用关系建立时,就记录下这个关系,后续重新扫描这些记录

- Shenandoah是一款只有OpenJDK才有的垃圾收集器,它能实现再任何大小的堆内存中都将STW时间控制在十毫秒内,对比于G1和CMS,它不仅能进行并发标记,还能进行并发内存整理,并且其没有年轻代和老年代的区别,并将G1的每个region维护的记忆集修改为一个“连接矩阵”,便于统一管理维护。其他基本和G1差不多

- Shenandoah如何实现并发整理?

在原本的对象头前面增加一个指向该对象的指针,正常情况下,该指针指向本身这个对象,但在并发整理时,会将该对象复制到其他地方,该指针就会指向新的那个对象地址。缺点是每次对象访问都是两次定位,类似于句柄访问对象的方式。Shenandoah使用CAS的方式保证这一过程的安全

- ZGC的目标和Shenandoah相似,都是要实现不影响吞吐量的情况下,将任意堆的收集时间控制在10ms。它也是基于Region并且不设分代。区别在于ZGC的region可以动态变化,并且ZGC的并发整理要优秀很多(见下)

- ZGC的并发整理的原理?

实际上,GC过程中,很多步骤不需要知道对象的具体内容,而只需要知道对象的状态,例如在三色标记过程中,只需要知道对象之间的依赖关系,而不需要知道对象的内容。传统的做法是将一些与对象本身无关的信息记录在对象头,例如GC分代年龄、锁信息等,但如此一来,就是你只需要对象头中的某些信息,你也必须找到该对象的具体位置(因为对象头也是对象的一部分),这样会造成多余的消耗。而ZGC就是直接将一部分信息存放到对象的指针上,这样只要知道对象的指针就够了,而不用真正去访问对象的内容。这种方法称之为“染色指针”

为什么可以这样做?

因为实际上,在64位系统中,一个指针的范围非常大,而实际上现在的cpu架构也只会用到部分长度(AMD64只支持到52位长度),所以很大一分部都浪费掉了,ZGC就是利用指针的这部分空间存储相关数据

- 向 HashMap<Long, Long> 添加一个kv会额外占多大内存?

long类型占8字节,而包装称Long类型,则需要添加8字节的Markword,8字节的Klass指针,需要24字节,两个Long则需要48字节,然后这两个Long组成一个Map.Entry对象后,又需要16字节的对象头(markword和klass指针),并且Entry需要一个8字节的next字段和一个4字节的hash值(另外需要4字节填充),这一共又是32字节,然后HashMap需要有一个指向该Entry的8字节指针,所以一共占了 48 + 32 + 8 = 88 字节

java中匿名内部类和lambda的区别

对于只有一个抽象方法的接口,可以使用匿名内部类创建引用对象,也能使用lambda表达式来创建对象:

interface I {

void p();

}

// 使用匿名内部类创建对象

I imp = new I() {

@Override

public void p() {

System.out.println("aaaa");

}

};

// 使用lambda表达式创建对象

I imp = () -> System.out.println("bingo");

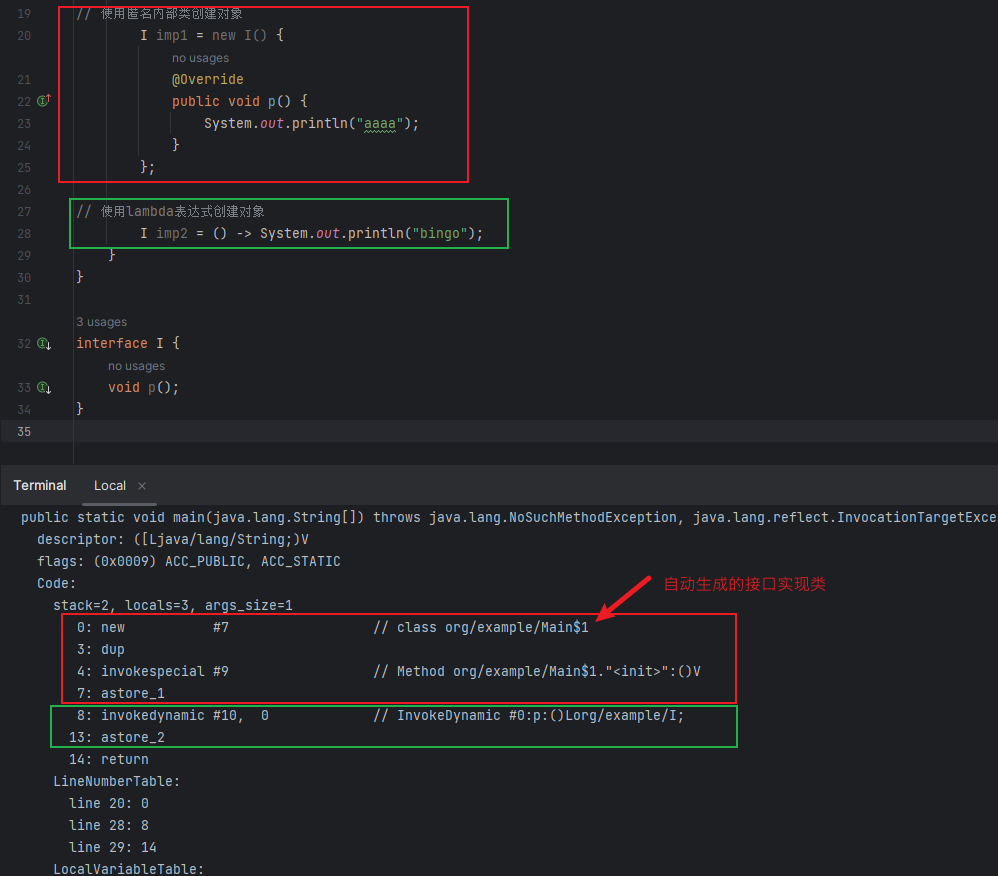

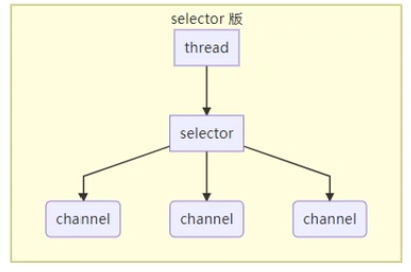

两者的区别在于:前者是在字节码层面创建了一个接口的实现类然后进行初始化,后者则使用了动态语言的特性:

如何解释这个动态语言特性呢?

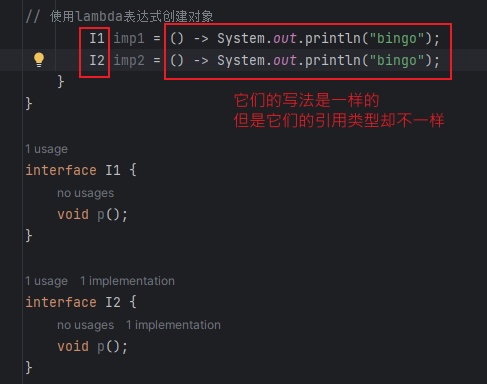

对于第一种方法,它的引用类型是固定的,即它只能是 I,不能替换成其他接口,而对于第二种,它的引用类型可以修改成任意其他只有一个抽象方法的接口

这是不是和java原本的强类型不太一样了,原本的强类型是指静态类型和实际类型一一对应,显然这里并不是这样。

为了使得java也具有动态类型的特性,jdk7引入了invokedynamic字节码指令,事实上,如果仅对于java语言来说,它早就可以通过反射实现动态语言的特性,之所以还要引入该指令,是因为反射是java语言的特性,而jvm不仅仅能运行java代码。

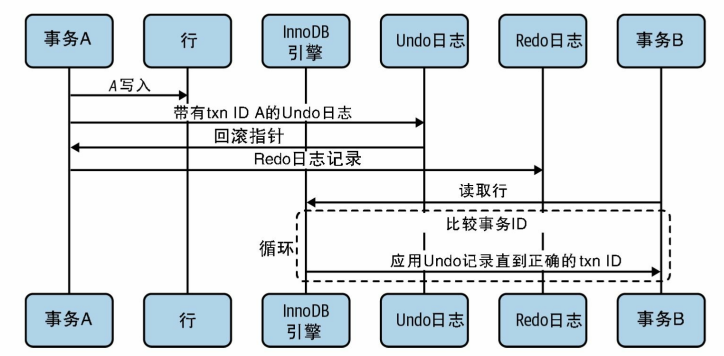

《MySQL是怎样运行的》笔记

https://book-how-mysql-runs.netlify.app/#/

结构

-

MySQL是 C/S 架构,一个服务端负责真正与储存的数据打交道,多个客户端连接服务端用于发送指令(例如SQL)

-

mysql客户端连接服务端:mysql -h localhost -u root -p12345(注:-p后面不能有空格)

服务端处理客户端请求的过程:

-

处理连接:客户端与服务器的连接方式有多种,例如TCP/IP连接、管道或共享内存、Unix域套接字

-

解析与优化:查询缓存(查询系统表时不会走缓存,8.0后不使用缓存,避免太大开销) -> 语法解析 -> 语法优化

-

存储引擎:InnoDB、MyISAM、Memory…,用于封装数据的存储和提取操作

通过上述内容可看出,mysql的架构也可以分为三层:客户端 -> MySQL server(负责管理客户端连接、缓存、语法解析和优化等操作) -> 存储引擎

查看MySQLServer支持的存储引擎:`show engines;`

存储引擎是针对表的,可以在表创建时指定,也能在创建后使用alter命令修改。

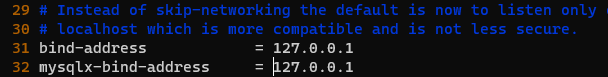

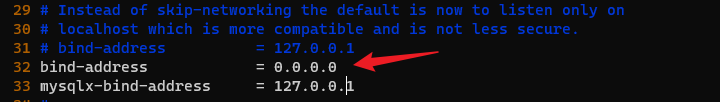

配置

在启动mysql服务端或客户端时,可以在命令后面跟上一些参数用于控制mysql的默认行为。

例如,启动mysql 服务端可以通过 mysqld -P3307 或 mysqld --port 3307 来指定端口

也可以通过修改配置文件的方式,配置文件的查找路径为:`/etc/my.cnf、/etc/mysql/my.cnf、SYSCONFDIR/my.cnf、$MYSQL_HOME/my.cnf …`

配置文件内容

类似于 .ini 文件的配置

[server]

option1 = value1

(具体启动选项。。。)

[client]

(具体启动选项。。。)

[mysqld]

(具体启动选项。。。)

。。。

不同的启动命令所能读取的配置组是不同的,例如使用mysqld启动服务端就会读取 [ mysqld]、

\[server\]两个组,使用mysql 启动客户端就会读取

\[mysql\]、[client ] 两个配置组

配置优先级

配置文件可以有多个,会一个一个加载,就像springboot一样,如果有多个配置文件都配置了同一个选项,则以最后一个为准

同一个配置文件在不同配置组中出现了相同的配置,则也以最后一个组为准

如果启动命令中有相应的配置参数,则以命令中的为准

环境变量

可以使用以下命令查看:

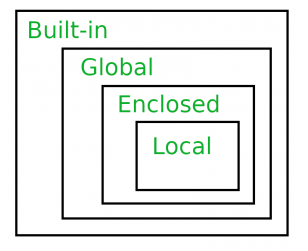

Golang GMP模型 笔记

https://www.yuque.com/aceld/golang/srxd6d

https://www.bilibili.com/video/BV19r4y1w7Nx/?p=18

本篇文章只是这个视频的一个笔记,但视频其实有非常多让人困惑的地方并没有做解释,本文也没有深究

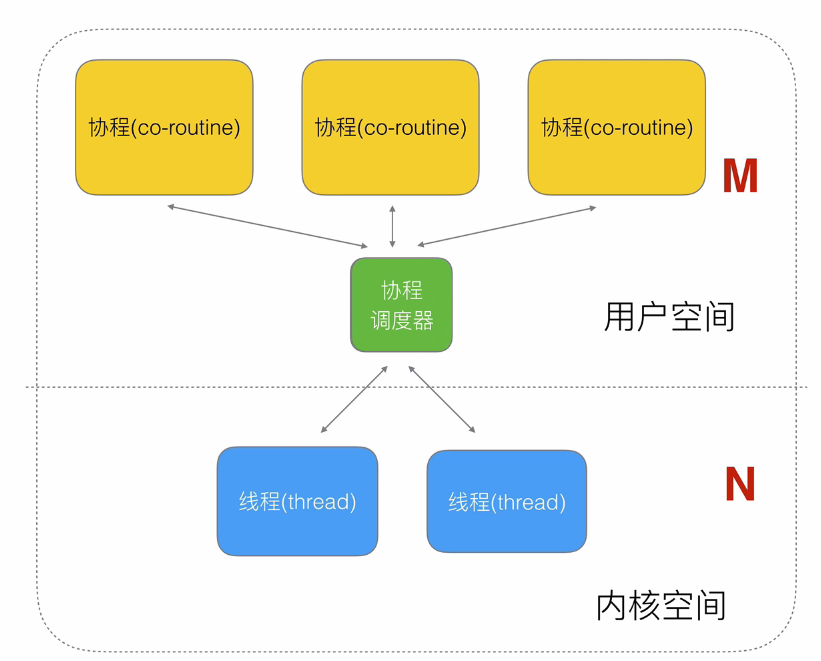

核心在于协程调度器的优化

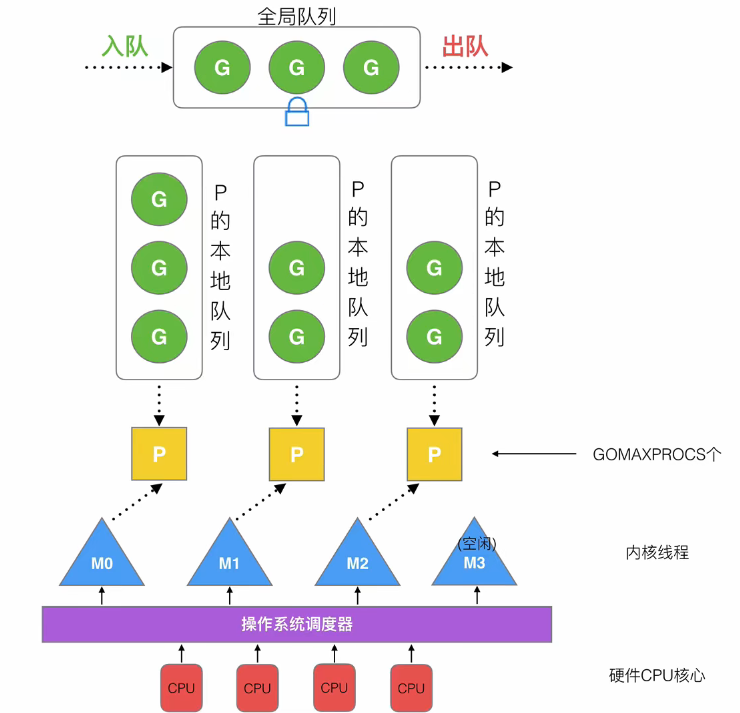

什么是GMP模型?

-

G(goroutine):协程

-

P(Processor):协程处理器,一次只能处理一个协程,每个P都有一个协程队列,用于存放待处理的协程。P的数量可以通过环境变量或代码进行设置,它的数量表示Golang在某时刻支持的最大并行量

-

M(Thread):内核态线程

另外,还有一个全局G队列,当P队列都满了就会放到全局G队列中。

Golang调度器的设计策略

1. 线程复用

work stealing机制:当某个P队列空闲时,它会尝试从其他P队列中拉取G过来执行

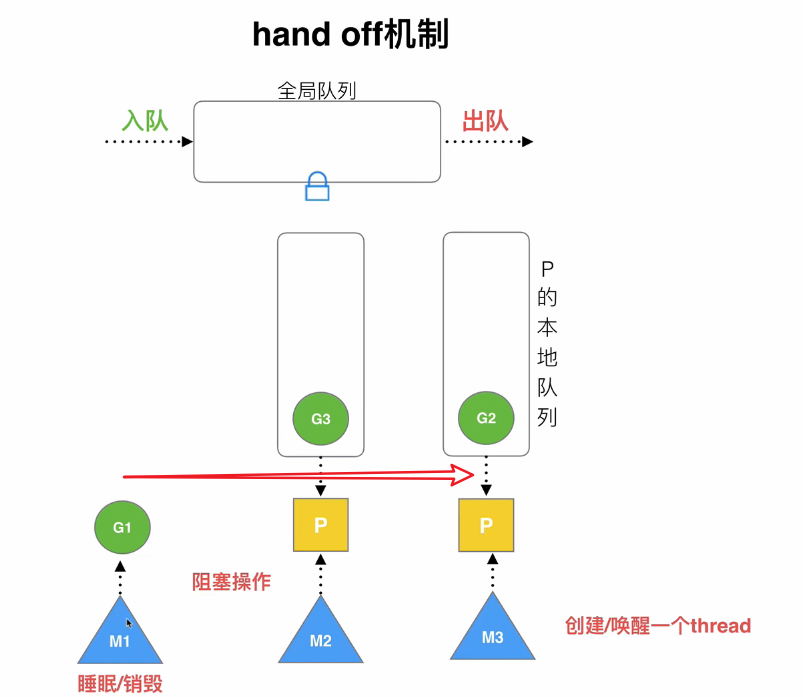

hand off机制:正常情况下,一个P和一个M相绑定执行,但是当P正则执行的G发生阻塞时(例如执行read操作),它会唤醒一个新的M并将P绑定到这个新的M上执行,而原来那个M就专门负责执行阻塞的G ,如果G阻塞被唤醒了,就会重新加入到某个P队列中

2. 利用并行

可以指定多个P,充分利用多核cpu

3. 抢占

goroutine也会存在类似进程抢占cpu的机制(不是使用的队列吗?怎么也是抢占式的)

4. 全局队列

如果空闲P无法从其他P队列中stealing G,则会尝试从全局队列中stealing一个G,这一过程涉及全局队列的加锁解锁,效率不高

M0 和 G0

go程序启动后,go的进程会创建第一个线程M0,M0 也创建一个G0用于创建Golang的协程环境,例如创建P和队列等。

每个P被创建时都会绑定一个G0用于G队列的调度,G0也会负责该P队列中所有G的调度,它不会放到P队列中,当一个G执行完成后,P会先加载其对于的G0,再由G0去它的P队列中取出G来给P执行

当开始执行main函数时,就会创建一个新的G加入到某个P队列中用于执行main的内容,当碰到go语句时,也会创建G添加到P队列中,如果P队列都是满的则会加入到全局队列中

简单来说,M0就是用来做初始化环境工作的,G0主要负责P队列中G的调度

golang中可以使用 trace 或者 GODEBUG 来查看GMP的调度信息

创建G

创建时有如下几种场景或机制:

局部性:如果某正则执行的G创建了一个新的G,很多情况下,它们可能存在一些共享资源,所以新建的G应该优先放到创建它的G所在的那个P队列

队列满:一个P队列容量是有限的(默认4G内存),如果它执行的某个G创建了非常多的G,根据局部性原则,这些新建的G都应该放到这个P队列中,如果P队列已经满了的情况下又新建了一个G,则Golang会将该P队列的前面一半G连同新建的G一起打乱顺序放到全局队列中,后一半的G就会向前移动,此时P队列就空出后一半的容量,如果再有新建的G就可以向P队列后面放,再满的话重复上述过程

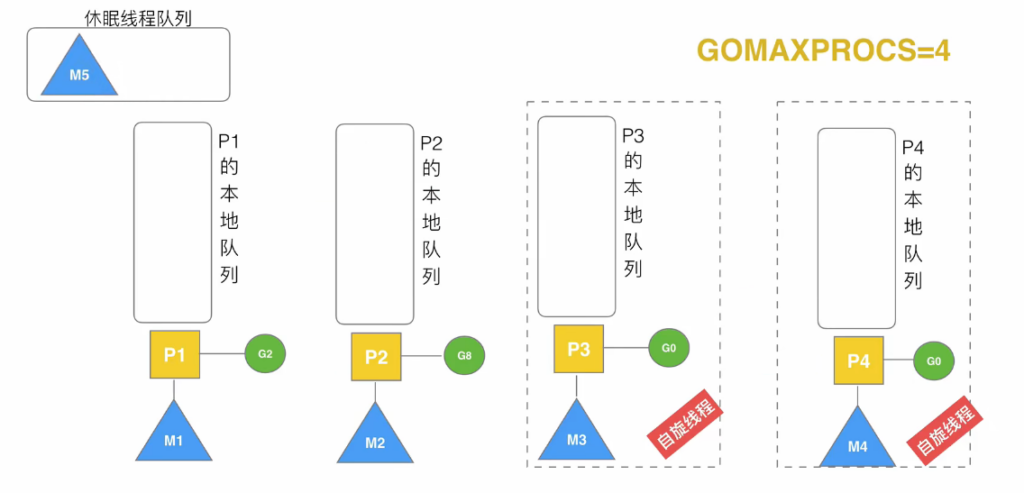

自旋线程:每当一个G在创建另一个G时,它都会尝试唤醒休眠线程中的一个线程,当一个线程被唤醒后,它会绑定一个P,并执行它的G0,不过由于此时它的P队列是空的,所以它没有任务执行,它就会忙循环,称为自旋线程。自旋的同时,它也会尝试从全局队列中拉取G,但它会一次拉取多个(拉取数量 = min(全局队列长度/p数量+1,全局队列长度/2)),并停止自旋。该过程称为全局队列到P本地队列的负载均衡

stealing:当一个P队列执行完了,且全局队列也是空的,它又成为了自旋线程,此时它就会尝试从其他P队列中偷后面一半的G

自旋线程限制:自旋线程+执行线程 <= $GOMAXPROCS,当已经达到最大限制后,新创建的M就会放到休眠线程队列中,因为已经没有P可以和它绑定了

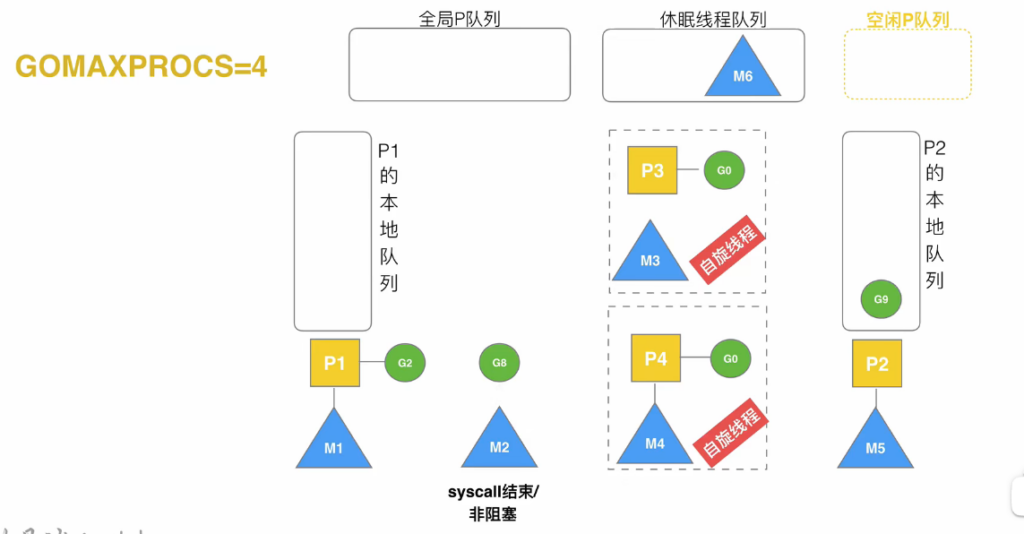

如果G8发生阻塞,P2就会重新去休眠线程队列中唤醒一个队列进行绑定,而M2负责等待G8阻塞结束

当G8阻塞结束后,它并不能直接在M2上执行,因为G必须在P上才能执行

此时,M2就会尝试 1)绑定原来的P2,但此时P2已经绑定了M5,所以失败。2)从空闲P队列中绑定一个P,但此时空闲P队列是空的,所以G8就会被加到全局队列,M2会进入休眠线程队列

Spring笔记

什么是Spring?

应该从容器和生态方面作答

什么是开闭原则:

给系统做功能扩展时,不应该修改已经写好的代码。即对扩展开放,对修改关闭

为什么要使用容器?

容器的核心功能是用于统一规范,只要符合规范的对象都可以放在容器中统一管理

Autowired和Resource的区别?

两者类似于JDBC和JPA的关系,Autowired是spring提供的注解,默认按照类型注入。Resource是j2ee提供的,默认按照名称注入

Spring中有哪些核心模块?

Spring并不是一个模块,而是一堆模块的集合,例如 Spring Core(核心类库,提供IOC功能),AOP(提供aop功能),MVC(web应用支持)等

Spring AOP的理解

能够提供哪些与业务无关的功能,降低模块的耦合度,有利于代码的扩展和维护。SpringAOP是基于动态代理的,如果要代理的对象实现了某个接口,则会通过JDK的动态代理去创建代理对象,如果没有实现指定接口,则使用CGlib动态代理生成一个被代理对象的子类作为代理对象。当然,SpringAOP也继承了AspectJ

Spring AOP 和 AspectJ AOP 的区别?

AOP是一种思想,这两者就是它的实现。SpringAOP基于动态代理,属于运行时增强,而AspectAOP基于字节码操作,属于编译时增强。

对Spring IOC的理解

对象生命周期管理权的转移,用于解耦,它是整个Spring的基础核心

Bean的创建过程?

Bean的创建过程大致为:根据配置文件或注解生成BeanDefinition —> 执行 BeanFactory 的后置处理器(钩子,对BeanDefinition做修改或增强) —> 实例化对象 —> 填充属性(populate方法) —> 设置Aware接口 —>执行 Bean 创建的前置处理器 —> 执行 init-method 方法 —> 执行 Bean 创建的后置处理器 —> 创建完成

设置 Aware 接口有什么用?

Bean在创建时,有时可能需要知道一些关于容器的信息,例如可能需要知道BeanName,或者容器中其他的Bean,总之就是需要知道和容器相关的信息,但是Bean中并没有这些信息(这个Bean就是你需要交给Spring管理的类,你的类肯定没有容器相关的信息),此时就可以让该Bean实现某个 Aware 接口,例如实现 BeanNameAware 接口,该接口有一个 setBeanName(String name) 的方法,当Spring创建该Bean时,就会自动调用该接口并传入BeanName。这些Aware接口在业务开发中基本用不到,但如果要写一些BeanFactoryPostProcessor 或者 BeanPostProcessor 则很有可能需要实现Aware接口,因为这些PostProcessor其实也是Bean,也需要放到BeanFactory中才能生效。

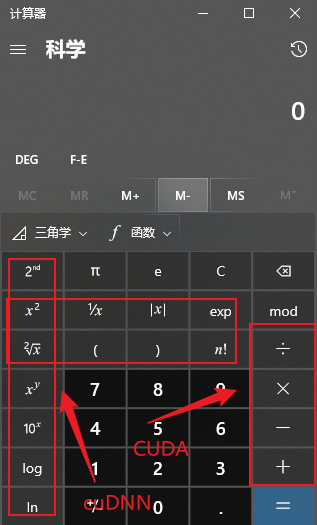

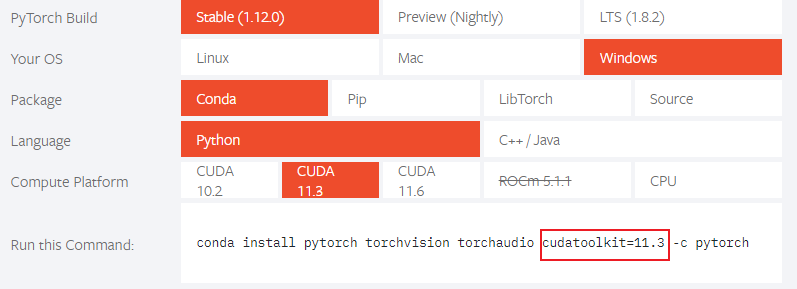

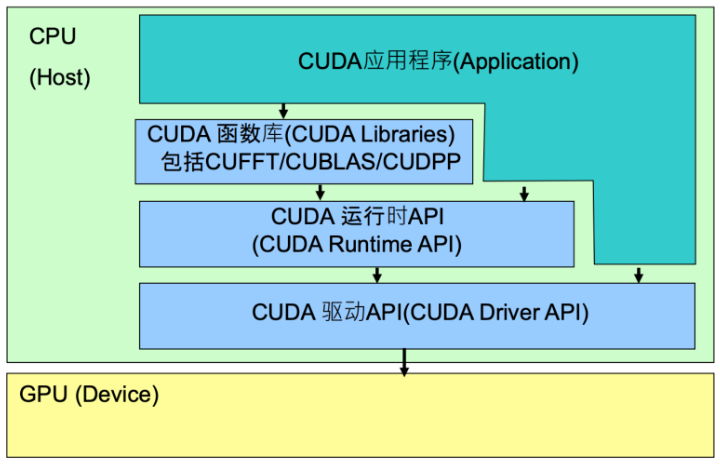

pytorch 安装

报错:

OSError: [WinError 126] The specified module could not be found. Error loading "xxx\site-packages\torch\lib\fbgemm.dll" or one of its dependencies.安装 VC_redist.X64 没用(即Microsoft Visual C++ Redistributable,这是visual c++的一个运行环境,类比java的jre)

安装 Visual Studio 就可以了,https://visualstudio.microsoft.com/zh-hans/vs/features/cplusplus/

后面可能还会报没有 numpy,安装numpy后又报 _ARRAY_API not found 错误,检查一下是不是安装的 numpy 2.x,卸载重装

python -m pip uninstall numpy # 安装 1.24.0 也会报错 python -m pip install numpy==1.26.4JUC笔记

管程:锁对象

守护线程:为其他线程服务的后台线程

JMM

该部分为 《深入理解java虚拟机》第二版 中关于java内存模型的描述

为了屏蔽各个平台的内存差异,jvm创建了java内存模型。其主要目标是定义程序中各个变量(线程共享变量)向内存读写的规则

JMM规定所有的变量都存储在主内存中,每个线程都有自己的工作内存,线程所使用的变量都是主内存到工作内存的拷贝。但它们和堆栈内存是两个概念。

主内存和工作内存间的交互通过8个java原语实现,例如如果要将变量从主内存拷贝到工作内存,则需要顺序执行 read、load 两个原语,反之,则顺序执行 store、write。

volatile

可见性

禁止指令重排序

线程读取被volatile修饰的变量会强制从主内存刷新工作线程的值,修改也将立即向主内存同步,故而保证其对所有线程的可见性

但需要注意的是可见性并不一定线程安全,因为对变量的操作并非原子操作

除了volatile外,synchronized 和 final 也能保证可见性,同步代码块的可见性是因为:变量在执行unlock之前,必须同步回主内存中。所谓可见性,实际上指的是修改后的可见性,final修饰的变量在分配内存阶段就已经赋值了,且都不允许被修改,天然保证了可见性

所谓指令重排序,当两行代码的执行没有依赖关系时,可能在执行时顺序被交换,例如:

doInitialize() intialized = true实际执行时,cpu并不知道两者存在逻辑关系,所以可能将 intialized=true 提前执行,如果其他线程要根据该变量做一些判断,则可能出现问题

其实现方法是,创建一个内存屏障,内存屏障之后的代码不会被重排序到之前执行

synchronized也能解决指令重排序带来的问题,但它并不是防止指令重排序。指令重排序带来的问题本质上是多线程下才会出现的问题,而synchronized能保证在加锁状态下,变量只能被一个线程访问

happend-before

先行发生原则描述的是,在几种特定的场景下,代码会有明确的先后执行顺序。例如:线程的start()方法一定会比该线程的其他方法先发生,在同一个线程中对某变量的操作,书写在前面的代码总是比后面的代码先发生。这些原则有什么用呢?

它们就好比是数学中的一些基本假设或基本条件,由这些基本条件可以推导出很多复杂的结论。

多线程环境下,可以由这些原则判断程序代码是否安全。

实现线程安全的方法

互斥同步

同步指多线程在访问某资源时同一时刻只能有一个线程来访问,互斥是实现同步的一种手段

synchronized是实现同步的一种手段,同时它也是一种可重入锁,即如果是当前线程已经获取了锁对象,则它下次仍然可以进入被锁的代码块中。与之类似的还有juc中的ReentrantLock,它们都是可重入锁,只是使用的语法上有所区别,ReentrantLock使用lock()和unlock()两个api实现加锁和释放锁,而synchronized使用字节码指令monitorenter和monitorexit来加锁和释放锁。另一个区别为,RenntrantLock实现了更多高级的功能,例如:

等待可中断:可以为线程设置等待超时时间

公平锁:多个线程按照先来后到顺序获得锁

Condition:Object的wait和notify的另一种实现,可以实现对其他线程的独立控制

jvm在后续改进中,synchronized的性能和ReentrantLock的性能也差不多

非阻塞同步

互斥同步本质上是悲观锁,代码进入同步区域会首先加锁,而非阻塞同步则是乐观锁,即先进行操作,如果没有其他线程争用共享数据,则操作成功,如果产生了冲突,则采取其他的补救措施

乐观锁减少的是在冲突较少的场景下,加锁解锁的开销,而在冲突较多的场景下,乐观锁比悲观锁性能更差

CAS是乐观锁的一种实现,它有三个属性:目标值地址,旧的目标值,新的目标值。只有当旧的目标值和地址中的值相等时,才会将地址中的值修改为新的目标值。但可能出现ABA问题,JUC中使用变量版本号来解决该问题。不过一般来说,这种问题并不会对程序造成影响。

无同步

如果没有共享数据,那就不用考虑同步问题。例如纯函数,或者栈上分配技术,或者ThreadLocal数据等

锁优化

自旋锁

使用忙循环来代替线程阻塞唤醒的内核态开销

但自旋只适用于短时间的共享资源占用,jdk6引入自适应自旋,当上次自旋成功获得锁后,则认为这次也可能成功获得锁而自旋,因此运行自旋更长时间,但如果很少有自旋成功的,则自动省略自旋进入阻塞

锁消除

如果经过逃逸分析发现共享变量不会被其他线程共享操作,则将锁消除

锁粗化

如果一段代码内频繁地加锁解锁,则可能优化为对整段代码一次性加锁

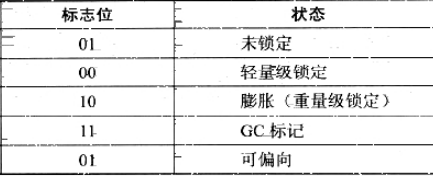

轻量级锁

对象内存布局为:对象头+数据部分+对齐填充

而对象头又分为:markword + 指向方法区Class的指针(数组的话还需要加上数组的长度)

markword在32位机下长度为32位(64位机下为64位),其中25位存储对象hash值,4位存储GC年龄,2位存储锁标志位,1位表示偏向锁是否可用。其中前25+4+1=30位内容会随着锁标志位的变化而变化,具体为:

锁标志位 前29位存储内容 对象状态 01 对象hash+GC年龄 未锁定 00 指向栈帧中 锁记录 对象的指针 轻量级锁 10 指向Monitor(管程)对象的指针 重量级锁 01 偏向线程ID、偏向时间戳、GC年龄 可偏向 11 null GC标记 轻量级锁加锁过程:

4th和2nd的区别

很多地方可以看到数字后面有一个th、nd等符号,这个东西叫做 序数词,例如:\( 1^{st} \\)、\( 4-th \)、\( 3rd \ ) 等

我之前一直以为第n个表示为 n-th,今天才注意到这个细节,原来不同数字结尾的n表示的方式还不尽相同

表示第以1结尾的数字后缀为 st,其实是first的后缀,例如 \( 1^{st} \\)、\( 21^{st} \)、\( 301-st \) 等,但以11结尾例外,表示为 \( 11^{th} \)、 \( 4611^{th} \ )

表示第以2结尾的数字后缀为 nd,是second的后缀,例如 \( 2^{nd} \\) 等,但以12结尾例外,表示为 \( 12^{th} \)、\( 76512^{th} \ )

表示第以3结尾的数字后缀为 rd,是third的后缀,例如 \( 3^{rd} \\) 等,但以13结尾例外,表示为 \( 13^{th} \)、\( 813^{th} \ )

表示第以4到9结尾的数字后缀为 th,是fourth的后缀,例如 \( 4^{th} \\)、\( 35^{th} \)、\( 47-th \ )等

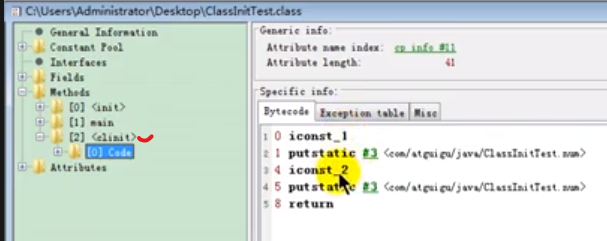

java中的动态链接

以下为我个人的理解:

在java中,有两个地方会提到动态链接,一不小心弄混了就会非常困惑

一个过程

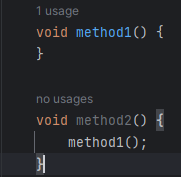

假设我写了两个方法:

method2的字节码指令为:

其中 invokevirtual 表示执行的是一个虚方法,所谓虚方法,就是只有代码在运行期间才知道真正调用的是哪个方法(final 修饰的方法除外),而不是在编译期间就确定的。

后面的 #7 指的是常量池中字符串常量的引用,将引用具体化可以得到 Method method1:()I,后面得到的这一串字符就是符号引用

为什么这里执行 method1 是一个虚方法?因为你不确定子类或者父类是否重写了该方法,所以编译期间你根本不知道它调用的到底是哪个方法。只有真正运行后,知道是哪个对象调用的该方法后才能确定应该调用谁的方法

所以在真正调用该方法前,这个被调用的方法仅仅是一个符号引用,每次只有真正调用该方法时,才会将该引用转换为所调用方法的直接引用,这个运行时才确定直接引用的过程,就称之为动态链接。

注意:这里的动态链接是一个过程,或者说是一种思想

一个引用

JVM会在调用每一个方法前,都在方法栈头创建一个栈帧,该栈帧是一种能够支持函数调用所有信息的数据结构,它是一个具体的存在。

而栈帧中会保存一个指向常量池的指针,该指针实际指向常量池中该方法的实际引用。这个指针就是动态链接。

注意:这里的动态链接是一个指针,它是一个有形的实体

方法在调用时不是已经确定了自己的引用吗,为什么还要保存自己的引用?

便于获取栈信息:例如我们在debug或者保存栈快照时,它能告诉我们栈中到底有哪些函数

函数结束执行后可以知道它的返回值是哪个方法返回的

另一种说法是方法在调用时并不会一次性加载所有的方法信息,例如异常表等,只有真正出现异常后才去方法区加载该方法的异常表,那么这个过程肯定得知道该方法到底属于方法区的哪个方法。

引自上文:Often, it is better to take a more abstract and high-level view of things. An Activation Record is a data structure that holds all the information needed to support one call of a function. It contains all the local variables of that function, and a reference (or pointer) to another activation record; that pointer is known as the Dynamic Link. Stack Frames are an implementation of Activation Records. The dynamic link corresponds to the “saved FP” entry; it tells you which activation record to return to when the current function is finished. The frame pointer itself is simply a way of indicating which activation record is currently in use. The dynamic links tie all the activation records for a program together in one long linked list, showing the order they would appear in a stack.

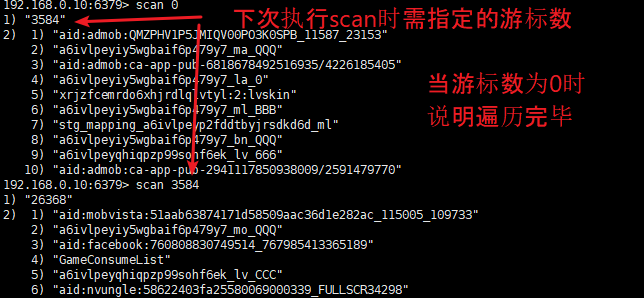

Kafka笔记

https://www.bilibili.com/video/BV1vr4y1677k?p=79&vd_source=78951f3f7dcd752bebcfd9734a584537

什么是kafka

分布式的基于发布/订阅模式的消息队列

常见的消息队列:

KafKa、ActiveMQ、RabbitMQ、RocketMQ

消息队列的应用场景:

缓冲/消峰:使用一个消息队列缓存消息,解决消费者消费速度慢的问题

解耦:不同的数据源不用单独编写特定的发送数据的代码

异步通信:有些任务并不需要实时阻塞处理,可以将这些任务丢进任务队列,然后顺序处理

消息队列的两种形式

点对点模式:消息队列中间件维护一个消息队列,生产者向其他添加数据,消费者从里面拉取数据后删除消息队列中的数据

发布/订阅模式:消息队列中间件内部维护多个不同主题的消息队列,消费者按照主题拉取数据后,不删除队列中的数据,以便于其他消费者也能拉取同样的数据

架构

生产者 Producer

注:同一个topic分为多个partition,它们直接没有主从关系,只有同一个partition与其副本之间有主从关系,所说的leader或follower很多时候指的是它们所在的那个broker

数据发送过程:

主线程获取到数据后,调用send方法(分为同步和异步方式,同步模式下下一批数据必须等待上一批发送成功后才发)发送数据,数据在发送前会先经过拦截器(校验、修改等),然后经过序列化器,得到序列化数据之后,数据被传送到分区器(因为一个topic可能有多个分区),分区器中有一个发送缓冲区,有多少个分区,缓冲区中就有多少个双端队列,数据并不是直接放在双端队列中等待发送,而是将数据放到一个16k大小的内存块(batch.size)中,如果该内存块满了或者超过等待时间(linger.ms)才会将该内存块放入双端队列中等待发送(就好比寄快递,快递车不会一次只运一个快递,而是将多个快递丢到车上,车满了才走)

发送数据的任务由Sender线程做,它使用NIO的方法与每个broker保存连接,kafka集群收到数据后将根据配置做出响应,配置有三个可选值:

0:kafka集群不需要返回响应

1:leader收到数据则响应成功

-1:leader和副本(实际不是所有的副本,而是ISR中的副本,副本可以理解为一个broker)都收到数据则响应成功

Producer收到成功响应后才会将双端队列中的数据删掉,否则会不断重试

分区 Partition

为什么要分区?

每个Partition存放在一个Broker上,如此一来分区就有两个好处:

从空间上看,可以将一个大的数据分开放在多台服务器上

从时间上看,一次就能同时生产或消费多条数据,增加了吞吐量

分区数可以大于broker数,此时一个broker就可能有多个分区,可以自动分配也能手动分配

分区策略

默认分区策略:

如果发送数据时指定了分区,则使用该分区

如果发送数据指定了一个key,则计算该key的hash,并由hash映射到某分区

如果没有指定key,则使用上一次使用的分区,如果上一次使用的分区内存块满了(16kb),则再随机选一个分区发送数据

自定义分区器:

创建一个类实现Partitioner接口,并实现其中的partition方法即可。

生产者如何提高吞吐量

主要是对以下4个参数的调整:

batch.size 和 linger.ms 两个参数的调整

数据压缩参数

缓冲区大小

如何保证发送数据的可靠性

Producer向kafka集群发送数据,可以要求集群是否返回成功结果,以及何时返回成功结果,即上文中的 0,1,-1 三个配置,可靠性最高的为-1,但会出现一些其他的问题:

follower挂了:由于leader要等到所有的follower响应成功之后才会判定成功,如果此时有任意follower下线了,leader就阻塞住了。

所以并不是要等所有的follower都同步成功,kafka会维护一个ISR队列,里面保存了所有的Broker id,并由心跳机制检测所有的broker,如果30s后broker仍没响应,则将其从ISR中剔除(ISR中包含leader和活着的follower所在的broker)。

响应成功时,只有ISR中所有的节点都成功,才会返回保存成功数据重复:如果leader收到数据后向副本同步数据后,leader还没来得及向producer返回成功信号,挂了,此时副本就会晋升为leader,由于producer没有收到成功信号,所以就会重传,但实际上此时由副本晋升的leader以及有数据了,重传后就会发生数据重复的问题

如何保证数据不重复发送

幂等配置

kafka中有个配置 enable.idempotence 用于配置是否开启幂等性,默认开启,如果开启的话,则会:

producer生产的每一条数据都会自动加上一个由 <PID, Partition, SeqNumber> 三个元素组成的tag,当该tag以及存在时,kafka集群就会将该数据丢掉。其中,PID为kafka的重启版本号,每次重启kafka都会重置,partition则为消息的分区号,SeqNumber为一个自增的数,每次生产一个消息都会自增

事务

事务是依赖幂等配置的,用于解决kafka重启后,仍然可能重复接收数据的问题(PID重置了)

大致意思就是在调用send方法后,数据并没有真正持久化到kafka集群,而是还需要调用一个commit方法来提交该事务

如何保证发送数据顺序

默认条件下,只有单分区内数据的拉取是有序的

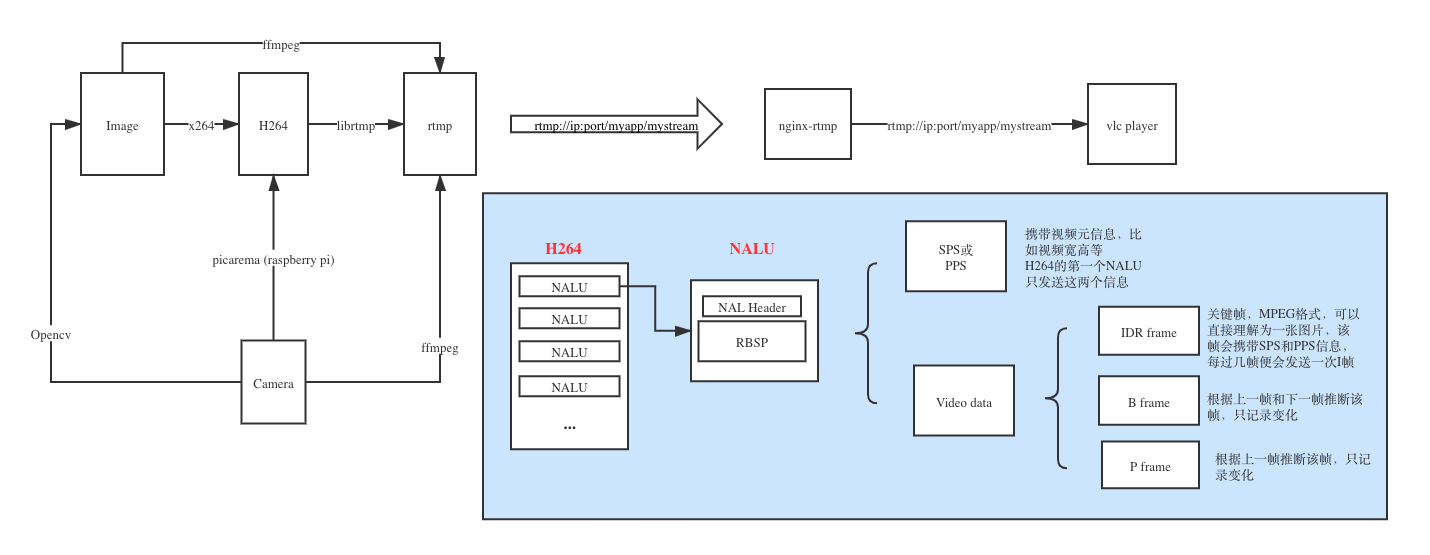

Netty笔记

https://www.bilibili.com/video/BV1py4y1E7oA

Java NIO

三大组件

Channel

两个进程共享的部分,是一个双向通道

常见的channel:

FileChannel:只能工作在阻塞模式下

DatagramChannel:用于UDP

SocketChannel:用于TCP客户端

ServerSocketChannel:用于TCP服务端

SocketChannel在进行网络通信时,会调用两个阻塞方法:

ServerSocketChannel的accept方法,用于获取新的socket连接,如果没有连接进来则会发生阻塞,它会返回一个SocketChannel对象(认为是一个socket对象,可以将其放入一个list中,后续循环调用其read方法读取数据)

但是,ServerSocketChannel可以手动设置为非阻塞模式,如此一来accept如果没有获取到连接则立即返回nullSocketChannel的read(buffer)方法,从channel中读取数据到buffer中,如果channel中没有数据则会发生阻塞

同上,SocketChannel也可以手动设置为非阻塞模式,如果read没有获取到数据,则返回0(正常返回读取到了多少字节数据)Buffer

向channel读写的数据可以放在buffer中,常用的是 ByteBuffer

channel就像一个水井,buffer就像是桶,读写数据时就可以通过桶来一桶一桶地读写

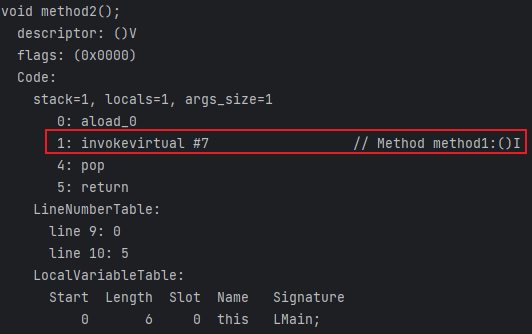

ByteBuffer本质是一个byte数组,它有三个属性:

position:当前读写指针位置,默认为0

limit:当前最大读取位置

capacity:buffer容量

buffer有读和写两种模式,两种模式必须手动切换才可使用。切换方法为 buffer.flip()

当buffer为写模式时,limit指针不起作用,数据会从position位置一直写到capacity位置

当切换到读模式时,会将limit指针指向position位置,position指针移动到0位置,读取时,从position位置开始到limit结束,position会跟着移动

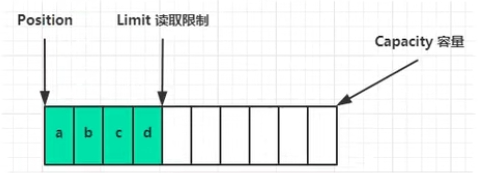

Selector

下图中,每个channel都可以看作是一个网络连接,每个网络连接可能有多个状态,例如发起连接、准备发送数据、关闭连接等,这些动作就需要线程来处理。

selector的作用就是监听这些channel的动作,如果某channel有什么事件就会告知selector,selector就会从线程池中找到一个线程来处理该事件请求,该过程称为多路复用,这种思想称为事件驱动

IO模型

阻塞/非阻塞

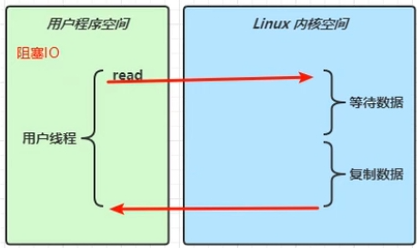

用户程序调用read方法发起了一次读取操作(读取磁盘或网卡),会调用内核空间的读取程序(用户态到内核态的切换),而内核态读取数据分为两个阶段:

等待数据:网卡中还没有数据,需要等待客户端传输,一般阻塞耗时主要在这

复制数据:将网卡中的数据复制到内存(socket缓冲区)中,相对来说很快

然后数据再由内核空间复制到用户空间

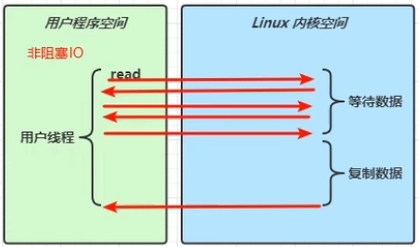

阻塞和非阻塞的区别在于:

阻塞:用户程序的read方法会一直阻塞知道数据复制回用户空间

非阻塞:在内核态等待数据的阶段,用户程序会不断调用read方法进行查询网卡是否有数据,在复制数据阶段仍然处于阻塞状态

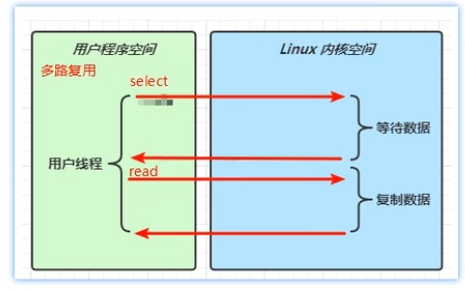

多路复用

用户程序调用selector的select方法,该方法会阻塞在内核态的等待数据过程,一旦有数据发送过来,selector就会告知用户程序,再由用户程序发起read方法读取数据,此时就可以直接复制网卡中的数据了,这一过程也是阻塞的,但是复制数据的耗时一般远远小于等待数据的耗时

异步io

selector接收到读写事件后,如果是直接在当前线程完成读写操作就是同步io,如果是使用其他线程完成读写就是异步io

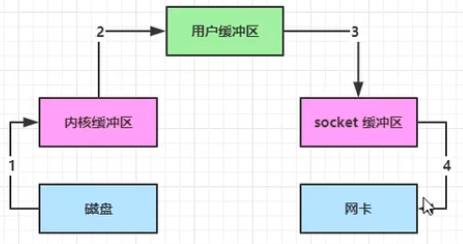

零拷贝

将一个文件内容发生到网络需要执行4次文件复制,读取网络数据同理

java中NIO的channel可以调用transferTo/transferFrom两个方法实现优化,它们在操作系统层面会调用内核的sendFile的方法,该方法可以将内核缓冲区和用户缓冲区统一(或者说不需要用户缓冲区),直接将文件从内核缓冲区复制到socket缓冲区,减少了两次文件的拷贝

到linux2.4版本后,sendFile方法实现了进一步优化,连socket缓冲区都不需要了,直接从内核缓冲区复制到网卡中。

上述这两种方法都是零拷贝,所谓零拷贝,其实说的是在用户态的零拷贝

阻塞/非阻塞 具体实现

以下为阻塞/非阻塞伪代码:

# 单线程实现非阻塞网络io ServerSocketChannel ssc = new ServerSocketChannel(ip, port) ssc.configureBlocking(false) # 配置为阻塞/非阻塞模式 List channels = new ArrayList() while true: SocketChannel sc = ssc.accept() sc.configureBlocking(false) # 这里也可以使用多线程处理,让每一个channel都单独创建一个线程处理 if sc != null: channels.append(sc) for channel in channels: int readCount = channel.read(buffer) if readCount > 0: print('data: ' + buffer.data)上述代码虽然可以使用单线程或多线程实现并发请求处理,但仍存在一个缺陷,如果长时间没有连接请求,而整个代码仍然会不停执行while true循环代码,对cpu来说是一种浪费,一个好的解决方法是如果没有请求或数据写入,则线程阻塞,如果有请求或数据写入则自动唤醒线程,由此可以使用selector

印象笔记莫名奇妙出现很多登录设备

刚才想看看我之前的笔记,发现网页上很多笔记都显示不全,有些图片不显示,有些显示一半,有些甚至显示不出来,于是我就下载它的客户端,希望会好一点,刚登陆账户上去它就提示设备已经超过2台,需要先撤销其他设备授权才能继续,否则就强制退出

目前为止一切都还在预料之中,之前也是这么烂,于是我想撤销就撤销吧,于是就出现了这个:

我满脸问号,我啥时候登录过这么多设备了,而且这两千多台设备都集中在12月10/11号两天,而且每台设备手机型号都不一样。。。

先不说这些设备是哪来的,它竟然没有提供一个一键撤销的按钮,我一开始还没注意到两千多台,我还想着一台一台点一下撤销,但是,我确定我这是印象笔记而不是evernote,点即撤销访问按钮后,连接就一直转圈,靠点击去撤销这些设备是不太可能了,以后再用印象笔记也是不太可能了

我之前用印象笔记写了很多东西,尤其是一些开发相关的技术,之所以用它是因为它当时支持markdown,但是,该说不说,它的markdown文本一旦写的东西多点,整个文档就写不动了,十分地卡

而且经常会丢失一些内容,之前我倒一直以为是我自己没写或者只写了一半,后来发现是真的丢失内容

后来我也想尝试使用其他的笔记软件,稍微好点的就是notion,但它毕竟是国外的,而且也是处于发展初期,后面怎么样就不好说了,而且它仍然是有各种限制

这也是我现在都使用自建的wordpress和memos的原因

MySQL笔记

存储引擎

MySQL的结构:连接层 -> 服务层 -> 引擎层 -> 存储层

各存储引擎的特点:

InnoDB

支持 事务、外键、行级锁

MySQL中,数据库对应文件系统中的一个文件夹,每个InnoDB表都对应该文件夹下的一个 .ibd 表空间文件,该文件用于存储表结构、索引、数据

表空间文件存储的逻辑结构为:

一个表空间下存放多个段

一个段下存放多个区,一个区大小为1M

一个区下存放多个页,一页大小为16K

一个页下存放多个行

一行就表示表中一行数据,需要注意的是,除了本身就有的字段外,还额外有 事务id 和 Roll指针

MyISAM

不支持事务、外键、行级锁,支持表锁

在文件系统中以三个文件表示:.sdi(表结构) .MYD(数据) .MYI(索引)

Memory

数据存放在内存中,支持hash索引

只保存一个 .sdi 文件,用于保存表结构数据

索引

索引能提高查询速度,但会拖慢增删改的速度

索引设计原则总结:

索引结构

B+树索引:三个存储引擎都支持

Hash索引:只有Memory支持,高效率,不支持范围搜索,不支持排序

B树和B+树的区别:B+树所有数据都存放在叶子节点中,并且叶子节点形成一个单向链表。MySQL中,将单向链表修改为双向链表

为什么MySQL使用B+树做索引?

不管是用B树还是红黑树还是B+树,每个节点都需要保存在页中,而一页的大小是固定的(16K),如果在里面存放数据,则一页就存不了多少索引,而B+树只存放索引,故可以存放更多索引,层级更低,且将叶子节点连接可以用于顺序搜索

索引分类

索引类型:

主键索引:只能有一个

唯一索引:可以有多个

常规索引

全文索引

根据存储形式,又分为:

聚集索引:必须有且只有一个,叶子节点存放行数据。默认是主键索引,如果没有主键,则使用第一个唯一索引,否则自动生成一个rowid作为隐藏列当作聚集索引

二级索引:可以有多个,例如对任意列手动创建的一个普通索引。叶子节点存放主键,此时需要回表查询(根据主键再去查聚集索引)

索引操作

# 创建索引,加上 UNIQUE 表示创建唯一索引,索引可以指定多列,及为联合索引 CREATE [UNIQUE|FULLTEXT] INDEX index_name ON TABLE_NAME (col1, col2...) # 查看索引 SHOW INDEX FROM TABLE_NAME # 删除索引 DROP INDEX FROM TABLE_NAMESQL性能分析方式

慢查询日志

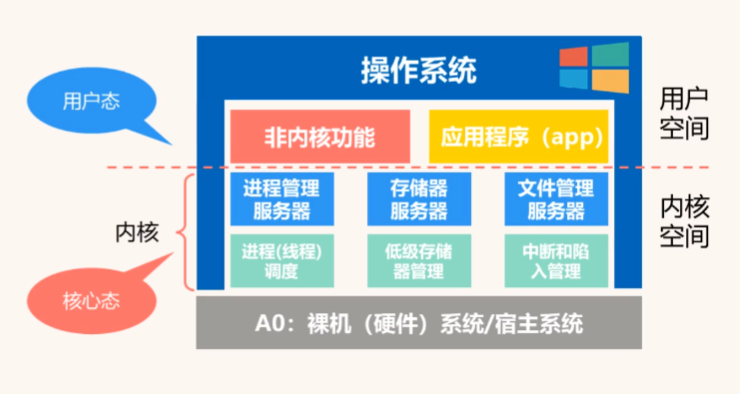

操作系统笔记

并发:一段时间内可以同时执行多个程序

并行:一个时刻时可以同时执行多个程序

操作系统的虚拟化技术:CPU的虚拟(时分复用)和磁盘的虚拟(空分复用)

分时操作系统:允许多用户同时操作系统,微观来看是时间切片(CPU的虚拟)

实时操作系统:分时操作系统没有重要性的概念,实时操作系统会对高优先级的程序实时响应

用户空间与内核空间:

所谓用户态与内核态的切换指的是:cpu执行的是用户空间的程序指令和内核空间的程序指令间的切换,例如我开发出一个程序,这个程序生成的指令都是用户空间的指令,如果程序需要调用文件资源,就会切换到内核空间的文件管理器指令,本质上是切换到了另一个程序,由于这个程序是内核空间的,因此这里需要一次用户态与内核态的切换。

用户态切换到内核态只能通过中断实现

为什么需要中断机制?

提高并发情况下CPU的利用率,例如某程序执行io时,可以中断切换到其他程序

外中断与内中断:外部设备引发的中断为外中断,例如敲击键盘。而内中断是指令执行过程中自己发出的,例如程序需要读取文件时会发送一个中断(陷入指令)切换到内核态的文件管理器程序,或者程序出现异常情况等。

中断处理流程:

保存当前上下文:保存当前执行的寄存器中的内容,并找到中断程序地址

执行中断程序

恢复原始上下文

什么是原语:一小段程序,由多条指令组合在一起,执行过程中不能被中断,就可以理解为一个函数或指令

高内聚低耦合:

高内聚:模块内的代码高度相关

低耦合:模块间的关系独立性好

进程管理

进程是程序一次执行过程的实体,是系统进行资源分配的最小单位

线程(轻量级进程):必须存在于进程中,是操作系统运算调度的最小单位

为什么引入线程?

为了提高OS的并发性

注意:进程中多个线程共享进程资源,线程并不拥有资源,只有资源的使用权,如此一来线程的切换开销比进程小很多

进程是如何运行的

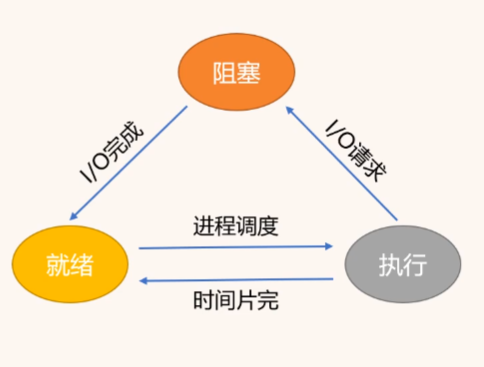

进程状态

三种基本状态:就绪(可以运行,等待CPU执行时间片)、执行、阻塞(等待IO操作、同步操作等完成)

另外还有创建和终止状态,创建完成后就会进入就绪状态,执行完成后或者出现异常退出就会进入终止状态

进程控制

OS通过原语操作实现进程控制(创建、撤销、挂起、阻塞、唤醒、切换),原语是由若干条指令组成的原子操作。可以理解为一个事务函数

例如,要将执行状态的进程转换为阻塞状态,则可以使用block原语,由阻塞转换到就绪使用wakeup原语

为了系统和用户观察分析进程,或者暂时不需要使用某进程,就可以使用suspend原语将进程挂起。例如,edge浏览器中,每次开启一个新的tab都会创建一个进程,假如某个tab长时间没打开,系统就会将该tab的进程挂起

与挂起相对的就是激活

只有创建、就绪、阻塞这三个状态才能被挂起,执行和终止状态不行。

挂起状态和另五种状态的不同在于,挂起状态会将进程所占的内存转移到外存(磁盘)上去,所以它不属于进程运行的状态(进程运行必须在内存)

进程调度

只有进程数远远大于内核数,才会出现进程调度。进程调度的目的是减少cpu空闲时间

调度方式:

抢占式调度:立即暂停当前进程,将cpu分配给其他进程,这种情况一般有 出现优先权更高的进程、时间片到了、有些进程所需时间很短,可能会先让它执行

非抢占式调度:等待当前进程完成或阻塞才执行

调度过程:

保存当前进程的context

切换进程

恢复原进程

调度算法:

先来先服务:就绪队列中,先进来的先分配cpu。有利于CPU繁忙进程,不利于io繁忙进程

短作业优先:先估算各进程所需时间,选择时间短的进程先执行。周转时间短,但估计可能不准确,长时间进程长时间得不到执行

高响应比优先:(等待时间+预估耗时)/预估耗时,值越大优先级越高

优先级调度:可以手动或自动设置调度优先级,低优先级可能长时间得不到执行

*时间片轮转调度:给就绪队列中的每个进程分配一个时间片,时间片到了就执行下一个进程的时间片,由时钟中断确定时间片是不是到了。本质上仍然需要排队。因此时间片设置多长就很重要。

*多级反馈队列调度:结合了上面 1、2、3、5 的优点,解释如下:

多级反馈队列调度:

初始化多个就绪队列,每个队列的优先级从高到低,每个队列中进程分配的时间片长度由短到长。新创建的进程都会放在优先级最高的队列中。cpu每次都从不为空的最高优先队列中pop出队顶进程,执行当前队列对应的时间片后将其放到下一级的就绪队列队尾。

如此一来有几个好处:

所有的进程都会被快速执行一次,不存在长时间得不到执行

也符合先到先服务原则,更公平,响应速度更快

耗时较长的进程优先级会逐渐降低,耗时较短的进程会更优先完成

也满足一定的实时性要求,一般来说,有实时性要求的作业大部分都是短作业,这个算法对短作业的优先级较高

进程协作

进程通信

共享空间:由操作系统提供一块公共的内存区域(提供一个队列数据结构或直接提供一块内存)。由于所有进程都可见,可能不安全

消息传递:每个进程维护一个消息缓冲队列,其他进程给它发消息就能放到这个队列中

管道通信:类似共享空间的方式,给两个进程之间创建一个管道(固定大小的缓冲区),不同点在于这个管道只能单向读写,并且读写过程互斥。若要双向读写则需要创建两个管道。

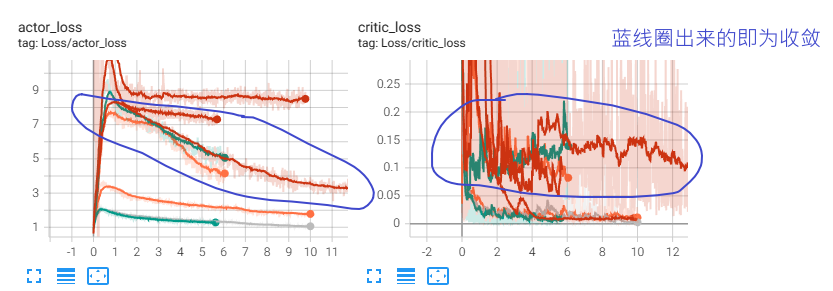

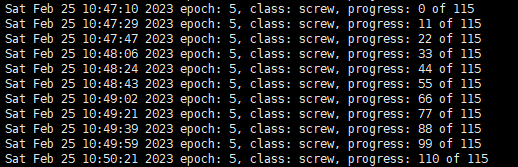

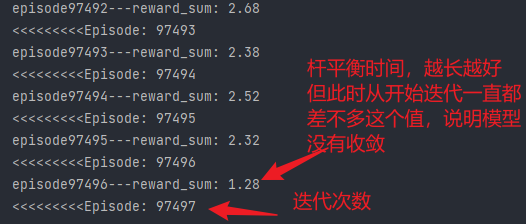

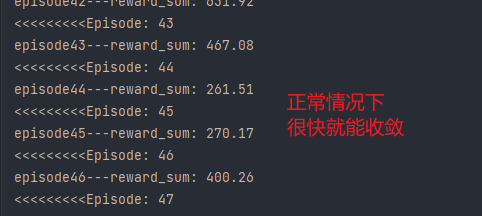

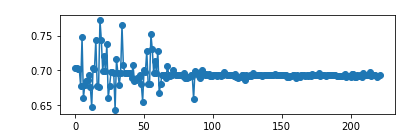

DDPG训练时如何判断有效收敛

注:本文没有给出真正的答案,只是作为一个记录

有效收敛是我自己创造的词,例如在训练过程中,模型收敛到输出与输入无关的状态,或者其他意料外的状态则为无效收敛,反之为有效收敛

DDPG的基本思想是 先训练一个critic,然后使用该critic训练actor,接着再用该actor训练critic。。。不停迭代,和GAN类似

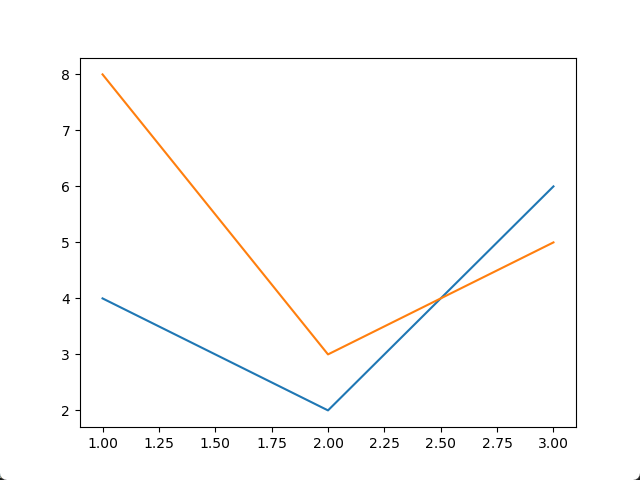

DDPG用到了一些trick,但我在实验中发现,对于某些任务,一些trick是无效的,为了验证哪些无效,我做了一些对比实验,本文目的不是记录这些实验,而是对比有效和无效的情况下,critic loss和actor loss的不同,我觉得这应该也能作为判断是否有效收敛的一个依据。

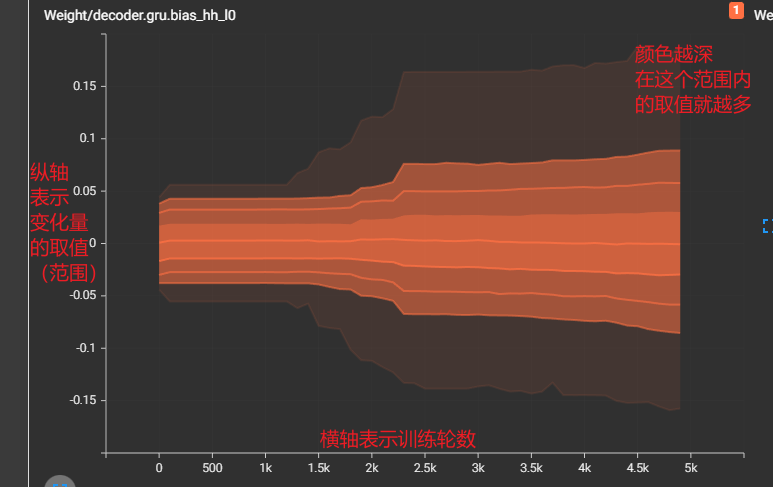

该实验可以通过critic loss明显看出有效收敛和无效收敛的区别:有效收敛的critic loss一直处于波动状态,并且不会收敛得很快,而出问题的那几个反而很快就收敛到0附近了

我想这应该是有一定道理的,因为critic和actor相互轮流训练,两者互相依赖,所以critic loss不应该收敛很快,因为actor一直在变。收敛很快很有可能出现 输出与输入无关 的情况,例如agent玩lol时,无论开始选择什么英雄,agent都会选择直接送塔,以避免被杀带来的损失。

计算机网络笔记

https://www.bilibili.com/video/BV19E411D78Q?p=75&vd_source=78951f3f7dcd752bebcfd9734a584537

计算机网络的分类:

按分布范围:广域网 WAN、城域网 MAN、局域网 LAN、个人区域网 PAN

按交换技术:电路交换(就像电话线一样,通信时独占线路)、报文交换、分组交换(这俩组合起来就是,通信路径被分割成多个节点的转发,数据也被切分为一个一个的报文,这样就不用独占一条线路且可以同时发送多条数据)

按传输技术分:广播式网络、点对点网络(使用分组存储转发和路由选择机制,两台计算机通信可能经过多个节点,并且数据只有目的主机才能收到)

性能指标

速率、带宽(宽带是网络设备支持的最高速率)、吞吐量(单位时间内通过某网络节点的数据量)

时延:发送时延(发送设备带宽限制)+ 传播时延 + 排队时延(路由器可能处理不过来,数据先放在缓存中等待) + 处理时延(检错、找出口等)

时延带宽积:传播时延 * 带宽 可以用来计算某一时刻,链路中存在的比特数

往返时延RTT:从发送方发送数据开始,到发送方收到接收方的确认信息(立即返回)。传播时延 * 2 + 接收方处理时延

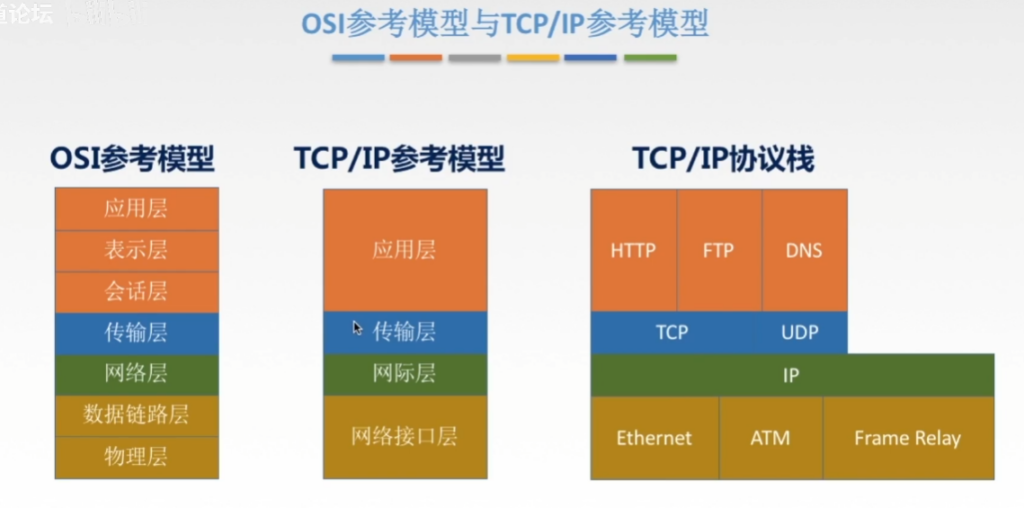

分层结构

主要目的是将网络中出现的大问题分解成各种可能的小问题

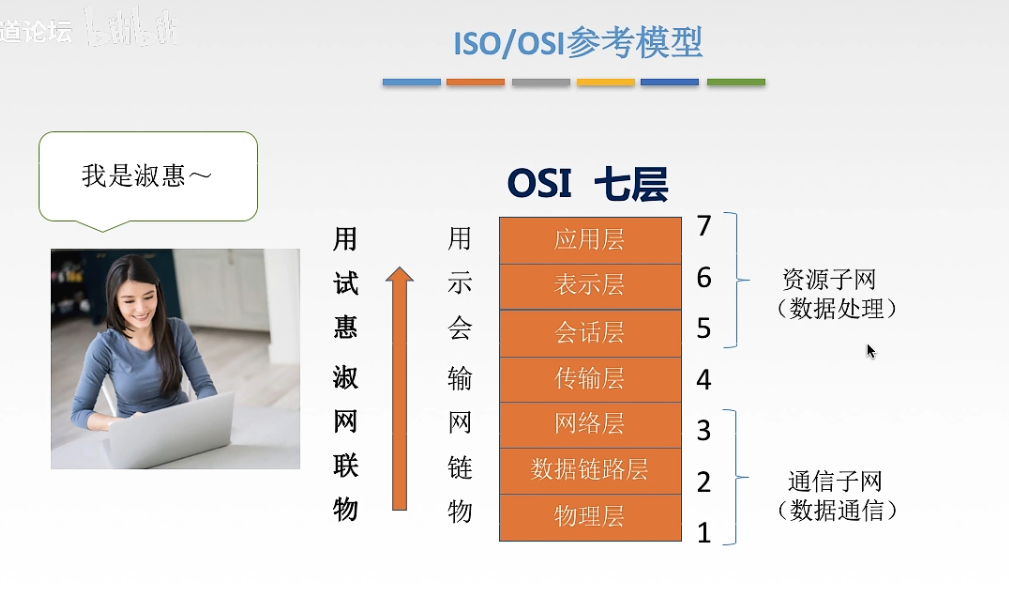

法定标准:OSI七层模型

事实标准:TCP/IP四层模型

两者结合可以总结出5层体系

数据在传输过程中,在中间系统(路由器、网桥等)会解码到第3层,源/目的主机会解码所有的7层。

应用层:

和用户交互并能产生网络流量的程序,例如浏览器、邮箱等

典型的应用层服务有 文件传输(FTP)、电子邮件(SMTP)、万维网(HTTP)等

表示层:用于数据解码和加密等,例如 JPEG、MP4等文件格式都算是表示层协议

会话层:。。。

传输层:负责主机两个进程的通信,传输单位是报文段或用户数据报,主要协议:TCP/UDP

》功能:可靠/不可靠传输、差错控制(数据传输出错怎么办)、流量控制、复用分用(使用端口号区分数据报的目的程序)

网络层:将数据从源发送到目标端,IP、IPX、ICMP、ARP等协议

》功能:路由选择、流量控制、差错控制、拥塞控制(流量控制是针对某端口的,而拥塞控制是针对整个网络的宏观控制)

数据链路层:将网络层传下来的数据报组装成帧

》功能:定义帧的开始和结束(一堆01中哪些是开始哪些是结束)、差错控制(帧错、位错等)

物理层

解决如何在连接各种计算机的传输媒体上传输“数据比特流”,功能是确定传输媒体接口有关的特性,例如接口形状、引脚数目、电压范围、传输速率等

单工通信:只有一条信道,且信息只能单向传输

半双工通信:只有一条信道,但通信双方都可以发送和接收信息,同一时刻只能单向流动

全双工通信:两条信道,双向同时通信

什么是码元?高低电平可以表示1和0,高低电平就是两个码元,但我可以直接使用电压表示更多的数,例如0-3v表示01,3-6v表示11,6-9v表示10,9-12v表示00。那么这里一个有四个码元,一个码元就能表示两位数了,一次就能传输更多的数据。

香农定理可以计算出信道在有噪声的情况下数据传输速率的上限。

基带信号和宽带信号:将信号调制为数字信号进行传输就是基带信号,如果是在模拟信道上传输就是宽带信号。近距离一般使用基带传输,远距离使用宽带传输(不是数字信号更适合远距离传输吗?)

编码/解码:数据转换为数字信号

调制/解调:数据转换为模拟信号

报文交换和分组交换:数据在发送途中会经历很多的路由设备,某设备在接收到数据后先将数据存储起来然后排队转发,对报文大小没有限制就是报文交换,有限制就是分组交换(将原来一个大的报文分割成小报文并行发送)。之所以要限制是因为路由设备的容量是有限的

分组交换将源报文切割后还需要进行编号,避免乱序

这两种交换方式典型特征是数据在某路由器的下一跳在哪是不一定的(即使是同一台目的主机,因为有些路由器可能突然比较忙,就需要绕道),与之对应的就是电路交换,它会先确定一条完整的线路。

中继器:信号在传输时会出现损耗,中继器就是对信号进行强化还原

集线器:也叫多口中继器,将输入信号还原后发给其他所有的端口,跟总线一样,把所有设备连接在一起

一个集线器连接的所有设备构成一个冲突域,即任意时刻只能有一台主机能够发送信息

数据链路层

将数据封装成帧并透明传输

封装成帧:将原本的数据头和尾加上帧边界符

透明传输:要发送的数据内容不会影响传输过程,即数据对数据链路层是透明的(例如假设数据中包含了帧边界符的比特码应该有相应的处理方式)

如何做到透明传输?

字符计数法:以一个数字开头记录一帧的长度,但如果一个长度记录错误后面的全错

字符填充法:以特定字符标记帧起始和开始位置,数据中出现的边界符前加转义字符

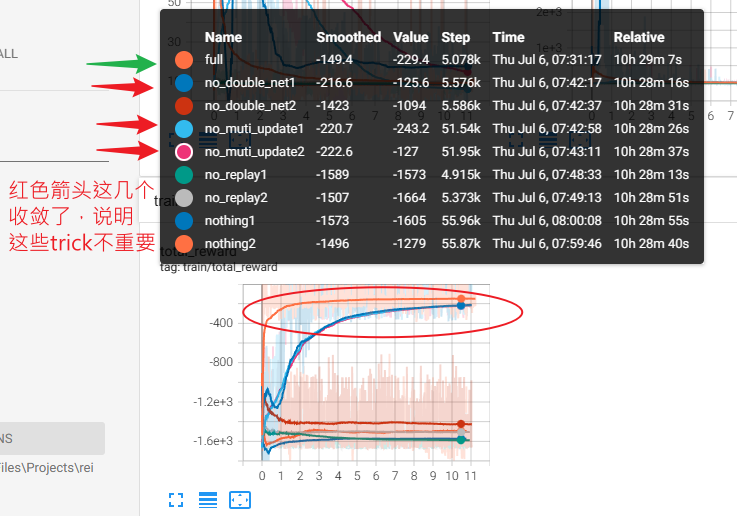

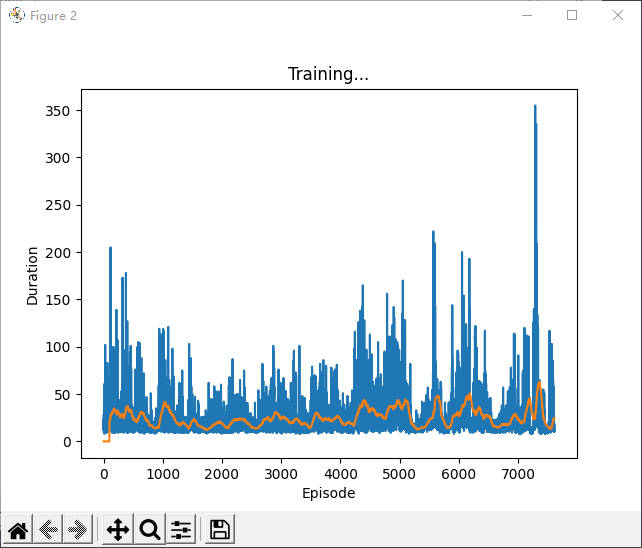

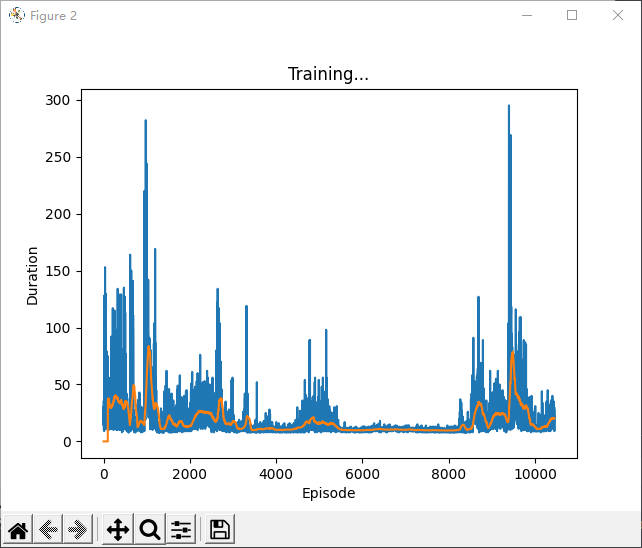

DDPG中各trick效果对比

本实验仅仅是一个简单的实验,用于比较在 “Pendulum-v1”(gym提供的一个小游戏,用于训练RL模型)环境下,使用:

double net:critic和actor都拷贝一个副本,并延迟同步参数,在计算目标q值时使用改副本进行计算

每轮迭代次数:之前都是一局游戏结束就从历史数据中sample一批数据更新一次网络,而这里就是进行多次sample然后更新多次

replay buffer:将之前采样的数据都保持在一个队列中,训练时就从队列中随机采样数据

三者对模型训练性能的影响。注意:这个实验的结果并不能说明太多问题,不同的环境下,它们的作用肯定也不尽相同,我也仅仅是做一个记录而已。

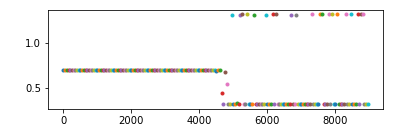

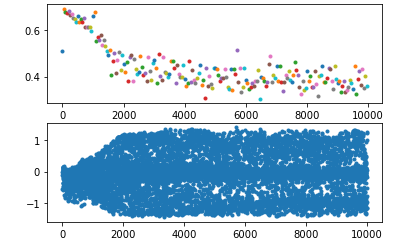

下图为各组实验在运行几个小时之后,在游戏中可以得到的reward

以full(所有trick都用上)作为对比,每个实验都做两组(上图中name后标有1,2),实验表明,在没有 “muti_update”(每一局游戏结束后,都对模型进行n轮训练,数据也都是历史数据中sample) 时,性能不会下降,只是比full收敛更慢,说明它不是很重要,只影响收敛速度,而不用 double net 时,一次可以达到理想水平,一次每练出来,即使是达到理想水平那一次,也可以看到其前面有一个不小的波动,也说明了 double net 可能对模型训练的稳定性起到了一定的作用,而没有 replay buffer 的两个实验和什么都没有的两个实验都gg了,可能说明了replay buffer的重要性。

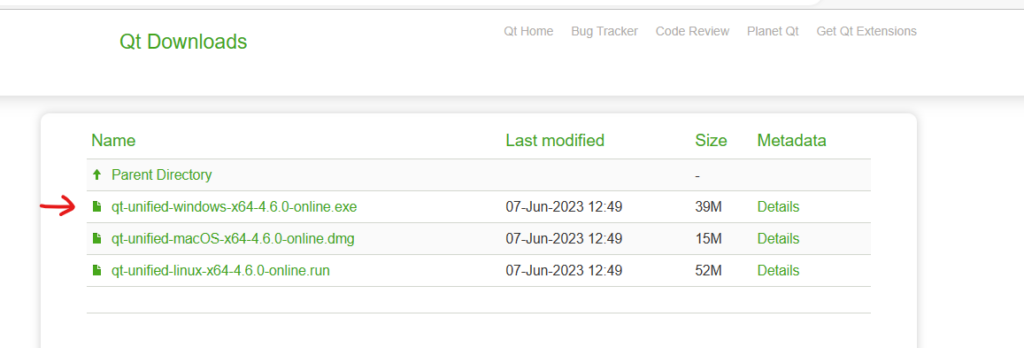

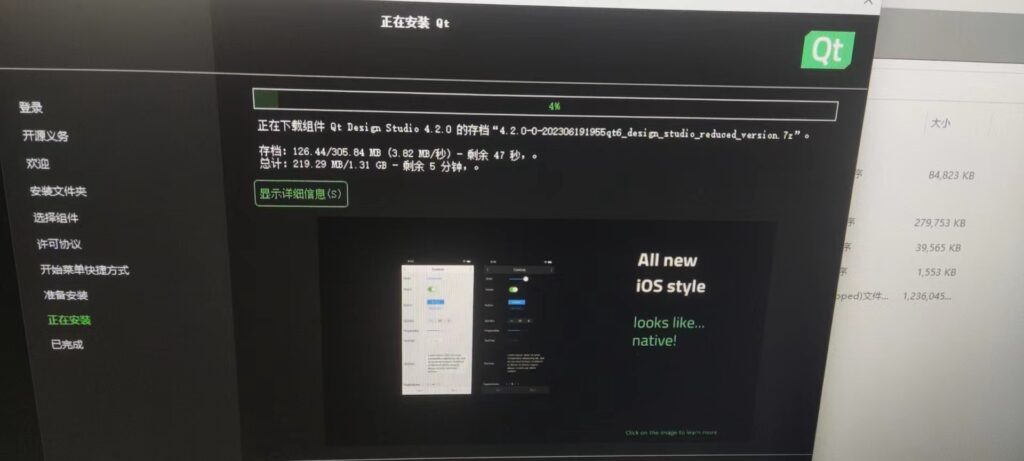

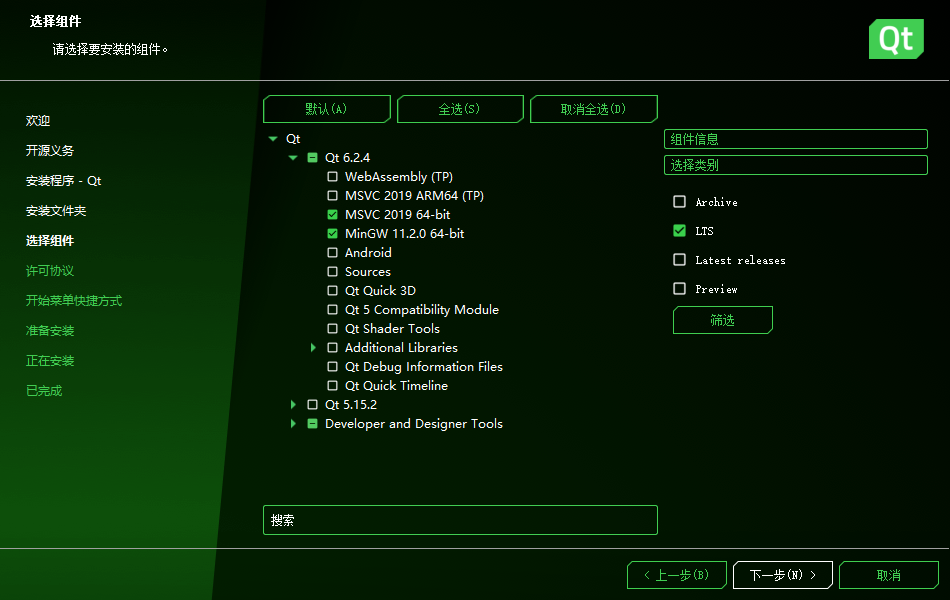

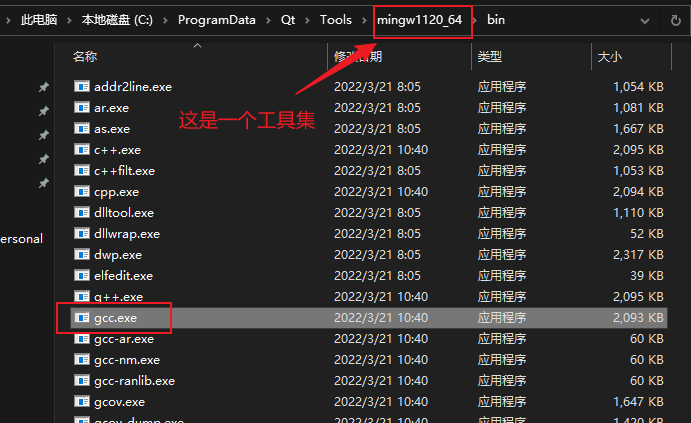

qt在线安装

可以在这个地址下找到安装包的下载地址:

https://download.qt.io/archive/online_installers/4.6/

一步一步安装即可

选择组件时可以加上勾选 qt 中的msvc编译器(还需要额外安装visual studio)或MinGW编译器

到下载这一步比较慢,可能显示需要好几天或几十个小时。

一个解决办法是使用镜像下载,最简单的使用方法为:

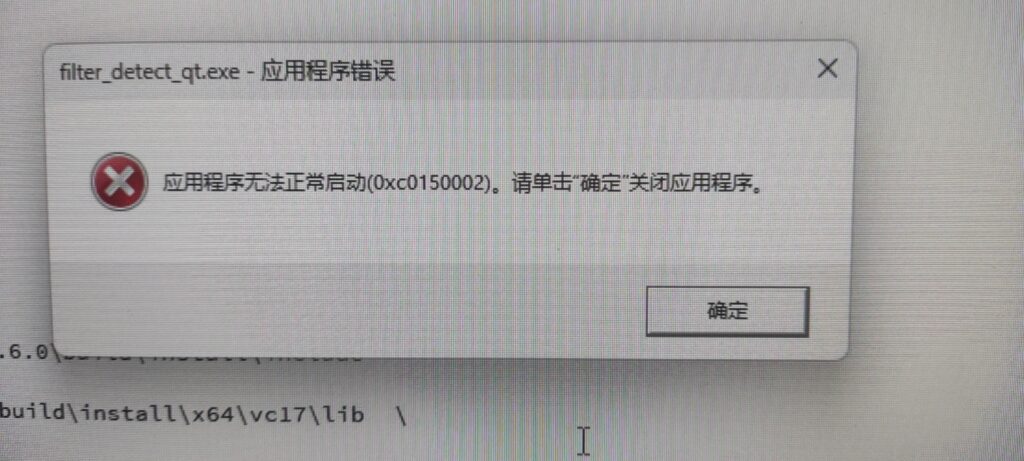

# 在上述下载好的安装包目录下执行 qt-unified-windows-x64-4.6.0-online.exe --mirror https://mirrors.ustc.edu.cn/qtproject程序无法正常启动(0xc0150002)

解决方法:

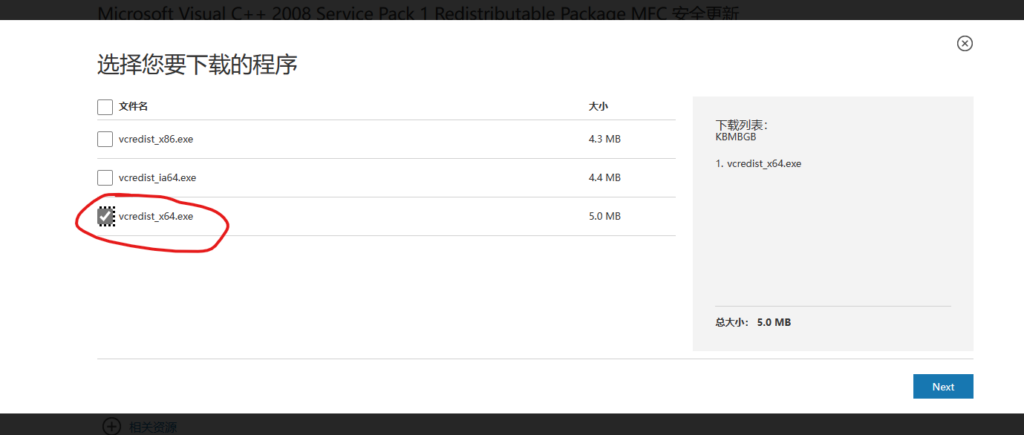

到这个地址:https://www.microsoft.com/zh-CN/download/details.aspx?id=26368

下载这个

然后双击安装即可

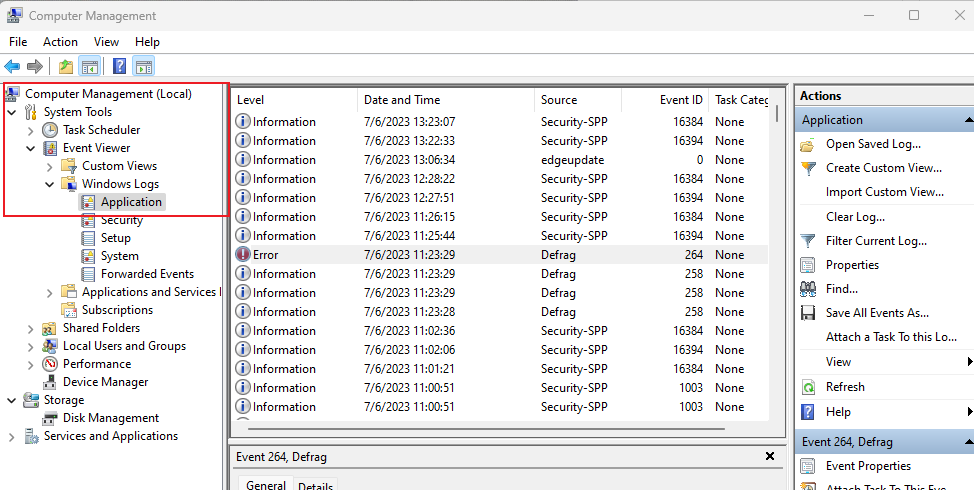

查看出错原因

打开计算机管理,依次打开 系统管理 - 事件查看器 - Windows 日志 - 应用程序,稍等一会就可以在右边的窗口看到级别为“错误”的日志了,如果没有或不确定是哪个,则可以重新运行程序,出错后刷新日志页面第一个就是。双击改日志条目即可看到出错原因。

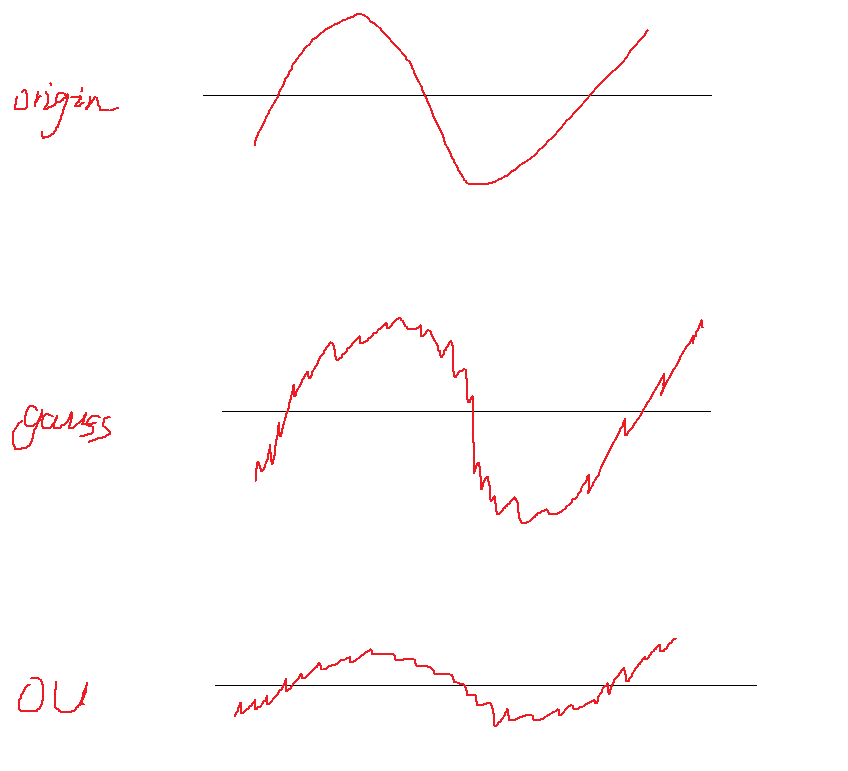

Ornstein Uhlenbeck 噪声

直观理解

在DDPG(一种强化学习方法)采集数据过程中,会在actor输出的action上加上随机噪声以获得更好的探索性。

action是一个连续值,下图中的origin表示一个输出序列(一段时间内模型输出的action值)

最简单的加噪声方式就是直接在输出上加随机噪声,例如高斯噪声(第二行图像)

假如此时actor控制的是一个一辆汽车的方向盘,方向盘转动的角度是有限的,所以此时如果采用随机噪声的方式,则会有很多action被clip到最值,也就是浪费了很多探索的机会。

OU噪声的基本思路就是,先将原始值往其历史均值靠拢一点,然后再加噪声,这样一来,噪声被clip的几率就大大减小,同时,还能通过超参数控制将原始值向均值靠拢多少(上图第三行的图)

数学理解

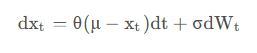

OU噪声公式为:

事实上理解起来相当简单,将其换一种形式写出来就是:

\[ X_{new} - X_{old} = -\theta (X_{old} - \overline X) + βW\ ]

它分为两部分:\( \\theta (X\_{old} - \\overline X) \\) 表示当前输出X与历史均值的差值,前面加个负号表示如果大于均值就往回拉一点,反之亦然。\( βW \ ) 则表示一个随机噪声(例如高斯噪声)

这里的两个超参数 θ 和 β 分别用来控制 1)往均值方向拉多少。2)添加多大的噪声

Actor-Critic优缺点

译自:https://www.linkedin.com/advice/0/what-advantages-disadvantages-using-actor-critic

优点:

1. 通过将critic net输出的q value作为baseline,可以降低policy gradient算法带来的误差,使得使用较少数据就能够使模型收敛

解释:PG算法性能好坏很大部分取决于采样的数据,假如某游戏绝大部分都是正reward,则PG会无脑增大它采样到的action概率,即使有些action并非好的决策。一个解决办法是使得reward有正有负,且概率为0.5。即将采样得到的reward减去reward的期望,在qlearning中,这个期望就是critic net的输出。

2. 原始的PG必须等到一局游戏结束才能训练,而引入critic net之后,它就可以实时训练而无需等到游戏结束。

解释:原始PG需要计算整局游戏的得分才能训练,所以必须得等到游戏结束,而引入critic net后,因为它的作用就是预测该局游戏可能的得分,所以就不需要等游戏结束了

3. 对于不同的应用场景,可以使用不同的critic net来训练同一个policy。例如使用 状态价值函数 或 动作价值函数作为critic net等

缺点:

1. 可以想象,如果critic net没有收敛,那用它训练出的policy肯定是有问题的,这大大增加了模型的训练成本和风险

2. 使用两个网络使得算法实现更为复杂

policy gradient处理连续动作空间

policy gradient可以直接输出action的概率来进行离散动作的选择,而对于连续动作空间,则需要直接输出动作的值,需要想办法将其转换为概率,方法就是输出一个action的分布(例如输出正态分布,就让模型输出 均值 和 方差 两个值即可),然后从该分布中采样一个action,进而计算该action在该分布中的概率,使用模型提高这个概率即可。

以下为连续动作空间的代码示例:

mean, std = actor(states) action_distribution = torch.distributions.normal.Normal(mean, std) action = action_distribution.sample() # 采样action prob = action_distribution.log_prob(action) # 获取该action在输出分布中的概率,后面就是和离散型的一样了 _, reward, _, _, _env.step(action) loss = reward * prob loss.backward() ...作为对比,以下为离散动作空间的代码:

action_probs = actor(states) action = torch.distributions.Categorical(action_probs).sample() # 采样action _, reward, _, _, _env.step(action) loss = reward * torch.log(action_probs) loss.backward() ...SAC、TD3、DDPG

本文不讲理论上的东西,只说实现上的不同。

事实上,如果单从实现来看,SAC和DDPG的差别不大。从 stable-baselines3 看,区别仅仅在于,SAC在训练critic和actor时,多在reward上加了一个熵值,而这也正是SAC的特性来源。

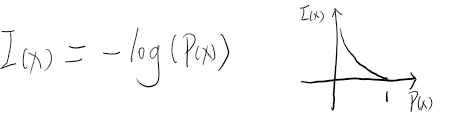

关于什么是熵,可以参见 https://blog.woyou.cool/posts/100/。简单来说,它就是一个值,与事件发生的概率呈负相关关系。因为在reward上加了这个值,也就是说,action发生的概率越小,这个值越大,额外奖励就越多,也就能达到鼓励模型进行探索。当然不仅仅是鼓励探索,本质上还有很多其他的作用,但这里简单先这样认为就够了。

SAC的训练仍然是同DDPG,在每轮训练中,先优化critic的参数,然后基于优化后的critic来优化actor的参数,区别仅仅是reward多了一项。

TD3是DDPG的改进,就像qlearning中引入dqn一样,使用两个critic网络,但是这两个网络独立更新,每次选择q值的时候就从两个网络中选择较小的那个,防止q值被高估。再者,TD3不会像DDPG那样每次迭代都同时更新critic和actor网络,而是critic每次都更新,但隔一段时间才更新actor。另一点就是引入了噪声增加鲁棒性

一些参考:

openAI关于强化学习的教程:https://spinningup.openai.com

openAI给出的各种强化学习基本实现,第三方优化版本 Stable Baselines3:https://github.com/DLR-RM/stable-baselines3/tree/master

Soft Actor-Critic Demystified,这篇文章给出了早期SAC的迭代公式并配有相应pytorch实现,早期的SAC有 Value network、Q network、Policy network 三个网络需要更新,而现在基本只更新 value 和 policy 两个网络:https://towardsdatascience.com/soft-actor-critic-demystified-b8427df61665,这个是他的代码:https://github.com/vaishak2future/sac/blob/master/sac.ipynb

深度解读Soft Actor-Critic 算法:https://zhuanlan.zhihu.com/p/70360272

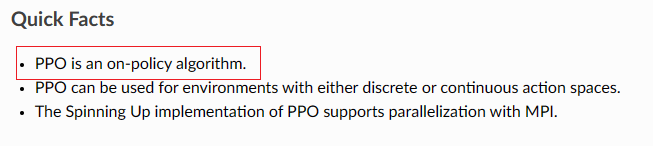

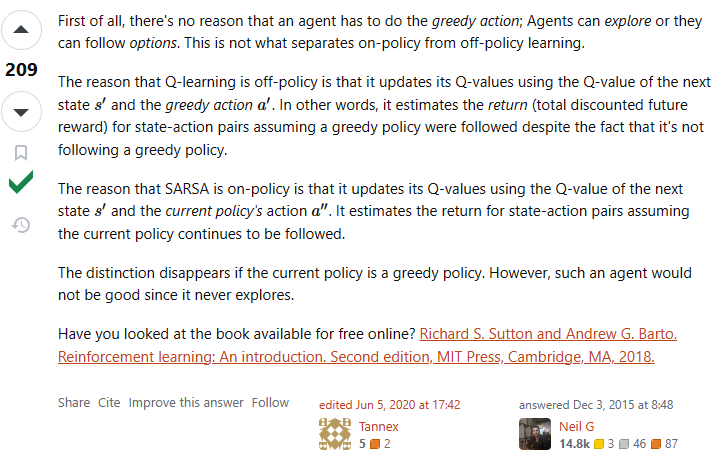

PPO:on policy OR off policy?

之前看李宏毅关于强化学习视频的时候,他说PPO是 off policy 的方法,但是刚看openai spinningup的时候,里面又明确写明它是一种on policy的方法。

如何区分

我个人觉得,一个非常简单的区分方法为:如果与环境交互的策略与目标策略相关,则是on policy的,否则是off policy的。

注意:我这里说的是“相关”,而严格定义来说应该是“相同”,为什么要这么区分,这就和本文题目有关了。

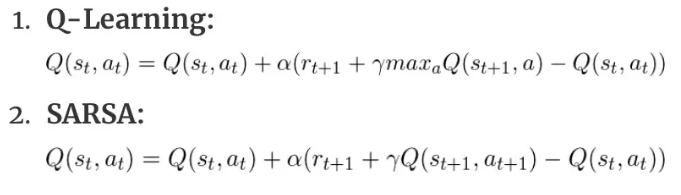

举两个典型的例子进行说明:

Q-learning:典型的off-policy策略。Qlearning在数据收集(与环境交互)过程中,可以采用任意策略,收集到的数据可以长久保存下来用于qtable或qnet的训练。这是因为训练得到的qtable或qnet本身就与模型无关,你可以使用它训练任意actor网络

SARSA:典型的on-policy策略。它和Qlearning唯一的区别在于,qlearning是直接找到\( S\_{t+1}\\)中最大的reward,而SARSA找到当前策略在\(S_{t+1}\ )时的能够获得的reward。显然,一个和目标策略无关,一个有关。

两者Q值的更新公式:

注:2式中,\( a\_{t+1} \\)表示的是当前策略在\( S_{t+1} \ )环境下所选择的action

还看到另一种解释,我觉得更精简得说明了这个问题,但思想差不多:

PPO?

从上面说的角度来看,PPO确实应该归属于on policy策略。因为它收集数据所使用的policy与目标策略是相关的,这里的相关体现在收集数据所使用策略的参数必须每过一段时间与目标策略参数进行同步,它们不能相差太大。

但是如果从严格定义上来讲,虽然两个策略必须保持相似,但本质上还是两个策略,从这方面来说,它确实也是off policy的

gymnasium pygame windows 无响应

使用gymnasium的第三方游戏环境Flappybird(https://github.com/markub3327/flappy-bird-gymnasium)训练RL模型,游戏刚运行没多久窗口就会无响应

只是窗口渲染出问题,游戏逻辑实际仍然在运行

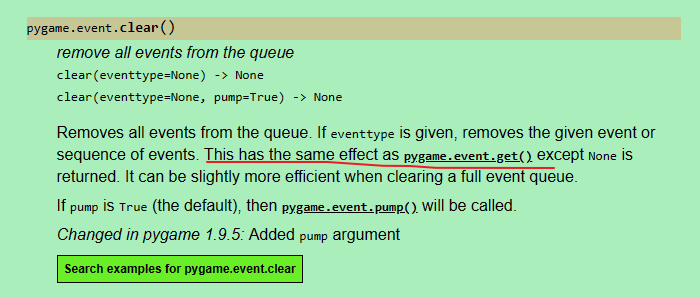

出现这个原因是因为 event queue 一直没取,满了,新的event进不去就会卡住,在游戏中加入以下代码即可:

env = gymnasium.make("FlappyBird-v0") while True: # game loop env.render() ... pygame.event.clear() # 加这个代码清空event queue,或者 pygame.event.get() ...参见:https://www.pygame.org/docs/ref/event.html#pygame.event.clear

两个数组保持顺序合并能产生多少种排列组合

做这道题用到的:https://leetcode.com/problems/number-of-ways-to-reorder-array-to-get-same-bst/description/

求两个数组归并后可能产生多少种组合,要求归并后两个数组元素仍有保持原数组中的顺序

其实是个很简单的问题,是我开始想复杂了

假设两个数组长度分别为m和n,则归并后长度为m+n,则问题可以转换为从m+n个索引里面挑选出m个(或n个)索引有多少种方式

其实就是 ( C_{m+n}^m = C_{m+n}^n = \frac {(m+n)!}{m!×n!} \ )

组合(Combination)公式为

\[ C_n^k = \frac {n!}{k!×(n-k)!} \ ]

在python中可以用

math.comb(n, k)进行计算排列(Arrangement,从n个元素中选出k个元素并排序)公式为

\[ A_n^k = \frac {k!}{(n-k)!} \ ]

python中使用

math.perm(n, k)进行计算Adam优化器

优化器的进化

训练一个policy gradient模型时,发现如果使用SGD,模型练不起来,很容易就出问题,而使用Adam则会好很多,这里回顾一下Adam的原理:

梯度下降法的梯度迭代公式为:

\[ θ_t ← θ_{t-1} - μg_t \ ]

其中 ( g_t \ ) 为t时刻函数对θ的偏导,μ为学习率。

如此一来,在模型训练时就需要指定μ这个超参数,且模型中所有的参数将以一个恒定不变且相等的学习率进行更新。这样其实有两个缺点:

模型在训练初期梯度一般较大,而在末期一般较小,那么学习率设置得过小就会收敛很慢,而设置过大则可能在局部最优点左右横跳

不同的特征对模型的重要性不同,例如对于稀疏特征矩阵来说,那些趋近于0的位置表示与特征相关性较低,那么它们的梯度一般来说也较低,假如使用同样的学习率来更新这个参数的话,可能更新得很慢,比较浪费计算资源。

为了解决上述问题一,可以使用程序自动设置学习率,为了解决问题二,可以给每个参数单独设置一个学习率。两者结合可以得到新的迭代公式:

\[ θ_t ← θ_{t-1} - \frac {μ}{η(g_w)}g_t \ ]

发现学习率下多除了一个 ( η(g_w) \ ),它是学习参数w的函数,如此一来,每个参数都有单独的学习率了(仍然需要指定一个基础学习率μ,但它不用那么小心的选值了)

进一步地,Adagrad算法使用参数w的历史梯度来确定这个( η(g_w) \ ):

\[ θ_t ← θ_{t-1} - \frac {μ}{\sqrt {\sum_{k=0}^t {G_w}_k+ε}}g_t \ ]

其中,( \sum_{k=0}^t {G_w}_k \ ) 是t时刻之前,w参数的所有梯度平方和,_ε_是一个很小的数防止除0

如此一来,如果一个参数w的历史梯度越大,它的学习率就越小(这是符合直觉的,历史梯度越大,则说明这个参数代表的特征越重要,对于这种重要的特征,更新起来应该慎重,步步为营。而那些历史梯度小的参数,则应该避免无用地更新,最好能用大的学习率直接一步到位)

但这还是会出现之前所说的问题,一个参数的梯度是在动态变化的,可能开始很大,后面就很小了,那么如果一股脑使用所有的历史梯度来评估下一次的学习率,还是有些不太合适,如果仅用当前时刻t的前k步的历史梯度可能会好一点,但这样又缺乏对过往梯度的全面考量,如此一来 RMSProp 出现了,它引入了一个折扣因子的概念,让之前的历史梯度都乘以一个折扣因子α的 n 次方,这里的n就是历史梯度与当前时刻的时间跨度:

\[ θ_t ← θ_{t-1} - \frac {μ}{\sqrt {\sum_{k=0}^t α^{t-k}{G_w}_k+ε}}g_t \ ]

正梯度仍然使得policy的probability增大

现象

使用policy gradient算法写了一个小模型,训练过程中发现模型很快会收敛到一个非常糟糕的结果,理论上不应该呀,因为按照policy gradient算法原理来说,对于某个action,如果你给了负的reward,那么模型会减小该action出现的概率,但我的实验表明,模型不仅没减小该action的概率,甚至还会增加它的概率,最终它的概率甚至会等于1。理论上,即使这个不好的action概率为1了,但是reward是负的,每次迭代应该还是会降低其概率,但我这个实验发现并没有,反而会继续降低另外一个好的action的概率——即使它已经无限逼近0了。

排查

首先我想,既然坏的action概率在增加,有没有可能是因为reward是正数(本来应该给负数),但是经过简单的排查后发现,该action的reward就是负数。

然后考虑到,policy gradient 对采样的样本action会无脑增大其发生概率(前提是该action的reward是正的),然而采样所使用的概率也是这个概率,那么就可能形成一个恶行循环:梯度上升导致概率增大->概率增大导致其更容易被采样->采样后概率继续增大…。但经过计算发现,即使它的概率会恶性增大,但如果采样的足够多,总是会采样到其他reward更大的action上,那么它的概率还是会减小很多。另一点就是经过排查,发现这个action的reward确实是负的,应该不会出现这个情况。

第三个想法是,因为这是一个神经网络,本质上就是一个函数,假如这个函数有图像的话,现将其简化想象成一个二维的曲线,那么上面的问题就类比于:如果我采样到上面某个点,经过计算发现下一次迭代后,这个点的位置应该下降(本质上是函数发生了变化,原本的函数更新为另一个新的函数),但是实验却发现下一次迭代后它还上升了。一个很直接的想法就是,有没有可能,如果单独更新这一个点时,它确实会下降,但实际上,我同时更新了多个点,在更新其他点时,更新的参数影响了这个点的值,那么它就有可能不降反升。理论上,这也确实是非常有可能的,但它发生的概率应该要远小于50%,否则模型只会越训练越差。但上述实验发现,好像这个值又接近50%,这就让人匪夷所思了。而且,理论上,就算出现这种问题,在迭代次数足够多后,这种情况应该越来越少。所以这个假设也被排除。

实验到此已经很晚了,我仍然没想通什么原因。于是我想会不会就算训练的时间不够导致的,于是我同时运行好几个相同的模型,其中只有部分有修改,例如有些使用 discount reward,有些使用 total reward,有些则更换优化器等,跑一个晚上看看结果。

如何使用梯度判断模型中间量的更新方向?

在pytorch中,只有叶子节点的变量(学习量)才可以直接获取梯度,但在上述问题中,我发现模型输出的某个概率增大了,我怀疑这里的梯度有问题,那么我想查看这个输出概率的梯度怎么办?很明显直接看是看不了的,因为它只是一个中间量,虽然会计算它的梯度,但并不会在backward后保存下来,因为并不需要真正更新它。

pytorch提供了

register_hook()函数来获取或修改这些中间量的梯度:output = model(input) ... # 如果同一个变量注册了多个 hook,则会顺序执行它们。 output.register_hook(lambda grad: print(grad)) # 读取梯度 output.register_hook(lambda grad: grad * 2) # 也可以直接修改梯度 ... loss = loss_model(output) loss.backward() # hook中的函数会在这里计算完梯度后执行 ...通过这种方法,你就可以知道下一次迭代时是会增加这个输出还是会减少这个输出了。由于迭代后的值等于原值减去梯度,如果梯度是正数,则会减小,反之会增加。下面是一个register_hook()使用方法的例子:

a = torch.tensor(2., requires_grad=True) b = 5 * a c = b * b b.register_hook(lambda g: print(f'b grad: {g}')) # b grad: 20.0,因为用c对b求偏导为 2b, 而b又等于 5*2,所以b的梯度为 2 * 5 * 2 c.backward()一个具体的例子:

Policy gradient中为什么必须给概率取log?

注意:这篇文章没有解释原因,只是探索了一个相似方法

一般认为是可以用来简化计算的,log可以将原本的累乘转换为累加,例如 a*b*c 总体加上一个log就可以转换为 loga+logb+logc,当然,能总体加log是因为log保留的原来函数的单调方向,转成加法还有个好处就是一定程度上可以防止梯度消失或爆炸,因为连乘很容易为0或无穷

使用最朴素的policy gradient写了一个玩平衡杆的策略模型,发现如果使用SGD会出现一些问题

# 以下代码是有问题的 ... action_probabilities = model(current_env) ... choose_action_prob = action_probabilities[choose_action] ... loss = -reward * choose_action_prob loss.backward() ...问题出现在直接使用

choose_action_prob用作梯度上升。其实直观上感觉应该就是这样的:一局游戏的得分的期望等于这局的total reward乘以这局游戏中各个过程的出现概率。目标就是最大化这个期望,如果使用现有的梯度下降框架,则直接在前面乘以一个负号即可。感觉应该就是这样的,实验结果表明这样模型很有可能不会收敛,模型不会选择最优策略。

我猜测问题可能出现在负号上,理论上这个loss可以无限小,也就是它可能是无解的,但可以通过修改代码使得模型可以趋近于一个值(注:问题原因并不一定是这个,我猜的,但这个解决方法确实可以解决这个问题)

解决方法是让

choose_action_prob = -1/choose_action_prob,因为我们的目的是使得上面的loss更小,也就是使得这里的choose_action_prob更大,前面加上一个负号就可以让它和loss前面的负号抵消,然后让它做除数,即不影响它原本的单调性。我实验了一下,这种方法确实可行,但更常用的方法是取log

# 方法一 choose_action_prob = 1/choose_action_prob loss = reward * choose_action_prob # 方法二,注意后面加一个很小的数防止为0 choose_action_prob = torch.log(choose_action_prob + 1e-8) loss = -reward * choose_action_prob这样一来,loss应该是越趋近于0越好。不过实验结果表明,方法二的效果远远好于方法一,甚至于 -1/x+1 也比上面的1/x要好得多,why?

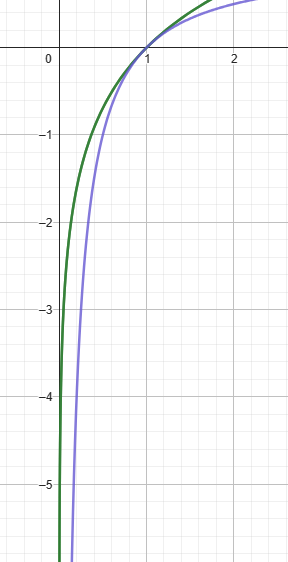

这是 log_e(x) 和 -1/x+1 的曲线

以下为完整代码:

import itertools import threading import gymnasium import numpy as np import torch from loguru import logger from torch.utils.tensorboard import SummaryWriter board = SummaryWriter('./logs/division_factor_random') torch.random.manual_seed(1) np.random.seed(0) def visualize_train(policy: torch.nn.Module): with torch.no_grad(): test_env = gymnasium.make("CartPole-v1", render_mode='human') for i in itertools.count(): total_reward = 0 obs, _ = test_env.reset(seed=0) while True: action = torch.argmax(policy(torch.FloatTensor(obs))) obs, reward, terminated, _, info = test_env.step(action.item()) total_reward += reward if terminated: board.add_scalar("test/reward", total_reward, i) logger.info(f"total reward: {total_reward}") break test_env.close() class Actor(torch.nn.Module): def __init__(self): super().__init__() self.dnn = torch.nn.Sequential( torch.nn.Linear(in_features=4, out_features=20), torch.nn.ReLU(), torch.nn.Linear(in_features=20, out_features=2), torch.nn.Softmax(dim=0) ) def forward(self, x): return self.dnn(x) actor = Actor() threading.Thread(target=visualize_train, args=(actor,)).start() optimizer = torch.optim.Adam(params=actor.parameters()) env = gymnasium.make("CartPole-v1", render_mode=None) for game_count in itertools.count(): obs, _ = env.reset(seed=0) acts = [] rewards = [] for s in itertools.count(): action_probs = actor(torch.tensor(obs, dtype=torch.float)) action = torch.distributions.Categorical(action_probs).sample().item() # if np.random.random() < 0.1: action = np.random.randint(0, 2) obs, reward, terminated, _, info = env.step(action) acts.append(1 / action_probs[action]) rewards.append(reward) if terminated: # loss with discount factor=0.99 loss = sum([a * weighted_r for a, weighted_r in zip(acts, [sum([r * 0.99 ** j for j, r in enumerate(rewards[i:])]) for i in range(len(rewards))])]) # loss = (sum(rewards) * sum(acts)) optimizer.zero_grad() loss.backward() optimizer.step() break env.close()gym实时渲染模型训练效果

深度强化学习模型在训练玩游戏时,不渲染游戏画面可以大大加快训练速度

# 将 render_mode 设置为 None 就不会渲染游戏,设置为 "human" 就会以图像帧的形式渲染 # 注:老版本需要调用 render 方法才会渲染,新版本会在调用 reset 方法时就自动渲染 env = gymnasium.make("CartPole-v1", render_mode='None')如果我想在训练过程中实时查看模型的训练效果,则可以使用多线程实现:

一个线程负责训练模型,另一个线程中重新创建一个一样的游戏环境,负责渲染,它们都从主线程获取最新的模型(训练线程就可以作为主线程)

import threading def render(model): render_env = gymnasium.make("CartPole-v1", render_mode='human') with torch.no_grad(): while True: obs, _ = render_env.reset() while True: act = convert_model_output_to_act(model(torch.FloatTensor(obs))) _, _, terminated, _, _ = render_env.step(act) if terminated: break m = MyPolicy() # 创建一个渲染线程,并将正在训练的模型作为参数传递进去,daemon=True 表示将其作为守护线程,主线程退出后它也跟着退出 threading.Thread(target=render, args=(m,), daemon=True).start() # 主线程就可以作为训练线程,下面部分就是模型训练相关的代码 train_env = gymnasium.make("CartPole-v1", render_mode='None') ...或者使用子进程也可以,使用方法基本一致,但是要注意,1)这里的 main 方法是必须的,2)进程中传递的args参数并不是引用传递,而是值传递,意味着在主进程中修改了actor的参数后,子进程仍然使用的是原来的actor:

import multiprocessing ... if __name__ == "__main__": multiprocessing.Process(target=visualize_train, args=(actor,), daemon=True).start()Policy gradient 与 e-greedy

在训练qlearning网络时,通常会设置一定的概率去做一些探索,以求能做出更好的决策。而在Policy gradient中,也是需要探索的,但是它会有一些问题

我写了一个MLP来作为policy,在训练过程中,每次做决策都使用 argmax 来寻找当前模型认为最好的action,模型不会收敛,想想它当然是不会收敛的,因为policy gradient训练模型本质上就是在提高采样样本中被采取的action的概率,即使这个action是一个不好的action,模型也会提升它,而之所以policy gradient能够训练出有效的模型,是因为提升每个action的程度不同,得到的reward多,提升得就高,反之提升得就低,如此一对比,提升得低的就相对是在降低了

而如果我在训练中每次都使用argmax获取action,也就是每次采样都是采样的模型输出概率更高的那个action。假设一开始各个action的概率是一样的,经过第一次采样,得到了一个样本(S,a),表示在状态S下采取了a的动作,那么,如果该游戏没有负reward的情况下,即使我采取a这个动作带来了不好的结果,那么reward也是正的,那么在梯度上升的加持下,模型就会提升在S这个状态下,a这个动作的概率,因为原本各action概率相同,如此一来a的概率就会比其他的都高,那么后续每次采样都只会采样到a了,a的概率也会逐渐增加知道趋近于1。

一个直观的想法是引入qlearning中的e-greedy方法,设置一个随机变量,在某次训练过程中如果该变量大于某阈值,则随机选择一个action,而不是使用argmax选择模型认为最好的action。这种想法看似可行,因为这样就避免了只会采样一个action的情况,但实际上这样还是有问题的,它对reward和随机变量的阈值都是有要求的

在一个trajectory中,会出现很多(S,a)对,表示在环境S下,policy选择了a这个action。不管a这个action是好的还是不好的,在最原始的policy下,它都会将这整个trajectory的total reward作为梯度增量的因子,所以,这种情况下,采样的a越多,其被再次采样的概率就越大,即使它不是一个好的action。

假设在S状态下有 A1,A2 两种action可以选择,选择A1可以得到reward=R1,选择A2得到 R2,经过设计有r1的概率选择A1,r2的概率选择A2。模型训练过程中,在做梯度更新时会将reward作为梯度增量的乘数因子,所以可以简单地认为reward就是训练一次后,各个action概率变化的增量。当概率的增量无法弥补选择的概率带来的差值时,模型的策略就不会发生变化(这里本来是要做一些数学计算的,但算着算着发现比我想象的要复杂得多),例如,R1=8,R2=9,r1=0.9,r2=0.1,假设 r 的更新公式为 r = (r + 0.01*R)/sum(r),则训练一次后,r1=0.84,r2=0.16,可见,正确的策略应该时选择A2,但此时r1仍然大于r2,要使r2>r1则需要很多轮的迭代,但要注意,这里讨论的仅仅是一个特定状态S下的情况,而真实情况下,采样的S每次可能都不一样,再加上reward本身可能是个随机变量,那么又要要求采样很多个S模型才能选择正确的策略,这个概率似乎还是有点低。还有一点更为重要,这里其实说的是不同的reward下的情况,它最终应该能收敛,但是在同一个trajectory,不使用折扣因子的情况下,其实它们的reward是一样的,这却情况下,谁被采样得多,谁就更有可能再被采样。经过实验证实,如果引入折扣因子,这个问题也会被解决

当奖励没有区分度的时候,被采样的次数越多,被采样的概率也就越变越大,这是一个恶性循环

由此可知,在使用policy gradient方法时,应尽量使得采样样本更丰富,例如训练过程中选择action时,不直接使用argmax选择,而是将模型的输出作为action的选择概率分布,然后随机选择:

# pytorch提供的方法 action = action_space[torch.distributions.Categorical(action_probs).sample().item()] # 甚至于在某些简单的情况下,你可以完全采用随机的action,但是使用argmax是不会收敛的 action = torch.randint(0, 2)当然,上面讨论的都是在reward都为正的情况下,如果有正有负则有可能不会出现这种情况,所以另一个解决方法是给reward减去一个baseline,详见 深度强化学习简介

深度强化学习简介

这是一篇深度强化学习视频的笔记 https://www.bilibili.com/video/BV1XP4y1d7Bk

什么是强化学习

强化学习方法分为三类:Policy-based(训练一个actor,例如 policy gradient)、Value-based(训练一个critic,例如 Q-learning)、Actor-Critic

所谓的actor就是一个agent,即决策者,它能根据一个输入状态,输出一个行为。例如输入一帧游戏画面,它输出前进还是后退等,然后系统根据游戏结果给出相应奖励

所谓critic就是一个预言家。它用来预测某个人执行某种行为的预期结果

某人(actor)问预言家:我现在破产了(当前状态),如果我去抢银行或者去打工(可以采取的动作),我会得到什么后果?预言家说:如果你去抢银行,你会被抓住,后半生就在监狱度过,如果去打工,由于你的人品不错,你会遇到一个贵人,他会让你飞黄腾达(对这个人采取某个行为的预言)。

事实上,上面问预言家(critic)的过程就是Actor-Critic,actor不会真的去抢银行或者打工,他只是提出这个做法,让critic去评价,然后他得到这些评价内容后来审视自己,比如说他知道打工会遇到贵人是因为自己人品好,他就会让自己人品更好,而预言家看到了这个人的改变后又会给出新的预言,两者不断更新

关系梳理

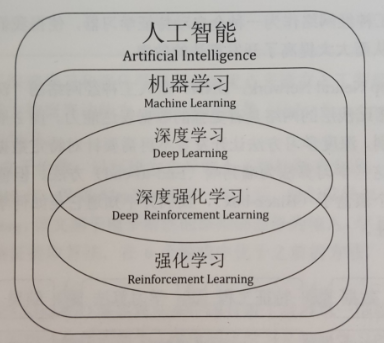

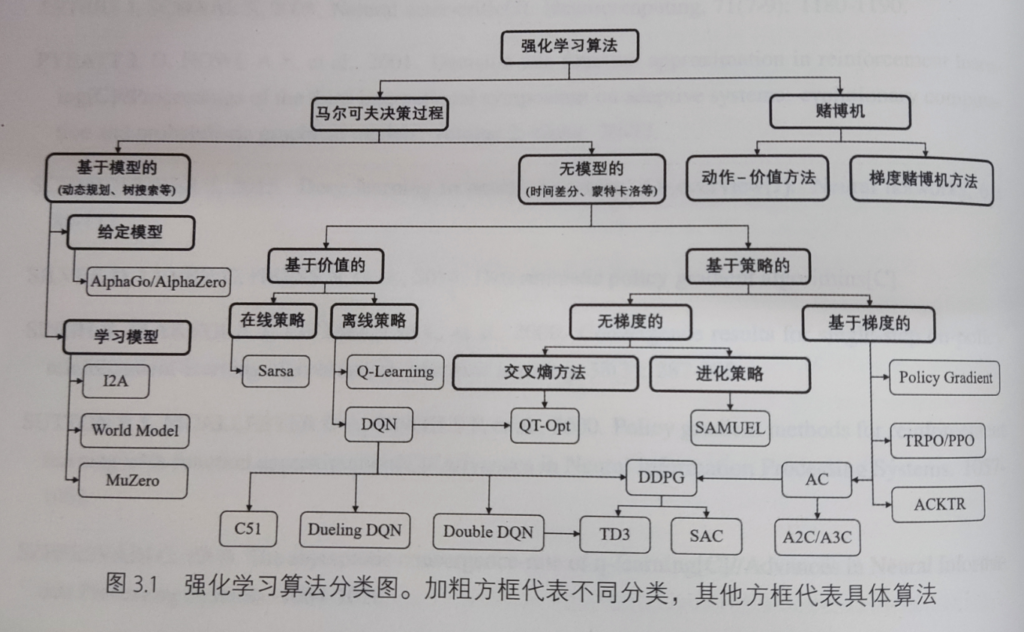

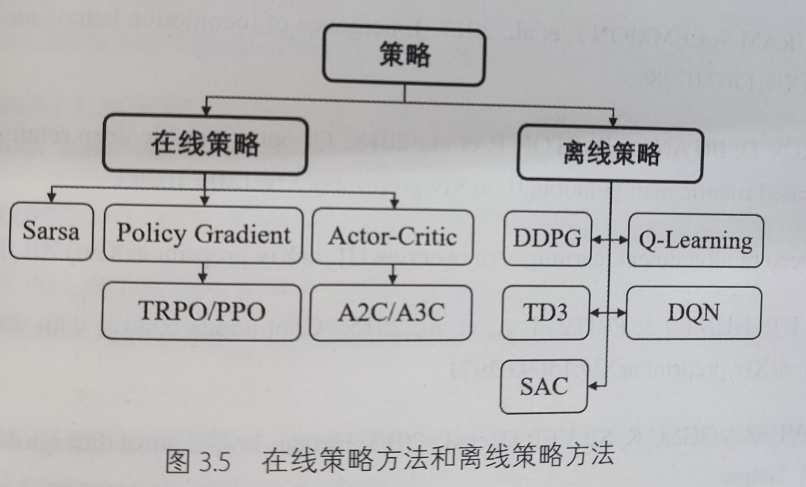

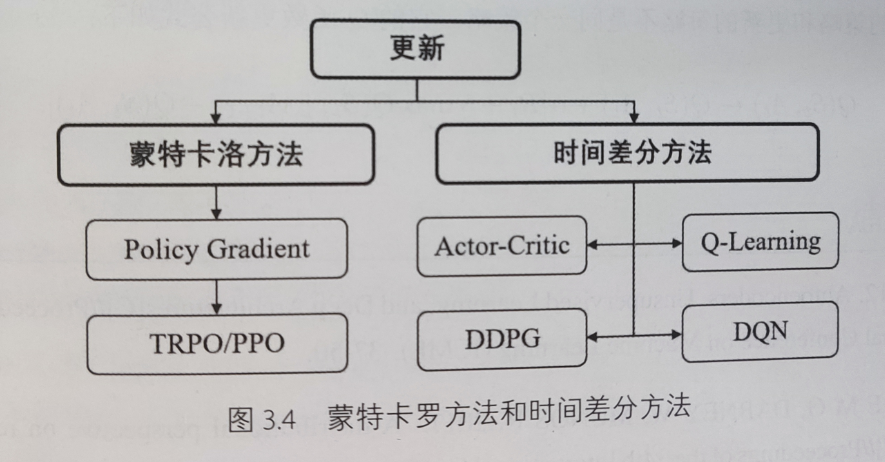

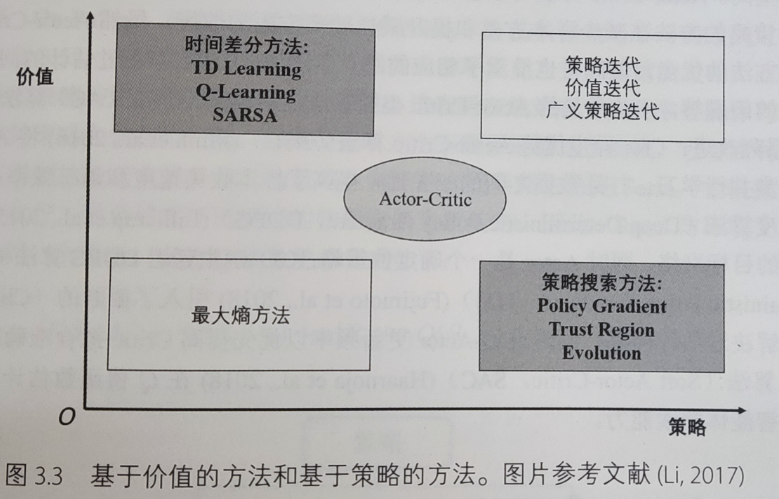

下面的图来源于《深度强化学习》一书,我觉得这些图对学习强化学习的路径规划有很强的指导意义

强化学习在人工智能领域的位置

强化学习算法分类:

在线策略和离线策略分类

蒙特卡罗法(MC)和时序差分法(TD)分类

value-based 和 policy-based 方法分类

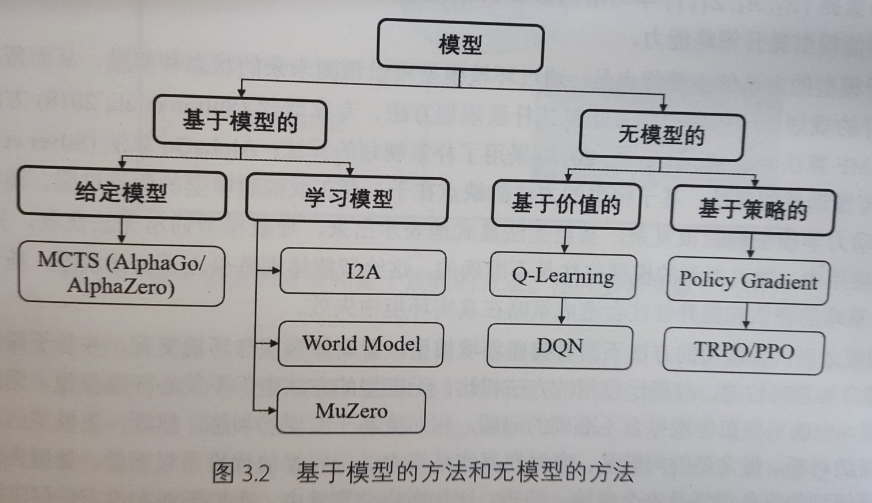

基于模型的方法和无模型的方法分类(不是深度学习模型,是数学模型)

policy gradient

每一局游戏都是由 状态-动作-奖励-状态-动作-奖励。。。不断循环进行的

\[ trajectory τ = {S_1, a_1, r_1, S_2, a_2, r_2…, S_T, a_T, r_T} \ ]

所以一个trajectory发生的可能性为:

\[ p_θ(τ) = p(S_1)p_θ(a_1|S_1) p(S_2|S1, a_1)p_θ(a_2|S_2)p(S_3|S_2, a_2)… = p(S_1)\prod_{t=1}^Tp_θ(a_t|S_t)p(S_{t+1}|S_t, a_t) \ ]

对于任意一个trajectory来说,它的total reward为:

\[ R(τ) = \sum_{t=1}^Tr_t \ ]

那么对所有trajectory来说,它的reward期望就是每个trajectory发生的概率乘以其total reward:

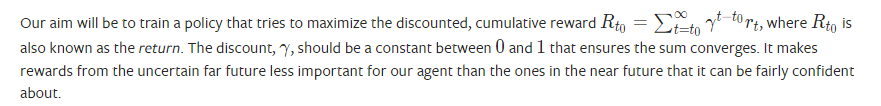

\[ \overline{R}_θ = \sum_τp_θ(τ)R(τ) =E_{τ\sim p_θ(τ)}

随机到之前不会的题

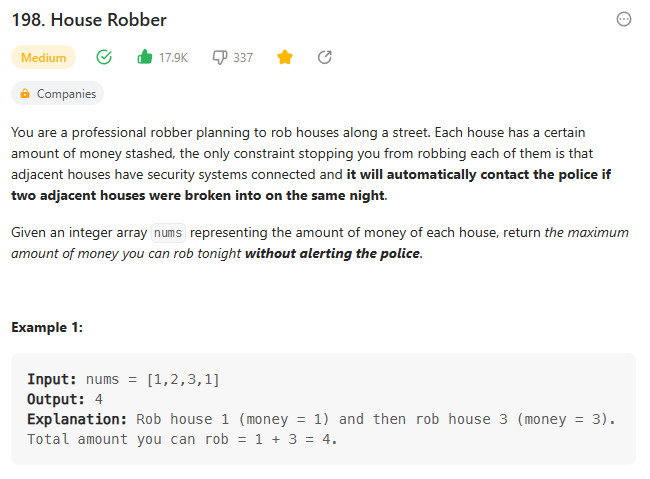

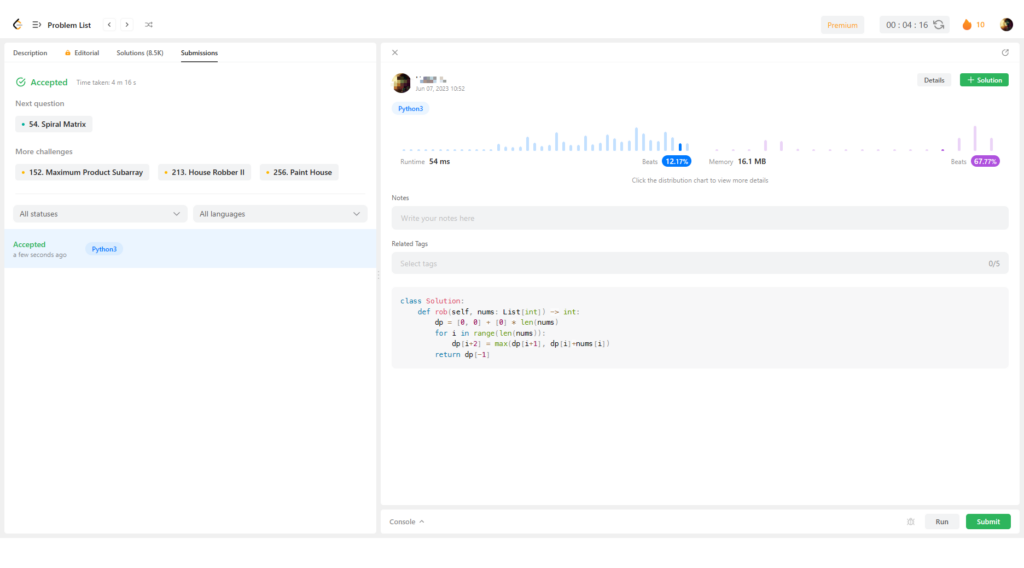

刚才刷leetcode时候随机了一题,发现这道题我竟然点过赞,并且加入了收藏

我想这应该是我很久之前刷过的一题,没有提交记录,当时应该没做出来,并且应该看过了其他人的解决方案还是没做出来的那种,觉得方法很巧妙也很common,所以才点赞加收藏,希望下次能做出来。

我有理由相信我当时应该花了很长时间来做这道题,甚至几个小时,因为那时我做一题基本是按小时计时的,那个时候刷题完全没有章法,也完全不会总结,就是硬刷,那个时候也不懂动态规划,对递归的使用也是似懂非懂。

最近每次刷到那种完全没有头绪的题,我都会怀疑这段时间的训练是否又和之前刷题一样,毫无章法,毫无意义。

这次又随机到了这道题,我可以仅用4分钟,用4行代码就解决了,我想,这段时间的训练确实应该是有效果的。

Shortest Path in Binary Matrix

https://leetcode.com/problems/shortest-path-in-binary-matrix/

以下为我的思考过程:

我首先想到能否使用动态规划解题,因为,假设要求解的坐标为(i,j),那么我只需要知道其邻域八个坐标的解,即对于给定任意grid中的坐标,如果该坐标值为0,则我只需使用

1+min(邻域坐标最短路径)即可求解。但细想一下也不对,因为这八个坐标并不全是求解坐标的子问题,因为如果要满足子问题的规模,则子规模的坐标必须都大于或者小于求解坐标,显然邻域坐标中,有些大于(i,j),有些小于(i,j)。这说明这题应该不适用于动态规划。于是又想,既然是求解路径,dfs应该是可行的,于是写代码:

class Solution: def shortestPathBinaryMatrix(self, grid: List[List[int]]) -> int: if grid[-1][-1] == 1 or grid[0][0]: return -1 def dfs(i, j, path): if (i, j) in path or i < 0 or i > len(grid)-1 or j < 0 or j > len(grid)-1: return -1 if i == len(grid)-1 and j == len(grid)-1: return 1 return -1 if grid[i][j] != 0 else 1 + min(filter(lambda x: x>0, [dfs(i-1, j-1, path+[(i, j)]), dfs(i-1, j, path+[(i, j)]), dfs(i-1, j+1, path+[(i, j)]) , dfs(i, j-1, path+[(i, j)]), dfs(i, j+1, path+[(i, j)]) , dfs(i+1, j-1, path+[(i, j)]), dfs(i+1, j, path+[(i, j)]), dfs(i+1, j+1, path+[(i, j)])]), default=-2) return dfs(0, 0, [])但这个会超时,原因在于,dfs会遍历所有可能的路径,然后找到一条最短路径。有没有直接找最短路径的方法呢?那就是BFS,可以想象,如果让你在一棵树中找到达叶子节点的最短路径,一个可行的方法就是逐层遍历树,遇到的第一个叶子节点就是路径最短的叶子节点,因为其深度最低

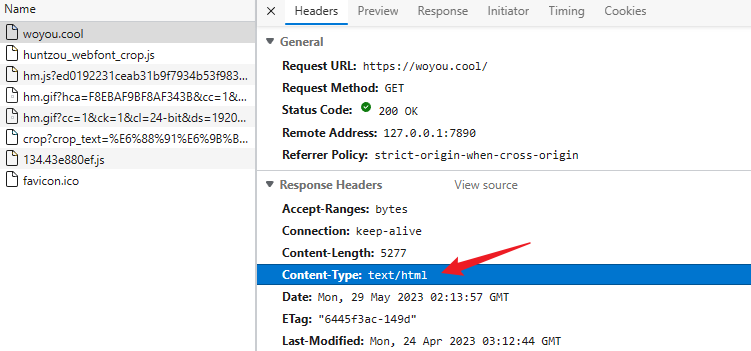

Content-Type: multipart/form-data

什么是 Content-Type 头

在http响应头或请求头中会看到一个名为

Content-Type的头信息,它表示的就是文档的类型信息(Multipurpose Internet Mail Extensions or MIME type 即MIME type)一个url其实就是一个远程文件的地址,通常一个文件可以通过后缀名来区分文件类型,但是浏览器通过url访问文件并不会使用后缀名来判断,而是使用content-type这个头来判断,这也是为什么一个html可以有不同的后缀名,甚至不要后缀都可以,只有content-type这个头设置正确即可

Content-type 头结构

Content-type表示的是文档类型,它是有一个固定的结构的

type/subtype // 或带参数的 type/subtype;parameter=value这里的

type表示的是一个文件的大类别,例如 文本文件(text)、视频文件(video)等

subtype表示文件的子类别,例如,对于文本文件(text),其可能是常规文本(plain)、HTML文件(html)等。例如对于一个静态页来说,其MIME type就是text/html文档类别是可以携带参数的,例如

text/plain;charset=UTF-8type

type分为两种:单类型(discrete)和混合类型(multipart),其中,单类型就是文档就是一个类型的文件,例如html文件、视频文件等,而混合类型则表示多种类型的文件混合类型,典型的例如在表单提交时,会有文本、文件等多种类型混合提交的,或者接收的邮件中既有文本也有文件

discrete

text、image、font、video、model、audio、example、application等

multipart

对于混合类型的http响应,除了 Content-type 为

multipart/form-data或者multipart/byteranges外,其他的类型都会被浏览器当作下载文件处理(Chrome右上角显示一个另存为的提示)混合类型实际上也是要对每个子类型进行说明的,下文中有举例

混合类型的 type 有:

multipart和messageMIME types举例

application/octet-stream:默认的二进制文件类型,浏览器会直接显示“另存为”的提示

text/plain:浏览器会直接显示,值得注意的是,浏览器不会将这种类型的文档解释为特定类型,例如你不能在里面写js或css等,浏览器不会主动解释

text/css、text/html、text/javascript等

image/apng、image/gif、image/jpeg、image/png、image/webp等

video/webm、audio/webm。。。

multipart/form-data

这个头常见于表单提交的请求头中,以前一直没搞懂它是怎么运作的,这里做一个解释

对于这种混合类型的文档,它的content-type实际上也是由各个类型的单类型组合而成的。例如对于以下表单:

<form action="http://localhost:8000/" method="post" enctype="multipart/form-data"> <label>Name: <input name="myTextField" value="Test" /></label> <label><input type="checkbox" name="myCheckBox" /> Check</label> <label> Upload file: <input type="file" name="myFile" value="test.txt" /> </label> <button>Send the file</button> </form>它里面有三个input标签,其中两个是文本类型,一个是文件类型,那么在提交时,实际的请求体为:

异或产生的思考

刚才做一道算法题,觉得它的解很有启发性,题目是:给定一个int数组,数组只有一个数字只出现了一次,其他都是成对出现的,数组是乱序的,请找出这个数字 https://leetcode.com/problems/single-number/description/。

题目很简单,我的做法是先排序,然后再遍历入栈,若栈顶元素与当前元素相同则出栈,最后栈中剩余的那个数即为所求。时间复杂度为 O(nlogn),但是还有个非常精妙的做法是使用异或操作(xor:相同位为0,不同为1):将所有的数都异或,则最终的异或结果即为所求,时间复杂度为 O(n),我惊讶的是这个想法。

我想,这可能是一种非常快速且节约资源的对比算法,例如,假如我有两个无序数组,我想快速对比两个数组的元素是否相同,我并不需要非常准确的结果,我只希望其占用的系统资源尽量低。一个可行的做法是分别对两个数组中的元素做异或操作,然后对比结果,如果相同,则说明这两个数组“有可能相同”,如果不同,则说明这两个数组“一定不同”

之所以说有可能相同,是因为不同的数组也可能计算出相同的异或结果。例如:[ 1100, 0011] 的异或结果为 1111,但是 [1010, 0101 ] 的异或结果也是 1111,但它们确实是两个完全不同的数组

这很像布隆过滤器,它们都不要求绝对的准确率,但是对时间、空间复杂度却有很高要求,事实上,我觉得这两个方法从某种角度来看近乎是同一个方法。

我想到一个可能的应用:做数据校验

我们知道,数据在网络传输过程中是不稳定的,从小的说,一般数据报文在传输时会在报文头部或者尾部添加校验位,用于校验数据传输过程中是否出现错误,往大了说,一般在下载东西的时候,别人不仅会提供下载文件,还会提供一个校验文件,也是校验下载的内容是否完整的,这个校验文件一般使用一些数字签名算法例如md5等,我想应该也可以使用这种异或的简单算法:先将待下载文件平均切分成n份,然后对它们做异或,最终得到的异或结果就可以当作校验文件。用户下载完文件后,也将文件切分为n份,然后将得到的异或结果与别人提供的结果做对比,达到校验完整性的作用。

我觉得这个东西可能在加密方面也能有点应用,我甚至觉得它应该可以用来神经网络上,这样应该可以大大加快模型的推理速度

例如卷积神经网络,它本质就是一个模式匹配的过程,那异或不也是模式匹配吗,稍有不同的是,在卷积过程中,相同则为1,不同则为0,这与异或正好相反,不过可以使用 1-x 的方法来解决

再者,我甚至可以认为对多个数据异或的过程就是一个编码的过程,相当于做了数据降维,这个过程是否可以用在 encoder-decoder 模式的网络中

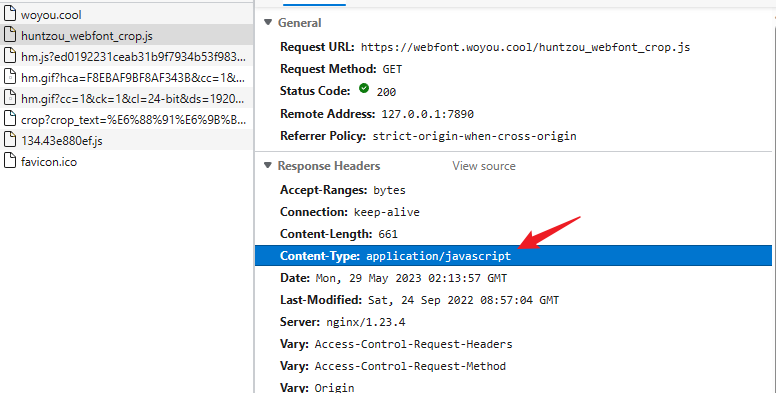

自己的键盘

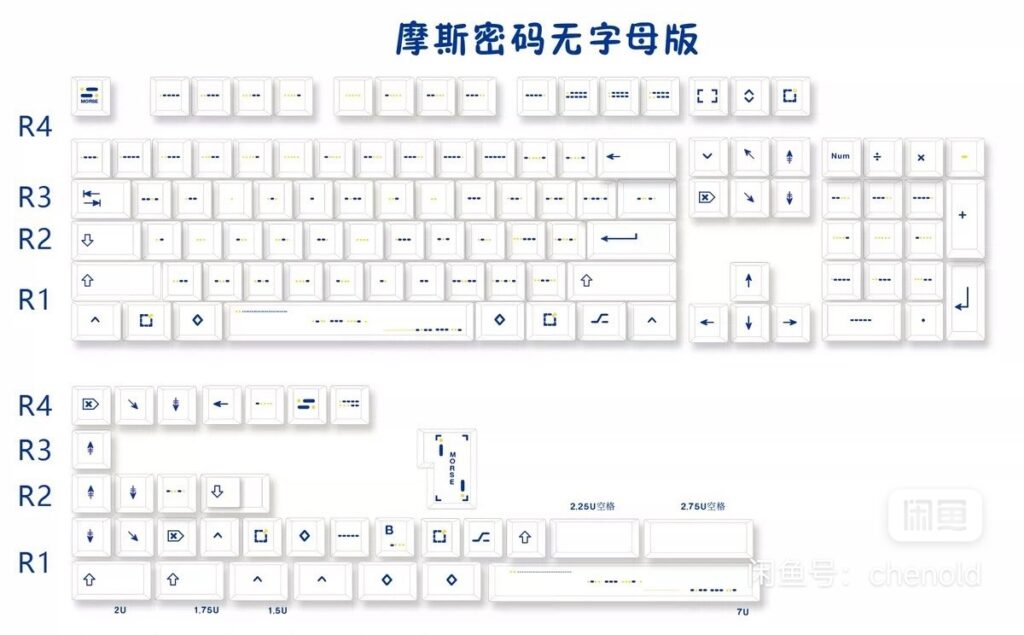

闲鱼上买了一盒摩斯码键帽,卖家很久都没发货,中途我还去淘宝等地方找了下,到处都没卖的,也就闲鱼上有一家卖,但是他一直不发货,我一度以为他也是代购的,就在我正准备发起退款前夕,卖家发货了。

“z”和“k”和“7”键印错了,“UP”和“DOWN”键也是也没有对应高度的

一开始用还真有点不习惯,但后面应该会慢慢习惯的,一旦用惯了后,这就是我的专属键盘了——别人想用也都不会用

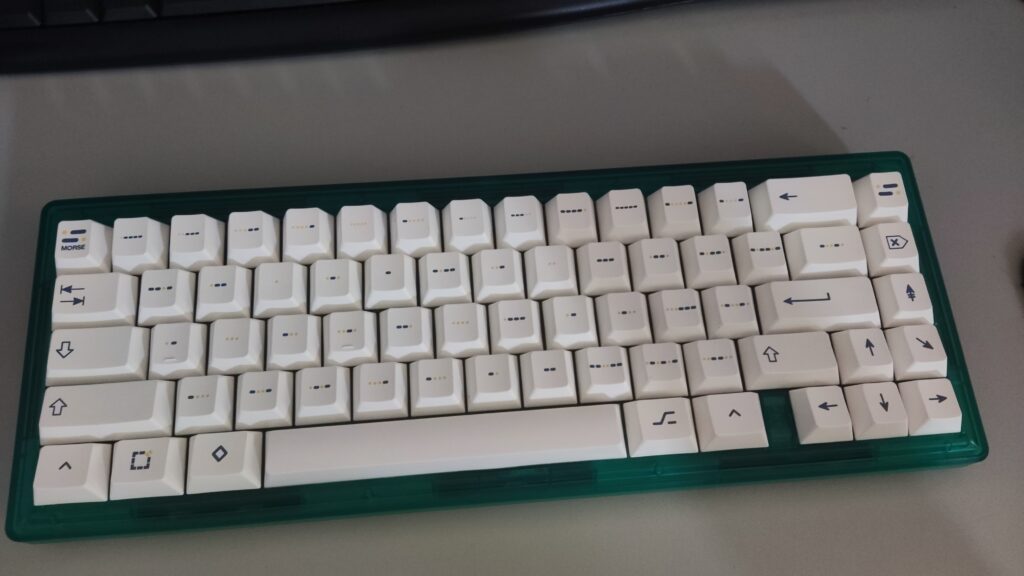

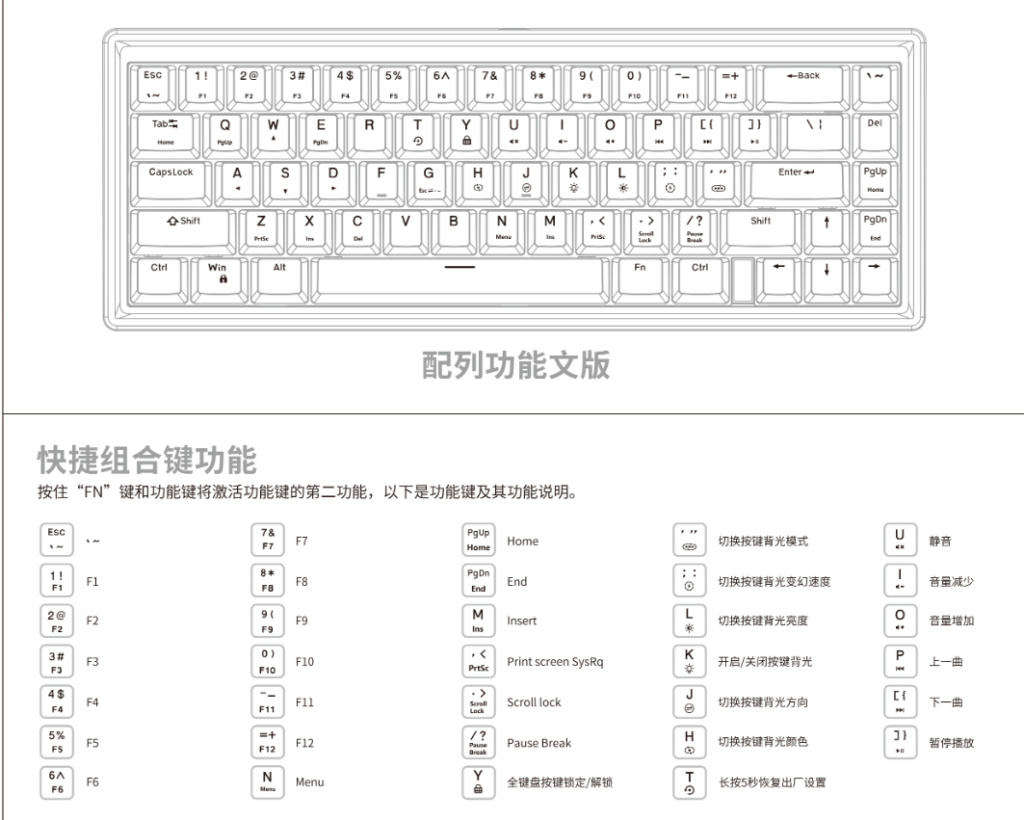

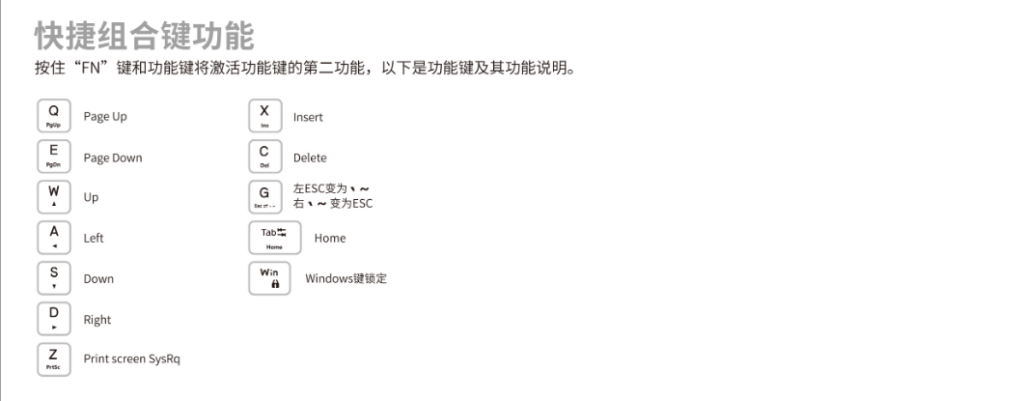

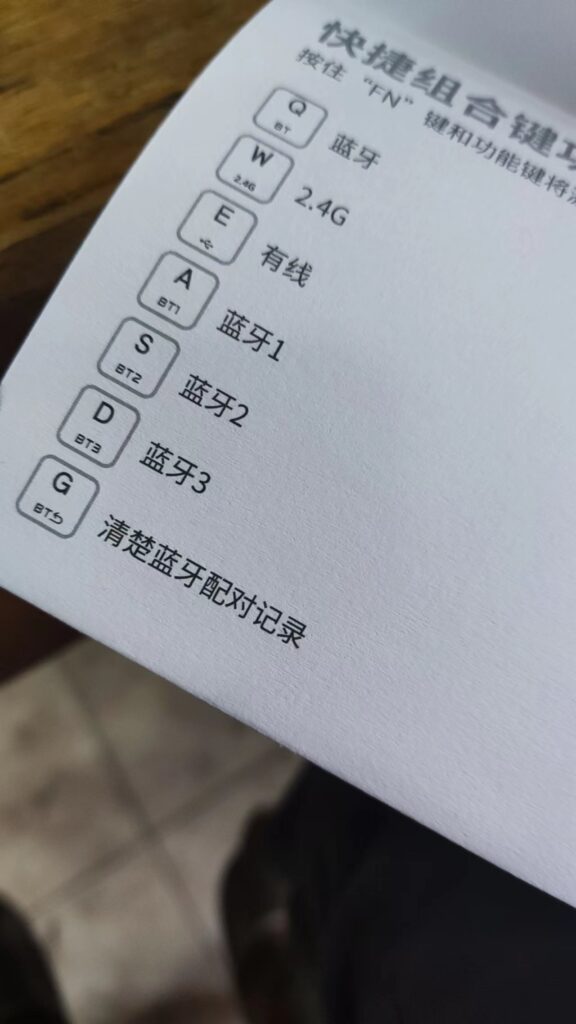

这里记录一下键盘的一些设置方法和按键对应关系:

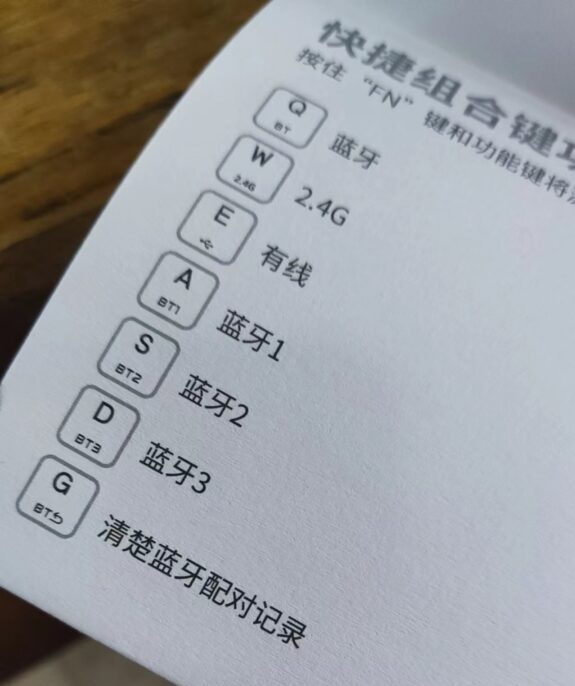

LM67键盘套件蓝牙连接方法:按 FN+Q 切换到蓝牙模式,短按 FN+A/S/D 切换三种蓝牙设备,长按则是重新配对,长按 FN+G 清除所有蓝牙配对记录

说明书来源:http://www.teamwolf.cc/home/services

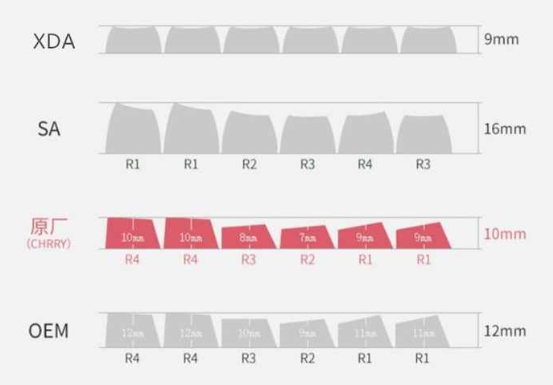

按键高度:

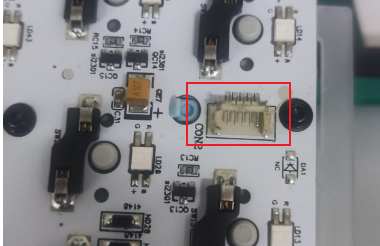

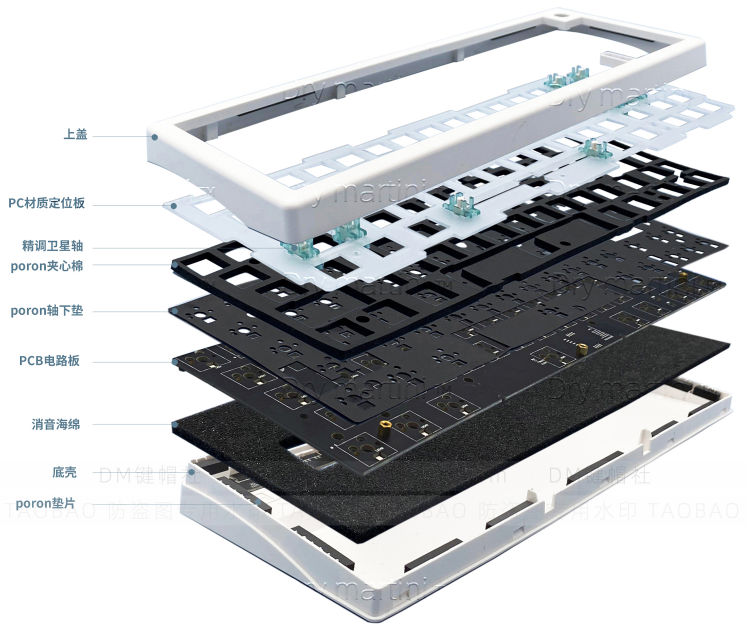

LM67:客制化的第一顿毒打

完全无用的gasket

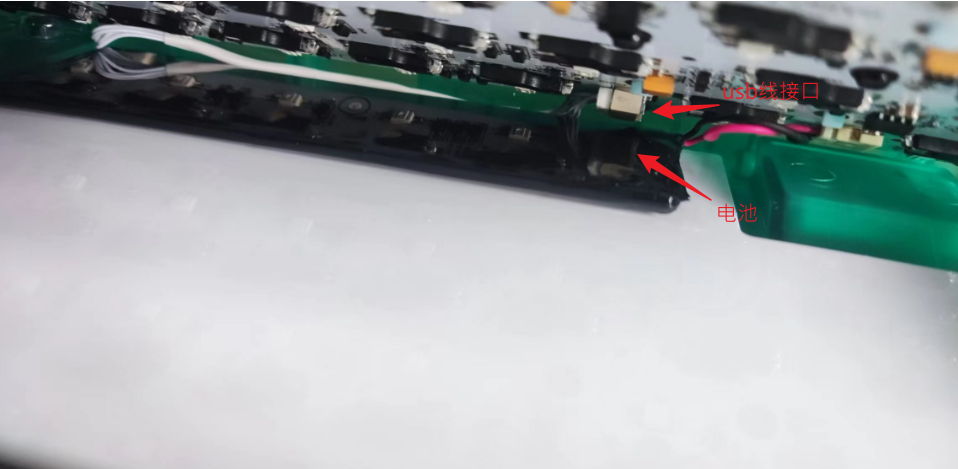

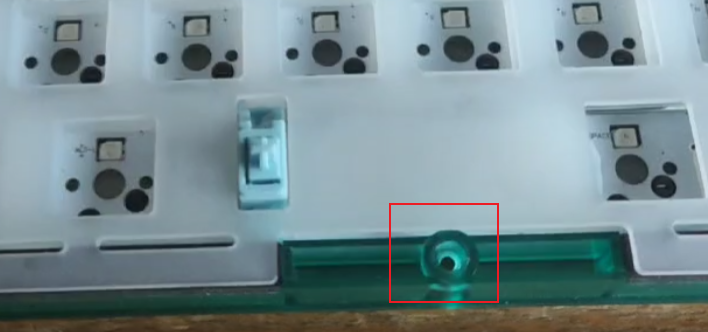

下面这张图是我将pcb板掀开的图,可以很清晰看到usb线的接口突出很大一块,由于太高了,它会直接将整块pcb顶在电池上。

进而导致这个pcb是不平衡的,被额外顶起来很高

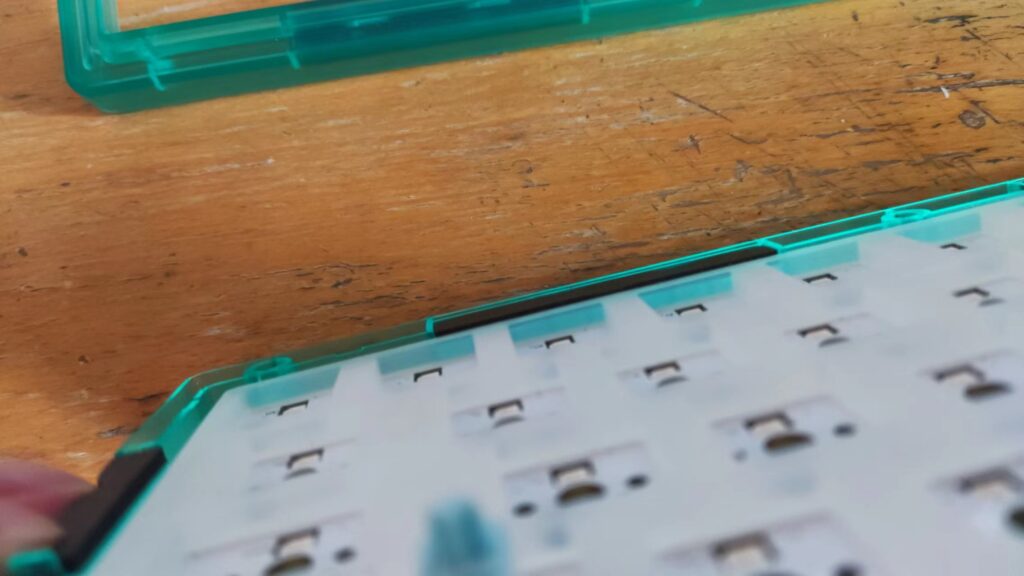

加上外壳本身就很矮,再加上gasket减震垫(图中四周黑色的长条)本身就薄,所以定位板实际上并没有压在减震垫上,而是直接压在消音垫上的。

下图为左边正常一点的gasket减震垫高度,可以看到它其实还是比消音垫要高一点的

下图为右边被顶起来的部分,可以明显看到gasket减震垫与消音垫持平甚至更低了,所以这部分定位板压根没有压在减震垫上。

下面这个视频中,键盘左边相对来说是可以压下去一点的,但右边由于整体被顶起来了,所以根本压不下去

但实际上我感觉,之所以能按压下去,都是因为这个定位板本身就是软的

另外这块定位板本身大小也是有问题的,它太大了,以至于外壳底板上的几个螺丝孔都是压在它下面的,所以这个定位板前边缘都是被底壳撑着的

再另外就是上盖也是,由于gasket减震垫太薄,加上定位板太大,整个上盖压下去之后,定位板边缘几乎都是直接被上盖压着的,减震垫根本没起作用

综上所述,我可以说,这个gasket完全就是无用的

以下为我的一些解决方法:

打磨轴下的消音垫,把凸起来那部分削薄一些(或者直接换薄的填充物)

将与螺丝孔接触部分的定位板削一下

将定位板边缘都削一下,缩小一圈

买点厚的gasket减震垫,重新垫一下

将电池卧插削一下

这是削之后的效果

严重松动

pcb没有和底板固定,但也太松了,导致每次拨动pcb上的开关时,整个板子都会跟着一起动

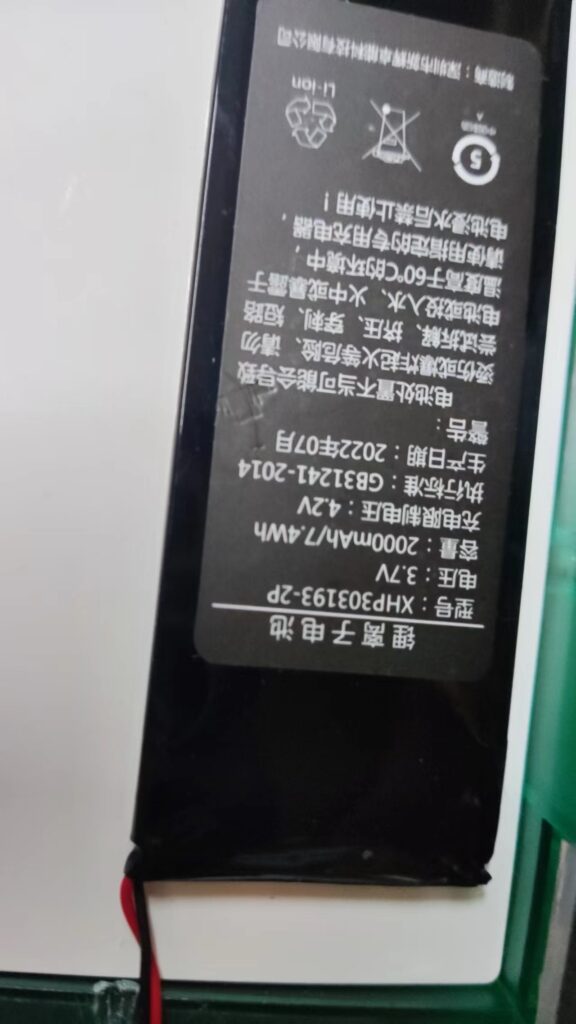

电池

可以明显感觉,这个外壳根本做的时候根本没有考虑到电池的问题,它使用两块电池并联,但由于底部位置很小而且是个梯形空间,所以这两个电池必须非常薄,而且只能放在靠底壳尾部的位置,再大一点都不行,然后在中间加强筋的位置直接烧出一个槽,用于过线。事实上这个槽烧不烧都可以,因为pcb已经被顶起来了,压根压不到这个线。

再者就是这个板子是直接使用的gas67的板子,它根本没有查看电量方法。如果是一开始有考虑使用电池的话,应该不至于连这个功能都没有。

宣传的是使用了2000毫安时的电池,但是它使用的是两块电池并联的,而其中一块贴有标识的电池上写的是2000mAh

但它有两块电池,是不是就是4000?哦 我想到了,其实这两块电池是一起的,也就是那个标识就是指的两块电池的,难怪只有一块电池有标识。

说明书

我想连一下蓝牙,发现包装里放了两个一样的说明书,关键是这个说明书什么都没说,就说这个东西可以连蓝牙,怎么连,提都没提。

说明书字都打错了,可想而知他们是以一种什么心态在做东西

BTW,我也是看了其他型号的键盘说明书才猜出蓝牙是如何连接的:先按 FN+Q 切到蓝牙模式,再按FN+A/S/D切换三个不同的蓝牙设备,长按FN+A/S/D则是重新配对,长按FN+G则是清除所有配对信息

总结

这个套件是从Gas67直接改过来的,只不过Gas67不支持三模,只支持有线连接,可以很明显地感觉做Gas67时根本没考虑到三模版本,这就是一个用来收割的东西。

尤其是这个主推的 gasket 结构,完全就是没有用的。甚至还使得其他能做好的地方变差了

但是我已经买了,而且我不打算退换,我想这就是命吧,我自己想想办法改改,多折腾折腾,它总是要有个归宿,它已经很可怜了。

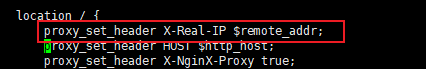

wordpress上传文件:The response is not a valid JSON response

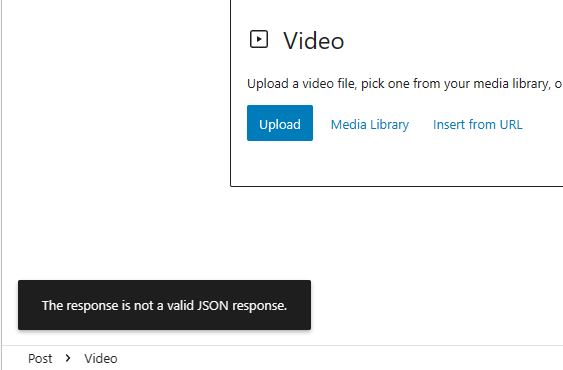

现象

wordpress媒体库中上传文件出错:

Unexpected response from the server. The file may have been uploaded successfully. Check in the Media Library or reload the page.同时,直接在文章页面上传文件也出错:

The response is not a valid JSON response解决

wordpress默认会限制上传文件的大小,但我肯定不是这个问题,我很早就将这个限制修改了。

我在wordpress前使用了nginx做反向代理,问题也就出在这,解决方法:

在nginx的配置文件

http{}模块中修改最大允许的请求体大小client_max_body_size:http { client_max_body_size 256M; server{...} ... }重新加载配置文件或重启nginx即可

参考

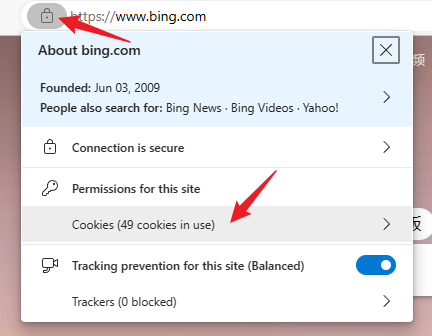

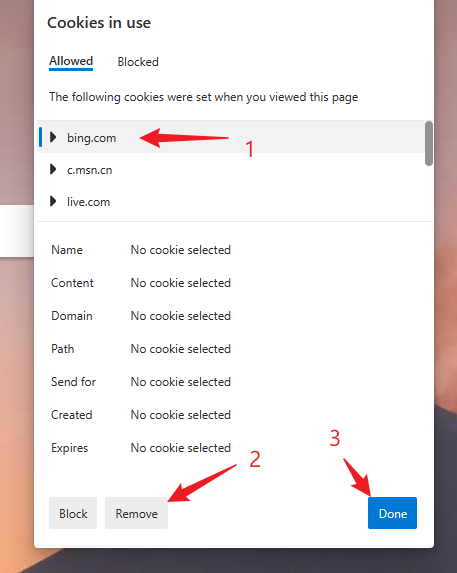

new bing 自动重定向到 bing

现象

已经申请通过newbing的情况下,在浏览器输入 https://bing.com/new 会自动重定向到 https://www.bing.com/

解决

删除

bing.com的cookie其他

注1:使用newbing需要挂梯子

注2:这种解决方法并非永久有效,过段时间又会出现这种情况,仍然这样操作一下就像

客制化键盘

所谓客制化键盘我觉得应该叫模块化键盘,因为其本质是将一个键盘分为 套件、轴体、键帽 三个部分,市面上有很多分别卖这三部分的零售商,所以你可以买回来自由拼接成一块完整的键盘。

键盘的分类

键盘有很多种分类方法,其中最影响体验的就是轴体分类、按键数分类和按键排布位置分类

轴体类别

薄膜键盘、机械键盘、静电容键盘等

按键数量

推荐一个网站:http://kle.geekark.com/,这个网站是用来设计键帽的,但可以选择各种不同的配列直观来看

100%尺寸,104或108键,全功能键盘。

80%尺寸,87键,去掉了数字区域。

75%尺寸,82/76键,将几个光标键整合到主键区。

60%尺寸,61键,只剩下主键区。